text

stringlengths 20

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

# С# для AS3 разработчиков. Часть 1: Основы классов

*Перевод статьи [From AS3 to C#, Part 1: Class Basics](http://jacksondunstan.com/articles/2634)*

Эта статья поможет разобраться в основах C# тем AS3 разработчикам, которые решили переключиться на Unity, но абсолютно не знакомы с программированием на C#.

Начнём с главного: С# файлы имеют расширение .cs, а не .as как AS3 файлы. Внутри файлов вы найдёте описание классов, из которых состоят приложения (аналогично AS3 файлам). Например, файл MyClass.cs:

```

class MyClass

{

}

```

Название классов в C# подчиняется той же конвенции, что и названия классов в AS3: каждое слово в названии класса должно начинаться с большой буквы, остальная часть названия пишется в нижнем регистре. Как вы могли заметить, базовый синтаксис классов в C# такой же, как у классов в AS3.

Теперь давайте добавим переменную:

```

class MyClass

{

int X;

}

```

Определение переменных в C# отличается от AS3. Вместо var x:int, нужно использовать int X. Конвенция названий говорит, что названия переменных должны начинаться с большой буквы.

Давайте посмотрим на функции:

```

class MyClass

{

void Foo()

{

}

}

```

Функции в C# так же отличаются от функций в AS3. В C# не используется ключевое слово function, возвращаемый тип данный указывается вначале (а не в конце, как это было в AS3), название функций должно начинаться с большой буквы, исходя из конвенции названий.

Функция с входящими параметрами:

```

class MyClass

{

void Foo(int x, int y, int z)

{

}

}

```

Параметры функций, так же, как и в AS3, находятся внутри скобок, но записываются они немного по-другому: вначале тип, потом имя, с пробелом между ними. Конвенция говорит, что названия параметров функций должны начинаться с маленькой буквы.

Как и в AS3, параметры функций могут иметь значения по-умолчанию:

```

class MyClass

{

void Foo(int x = 1, int y = 2, int z = 3)

{

}

}

```

Функция-конструктор:

```

class MyClass

{

MyClass()

{

}

}

```

Как и в AS3, нам не обязательно указывать тип возвращаемого значения для функций-конструкторов. Вообще-то, у вас не получится указать даже тип данных void, как это можно было сделать в AS3. Так же, для объявления этого типа функций, не используется ключевое слово function.

Вы можете иметь больше одной функции-конструктора, это называется «перегрузка» функций:

```

class MyClass

{

MyClass()

{

}

MyClass(int x)

{

}

MyClass(int x, int y, int z)

{

}

}

```

Перезагрузка так же доступна для других функций:

```

class MyClass

{

void Foo()

{

}

void Foo(int x)

{

}

void Foo(int x, int y, int z)

{

}

}

```

Чтобы компилятор мог определить, какая из функций вызывается, необходимо придерживаться 2 правил. Во-первых, вы не можете иметь 2 функции с одинаковыми параметрами:

```

class MyClass

{

void Foo(int x, int y, int z)

{

// Какой-то функционал

}

void Foo(int x, int y, int z)

{

// Какой-то другой функционал

}

}

```

Это же касается тех функций, вызов которых может выглядеть одинаково, если не будет указан один из параметров по-умолчанию:

```

class MyClass

{

void Foo(int x, int y, int z)

{

// Какой-то функционал

}

void Foo(int x, int y, int z, int w = 0)

{

// Какой-то другой функционал

}

}

```

Во-вторых, вы не можете «перегружать» функции по типу данных, который они возвращают:

```

class MyClass

{

int Foo(int x, int y, int z)

{

return 0;

}

uint Foo(int x, int y, int z)

{

return 0;

}

}

```

Придерживаясь этих двух простых правил, вы сможете «перегружать» функции, сколько ваша душа пожелает =)

Как и в AS3, для определения статических функций необходимо добавить ключевое слово static:

```

class MyClass

{

static void Foo()

{

}

}

```

То же самое со статическими переменными:

```

class MyClass

{

static int X;

}

```

Теперь, когда мы знаем, как внутри классов определять классы, переменные, функции и конструкторы, давайте рассмотрим как использовать их:

```

void SomeCode()

{

// Вызов конструктора по-умолчанию (например, без входящих параметров)

MyClass mc = new MyClass()

// Вызов другого конструктора

mc = new MyClass(5);

// Вызов функции

mc.Foo();

// Вызов перегруженной функции

mc.Foo(1, 2, 3);

// Вызов статической функции

MyClass.Foo();

// Получение значения переменной

mc.X;

// Установка значения переменной

mc.X = 1;

// Кстати, однострочные комментарии работают так же, как и в AS3...

/*

... многострочные комментарие тоже.

*/

}

```

Всё это очень похоже на AS3. Обратите внимание, что локальная переменная mc начинается с маленькой буквы, как и параметры функций.

Давайте обсудим модификаторы доступа. Стандартные модификаторы public, private и protected имеют такой же синтаксис и такое же поведение, как и в AS3. Для их использования достаточно просто добавить их перед возвращаемым типом данных функции, типом переменной или ключевым словом class:

```

public class MyClass

{

private int X;

protected void Foo()

{

}

}

```

В C#, как и в AS3, существует модификатор доступа internal, который имеет такое же название, но немного другое поведение (по-сравнению с AS3). В AS3 модификатор internal означает «доступно для текущего класса и других классов в текущем пакете». В C# он означает «доступно для текущего класса и остальных классов в текущей сборке». Я расскажу про понятие «сборки» в других статьях, но пока что, думайте о них, как о группе классов, собранных в одном бинарном файле.

Так же, в C# есть модификатор protected internal, который является комбинацией protected и internal.

В завершении, сравнение описанных особенностей C# и AS3 кода:

| | |

| --- | --- |

|

```

////////

// C# //

////////

/////////////////

// Declaration //

/////////////////

// Class

public class MyClass

{

// Field variable

public int X;

// Class variable

static public int Y;

// Default constructor

public MyClass()

{

}

// Overloaded constructor

public MyClass(int x)

{

}

// Instance function

public void Foo()

{

}

// Overloaded instance function

public void Foo(int x)

{

}

// Class function

static public void Goo()

{

}

// Overloaded class function

static public void Goo(int x)

{

}

}

///////////

// Usage //

///////////

// Call the default constructor

MyClass mc = new MyClass()

// Call a different constructor

mc = new MyClass(5);

// Call an instance function

mc.Foo();

// Call an overloaded instance function

mc.Foo(1);

// Call a static function

MyClass.Goo();

// Call an overloaded static function

MyClass.Goo(1);

// Get an instance variable

mc.X;

// Set an instance variable

mc.X = 1;

// Get a class variable

MyClass.Y;

// Set a class variable

MyClass.Y = 1;

// Single-line comment

/*

Multi-line comment

*/

```

|

```

/////////

// AS3 //

/////////

/////////////////

// Declaration //

/////////////////

// Class

public class MyClass

{

// Field variable

public var x:int;

// Class variable

static public var y:int;

// Default constructor

public function MyClass()

{

}

// Overloaded constructor

// {not supported}

// Instance function

public function foo(): void

{

}

// Overloaded instance function

// {not supported}

// Class function

static public function goo(): void

{

}

// Overloaded class function

// {not supported}

}

///////////

// Usage //

///////////

// Call the default constructor

var mc:MyClass = new MyClass()

// Call a different constructor

mc = new MyClass(5);

// Call an instance function

mc.foo();

// Call an overloaded instance function

// {not supported}

// Call a static function

MyClass.goo();

// Call an overloaded static function

// {not supported}

// Get an instance variable

mc.x;

// Set an instance variable

mc.x = 1;

// Get a class variable

MyClass.y;

// Set a class variable

MyClass.y = 1;

// Single-line comment

/*

Multi-line comment

*/

```

|

Этим завершается первая часть цикла статей «С# для AS3 разработчиков». Следующие статьи будут касаться более сложных тем, включая такие особенности C#, аналоги которых не существуют в AS3.

Оставайтесь на связи!

|

https://habr.com/ru/post/246161/

| null |

ru

| null |

# О безопасности в Meteor и не только (часть 2)

Если вас не испугала [первая часть](http://habrahabr.ru/post/211002/), предлагаю продолжить разговор о механизмах безопасности Meteor. Начав с [loginToken](#loginToken), выдаваемого клиенту, [правил allow/deny](#allow_deny) при модификации базы данных клиентом, коснемся [доверенного и недоверенного кода](#trusted), [серверных методов](#methods), [использования HTTPS и пакета force-ssl](#https), [пакета browser-policy](#policy) (Content Security Policy и X-Frame-Options), и закончим [встроенным механизмом валидации данных](#check) (функция check() и пакет audit-arguments-check).

#### loginToken

После авторизации клиент получает временный токен, авторизующий текущего пользователя, который сохраняется в localStorage:

```

> localStorage.getItem("Meteor.loginToken")

"eEg4T3fNPGLns7MfY"

```

Строго говоря, сохраняется он в объекте [Meteor.\_locaStorage](https://github.com/meteor/meteor/blob/devel/packages/localstorage/localstorage.js), который является оберткой window.localStorage для поддерживающих его браузеров.

Также можно узнать этот токен и через объект Accounts:

```

Accounts._storedLoginToken()

```

Этот же токен сохраняется на сервере в коллекции [Meteor.users](http://docs.meteor.com/#meteor_users):

```

> Meteor.user().services.resume

{

"loginTokens": [ {

"token":"DXC3BqekpPy97fmYs",

"when":"2014-01-31T10:53:54.347Z"

} ]

}

```

Разумеется, в консоли браузера это поле доступно только в том случае, если оно явно опубликовано.

Любой браузер, у которого есть пара токен + идентификатор пользователя, считается авторизованным. Чтобы в этом убедиться, можно залогиниться в браузере и получить текущие loginToken и userId:

```

localStorage.getItem("Meteor.loginToken");

localStorage.getItem("Meteor.userId");

```

Затем установить их в другом браузере:

```

localStorage.setItem("Meteor.loginToken", "'+loginToken+'");

localStorage.setItem("Meteor.userId", "'+userId+'");

```

И через несколько мгновений сессия браузера будет авторизована.

###### Время жизни токена

Токен существует до момента выхода пользователя из системы, либо истечения таймаута, задаваемого параметром (по умолчанию — 60 дней):

```

Accounts.config({loginExpirationInDays: 60})

```

#### Ограничение прав клиента на изменение коллекции — правила [allow](http://docs.meteor.com/#allow)/[deny](http://docs.meteor.com/#deny)

Если мы попробуем изменить поддокумент services, сделать это из браузера не получится:

```

> Meteor.users.update({ _id: Meteor.userId() }, {$set: { "services.test": "test" } })

undefined

update failed: Access denied

```

Происходит это из-за того, что на сервере доступ к данному документу ограничен правилами [allow](http://docs.meteor.com/#allow)/[deny](http://docs.meteor.com/#deny). Посмотрим, как этот механизм реализован в исходниках пакета [accounts-base](https://github.com/meteor/meteor/blob/release/0.7.0.1/packages/accounts-base/accounts_server.js#L668):

```

Meteor.users.allow({

// clients can modify the profile field of their own document, and

// nothing else.

update: function (userId, user, fields, modifier) {

// make sure it is our record

if (user._id !== userId)

return false;

// user can only modify the 'profile' field. sets to multiple

// sub-keys (eg profile.foo and profile.bar) are merged into entry

// in the fields list.

if (fields.length !== 1 || fields[0] !== 'profile')

return false;

return true;

},

fetch: ['_id'] // we only look at _id.

});

```

Из кода видно, что разрешены изменения только документа, userId которого совпадают с текущим пользователем, и можно вносить изменения только в поддокументе profile. Параметр fetch сообщает Meteor, что для проверки полномочий не требуется получать модифицируемый документ целиком (он может быть большим), для проверки достаточно только одного поля \_id. Так как правило allow объялвено только для операции update, операции insert и remove для клиента запрещены:

```

> Meteor.users.insert({})

"qs8HbcSDjgbgb3vgS"

insert failed: Access denied. No allow validators set on restricted collection for method 'insert'.

```

Правилом deny можно запретить операцию, разрешенную allow. Т.е.если одно из правил allow (может задаваться более одного правила) вернуло true, то это разрешение может быть перекрыто, если одно из правил deny вернет true, и запись в этом случае будет запрещена, несмотря на правила allow.

##### Проверка прав доступа к поддокументам

С операцией update возможности проверки несколько ограничены. Например, если необходимо запретить запись в какое-либо поле поддокумента, например, doc.field1, но разрешить в другое его поле, например, doc.field2 нашей коллекции test, сделать это просто так не получится. Посмотрим, какие параметры передаются в этом случае в правило, добавив на сервере вывод входных параметров правил allow и deny:

```

Test.allow({

update: function (userId, document, fields, modifier) {

console.log('Test.allow(): userId:', userId, '; document:', document, '; fields:', fields, '; modifier:' , modifier);

return true;

}

});

Test.deny({

update: function (userId, document, fields, modifier) {

console.log('Test.deny(): userId:', userId, '; document:', document, '; fields:', fields, '; modifier:' , modifier);

return false;

}

});

```

И выполним операцию update для поля doc.field1, предварительно узнав \_id одного из документов (убедитесь, что у коллекции Test нужные поля опубликованы, задав в коде нашего примера переменную projection = {}, иначе результат не будет виден):

```

> Test.findOne({_id: "FG7FaQqYgB7Rs9RDy"})

Object {_id: "FG7FaQqYgB7Rs9RDy", name: "First", value: 1}

> Test.update({_id:"FG7FaQqYgB7Rs9RDy"}, { $set: { "doc.field1": "value1" } } )

undefined

> Test.findOne({_id: "FG7FaQqYgB7Rs9RDy"})

Object {_id: "FG7FaQqYgB7Rs9RDy", name: "First", value: 1, doc: Object}

> Test.findOne({_id: "FG7FaQqYgB7Rs9RDy"}).doc.field1

"value1"

```

В логе сервера будет выведено:

```

I20140131-13:31:27.582(4)? Test.deny(): userId: kL7Fkuk29ci4vz8q4 ; document: { _id: 'FG7FaQqYgB7Rs9RDy', name: 'First', value: 1 } ; fields: [ 'doc' ] ; modifier: { '$set': { 'doc.field1': 'value1' } }

I20140131-13:31:27.582(4)? Test.allow(): userId: kL7Fkuk29ci4vz8q4 ; document: { _id: 'FG7FaQqYgB7Rs9RDy', name: 'First', value: 1 } ; fields: [ 'doc' ] ; modifier: { '$set': { 'doc.field1': 'value1' } }

```

В параметре fields передается пассив полей только самого вернего уровня, т.е.на основании него определить права доступа к полю doc (и всем его поддокументам), но применить разные права к полям doc.field1 и doc.field на основании этого массива невозможно. Для этого можно использовать параметр modifier, в котором передается объект, содержащий операцию MongoDb, и, чтобы не проводить полный анализ операции, разрешить только какой-то жесткий его формат и запрещая все его остальные варианты как-то так:

```

Test.allow({

update: function (userId, user, fields, modifier) {

console.log('Test.allow(): userId:', userId, '; document:', document, '; fields:', fields, '; modifier:' , modifier);

var setData = modifier["$set"];

return setData && Object.keys(setData).length===1 && setData["doc.field1"];

}

});

```

Разумеется, работают правила [allow](http://docs.meteor.com/#allow)/[deny](http://docs.meteor.com/#deny) только если пакет insecure убран из проекта. К слову, эти обработчики также можно использовать для на стороне сервера изменений, производимых клиентом

#### Доверенный и недоверенный код

До сих пор мы изменяли запись по её идентификатору. Дело в том, что клиент не может выполнить операцию update, указывая в селекторе запроса что-либо другое, например:

```

Test.update({ value: 1 }, { $set: { "doc.field1": "value1" } } )

Error: Not permitted. Untrusted code may only update documents by ID. [403]

```

Происходит это из-за того, что Meteor разделяет доверенный и недоверенный код. Доверенным считается код, выполняемый на сервере, включая серверные методы, вызываемые клиентом. Недоверенный — код, выполняемый на стороне клиента в браузере.

Недоверенному коду разрешена модификация документов только по одному, с указанием \_id документа и проверкой правил allow/deny. Также ему запрещена операция upsert (вставка документа при его отстутсвии). Операция remove аналогичным образом может быть применена только к отдельному документу, с указанием его \_id. Подробнее см документацию [docs.meteor.com/#update](http://docs.meteor.com/#update) и [docs.meteor.com/#remove](http://docs.meteor.com/#remove).

#### Серверные методы

В качестве альтернативы прямому доступу клиента к базе данных можно использовать серверные методы. Так как код, выполняемый на сервере, считается доверенным, можно логику критичных операций разместить на сервере, запретив изменения соответствующих коллекций на клиенте. Например, добавим на сервере:

```

Meteor.startup(function() {

Meteor.methods({

testMethod: function(data) {

console.log('testMethod(): data:', data);

return 'testMethod finished (data:',data,')';

}

});

});

```

И вызовем со стороны клиента, передав последним параметром callback, вызываемые при завершении выполнения метода:

```

> Meteor.call('testMethod', 'test data', function(err, result) {console.log(err, result);})

undefined

undefined "testMethod finished (data:test data)"

```

#### HTTPS и пакет [force-ssl](http://docs.meteor.com/#forcessl)

Сам по себе Meteor не включает поддержки HTTPS, и для него необходим промежуточный сервер, терминирующий SSL, на котором размещается сертификат. Встроенный пакет [force-ssl](http://docs.meteor.com/#forcessl) позволяет перенаправить подключение по протоколу HTTP на HTTPS URL, за исключение подключений с localhost.

При использовании Nginx в этом пакете нет необходимости, так как перенаправление можно реализовать следующим образом

**(пример настройки Nginx на localhost в качестве прокси для Meteor, включая генерацию автоподписанного сертификата)**##### Сгенерировать ключ и сертификат

```

$ openssl genrsa -des3 -out localhost.key 1024

$ openssl req -new -key localhost.key -out localhost.csr

Common Name (eg, YOUR name) :localhost

$ openssl x509 -req -days 1024 -in localhost.csr -signkey localhost.key -out localhost.crt

```

Скопируем сертификат и ключ в папку /etc/nginx/ssl

```

$ mkdir /etc/nginx/ssl

$ cp ./localhost.key /etc/nginx/ssl

$ cp ./localhost.crt /etc/nginx/ssl

```

##### Конфигурация Nginx

Создать файл /etc/nginx/sites-available/meteor.conf (если Nginx ставится «с нуля», необходимо удалить или перенастроить расположенный в том же каталоге файл default, в котором прописаны те же порты):

```

server {

listen 80;

server_name localhost;

# $scheme will get the http protocol

# and 301 is best practice for tablet, phone, desktop and seo

# return 301 $scheme://example.com$request_uri;

# We want to redirect people to the https site when they come to the http site.

return 301 https://localhost$request_uri;

}

server {

listen 443;

server_name localhost;

client_max_body_size 500M;

access_log /var/log/nginx/meteorapp.access.log;

error_log /var/log/nginx/meteorapp.error.log;

location / {

proxy_pass http://localhost:3000;

proxy_set_header X-Real-IP $remote_addr;

proxy_http_version 1.1;

proxy_set_header Upgrade $http_upgrade;

proxy_set_header Connection "upgrade";

}

ssl on;

ssl_certificate /etc/nginx/ssl/localhost.crt;

ssl_certificate_key /etc/nginx/ssl/localhost.key;

ssl_verify_depth 3;

}

```

Создать ссылку:

```

ln -s /etc/nginx/sites-available/meteor.conf /etc/nginx/sites-enabled/meteor.conf

```

Рестартовать Nginx:

```

$ sudo service nginx restart

```

#### Пакет browser-policy, Content Security Policy и X-Frame-Options

Фактически за [browser-policy](http://docs.meteor.com/#browserpolicy) скрывается два других пакета, каждый из которых может быть использован по отдельности, browser-policy-content и browser-policy-framing. Первый из них предоставляет интерфейс для определения правил [Content Security Policy](https://developer.mozilla.org/en-US/docs/Security/CSP/Introducing_Content_Security_Policy), с помощью которых задается белый список источники для загрузки различных типов ресурсов. Второй — параметра [X-Frame-Origin](https://developer.mozilla.org/en-US/docs/HTTP/X-Frame-Options), разрешающего отображать страницу внутри тегов frame или iframe, в зависимости от URI сайта, который пытаетcя это делать (на данный момент указание URI источника в X-Frame-Origin поддерживается только Firefox и IE 8+).

Добавление пакета включает политику по умолчанию, при этом загрузка контента разрешается только с того же сайта, что и сама страница, запросы XMLHTTPRequest и соединения WebSocket могут направляться на любый сайты. Кроме этого, блокируются функции типа eval() и приложение может быть включено в frame и iframe только тем же сайтом, с которого оно загружено.

При этом к заголовку ответа сервера при загрузке страницы добавляются следующие параметры:

```

content-security-policy: default-src 'self'; script-src 'self' 'unsafe-inline'; connect-src * 'self'; img-src data: 'self'; style-src 'self' 'unsafe-inline';

x-frame-options: SAMEORIGIN

```

И, в нашем примере, изображения пользователя с внешних сайтов (Google и Facebook) перестанут отображаться со следующим сообщением в консоли:

```

Refused to load the image 'https://lh6.googleusercontent.com/-aCxpjiDMNcM/AAAAAAAAAAI/AAAAAAAAJMY/9hZytqLLZ6Q/photo.jpg' because it violates the following Content Security Policy directive: "img-src data: 'self'".

```

Чтобы изображения с внешних сайтов снова начали отображаться, необходимо на сервере добавить следующие строки:

```

Meteor.startup(function() {

BrowserPolicy.content.allowImageOrigin("https://*.googleusercontent.com");

BrowserPolicy.content.allowImageOrigin("http://profile.ak.fbcdn.net");

BrowserPolicy.content.allowImageOrigin("http://graph.facebook.com");

});

```

При этом заголовок станет выглядеть так:

```

content-security-policy: default-src 'self'; script-src 'self' 'unsafe-inline'; connect-src * 'self'; img-src data: 'self' https://*.googleusercontent.com http://profile.ak.fbcdn.net http://graph.facebook.com; style-src 'self' 'unsafe-inline';

x-frame-options: SAMEORIGIN

```

В дополнение к ограничениям, установленным по умолчанию, в документации Meteor рекомендуется запрещать выполнение inline Javascript на странице, вызвав BrowserPolicy.content.disallowInlineScripts() на стороне сервера (конечно, если не используется inline Javascript).

#### Валидация данных: функция [check()](http://docs.meteor.com/#check) и пакет [audit-arguments-check](http://docs.meteor.com/#auditargumentchecks)

В Meteor предусмотрен механизм валидации данных, передаваемых серверным методам и функциям publish. Для этого предназначна функция [check()](http://docs.meteor.com/#check), которой передается проверяемое значние и шаблон для проверки. Шаблон может быть явным указанием типа, либо объектом [Match](http://docs.meteor.com/#match), определяющим более сложные правила проверки (см.http://docs.meteor.com/#match)

Установка пакета [audit-argument-checks](http://docs.meteor.com/#auditargumentchecks) блокирует выполнение методов и функций публикации, которым были переданы данные, не прошедшие валидации.

Если валидация не требуется, можно вызвать функцию check со следующим параметром

```

check(arguments, [Match.Any])

```

Добавим пакет

```

$ mrt add audit-argument-checks

```

Теперь попытка вызвать серверный метод вернет ошибку:

```

> Meteor.call('testMethod', 'test data', function(err, result) {console.log(err, result);})

undefined

errorClass {error: 500, reason: "Internal server error", details: undefined, message: "Internal server error [500]", errorType:"Meteor.Error"…}

undefined

```

И на сервере:

```

Exception while invoking method 'testMethod' Error: Did not check() all arguments during call to 'testMethod'

```

После добавления валидации в серверный метод он вновь начнет корректно отрабатывать:

```

check(data, String);

```

#### Вместо заключения

Пытаясь поделиться своими наработками я совершенно не заметил, насколько большой по объему получился материал, при том, что по сути своей смог затронуть только очень и очень небольшую часть Meteor.

Надеюсь, этот текст поможет поближе познакомиться с Meteor и узнать о нем что-то новое.

|

https://habr.com/ru/post/211020/

| null |

ru

| null |

# Indexes in PostgreSQL — 4 (Btree)

We've already discussed PostgreSQL [indexing engine](https://habr.com/ru/company/postgrespro/blog/441962/) and [interface of access methods](https://habr.com/ru/company/postgrespro/blog/442546/), as well as [hash index](https://habr.com/post/442776/), one of access methods. We will now consider B-tree, the most traditional and widely used index. This article is large, so be patient.

Btree

=====

Structure

---------

B-tree index type, implemented as «btree» access method, is suitable for data that can be sorted. In other words, «greater», «greater or equal», «less», «less or equal», and «equal» operators must be defined for the data type. Note that the same data can sometimes be sorted differently, which [takes us back](https://habr.com/ru/company/postgrespro/blog/442546) to the concept of operator family.

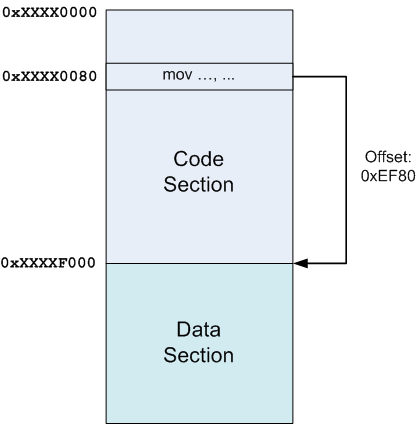

As always, index rows of the B-tree are packed into pages. In leaf pages, these rows contain data to be indexed (keys) and references to table rows (TIDs). In internal pages, each row references a child page of the index and contains the minimal value in this page.

B-trees have a few important traits:

* B-trees are balanced, that is, each leaf page is separated from the root by the same number of internal pages. Therefore, search for any value takes the same time.

* B-trees are multi-branched, that is, each page (usually 8 KB) contains a lot of (hundreds) TIDs. As a result, the depth of B-trees is pretty small, actually up to 4–5 for very large tables.

* Data in the index is sorted in nondecreasing order (both between pages and inside each page), and same-level pages are connected to one another by a bidirectional list. Therefore, we can get an ordered data set just by a list walk one or the other direction without returning to the root each time.

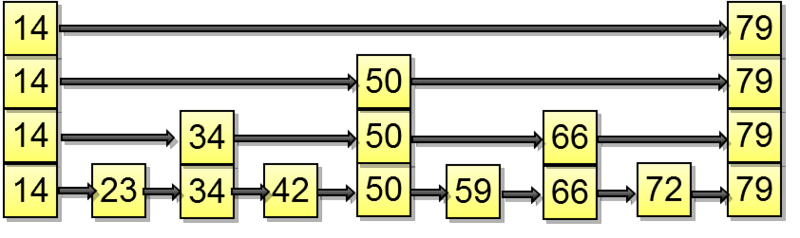

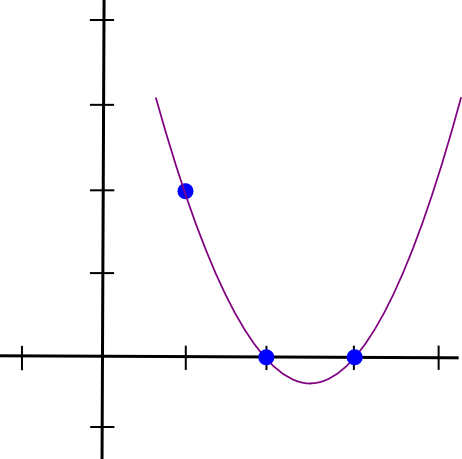

Below is a simplified example of the index on one field with integer keys.

The very first page of the index is a metapage, which references the index root. Internal nodes are located below the root, and leaf pages are in the bottommost row. Down arrows represent references from leaf nodes to table rows (TIDs).

### Search by equality

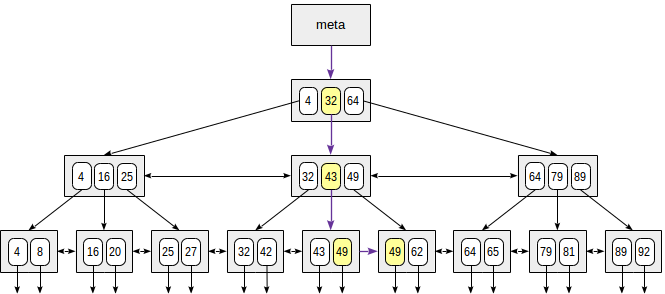

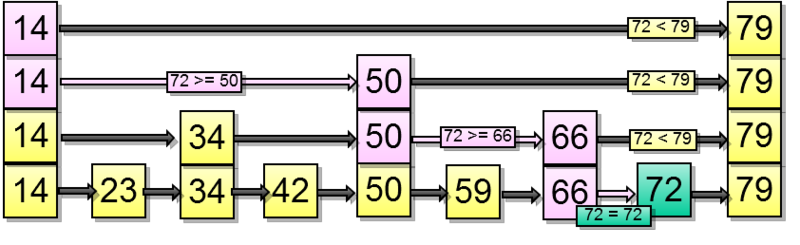

Let's consider search of a value in a tree by condition "*indexed-field* = *expression*". Say, we are interested in the key of 49.

The search starts with the root node, and we need to determine to which of the child nodes to descend. Being aware of the keys in the root node (4, 32, 64), we therefore figure out the value ranges in child nodes. Since 32 ≤ 49 < 64, we need to descend to the second child node. Next, the same process is recursively repeated until we reach a leaf node from which the needed TIDs can be obtained.

In reality, a number of particulars complicate this seemingly simple process. For example, an index can contain non-unique keys and there can be so many equal values that they do not fit one page. Getting back to our example, it seems that we should descend from the internal node over the reference to the value of 49. But, as clear from the figure, this way we will skip one of the «49» keys in the preceding leaf page. Therefore, once we've found an exactly equal key in an internal page, we have to descend one position left and then look through index rows of the underlying level from left to right in search of the sought key.

(Another complication is that during the search other processes can change the data: the tree can be rebuilt, pages can be split into two, etc. All algorithms are engineered for these concurrent operations not to interfere with one another and not to cause extra locks wherever possible. But we will avoid expanding on this.)

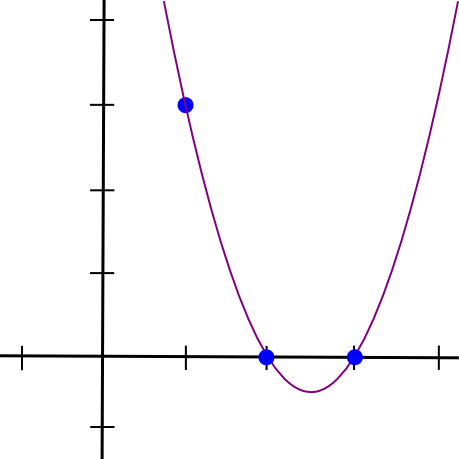

### Search by inequality

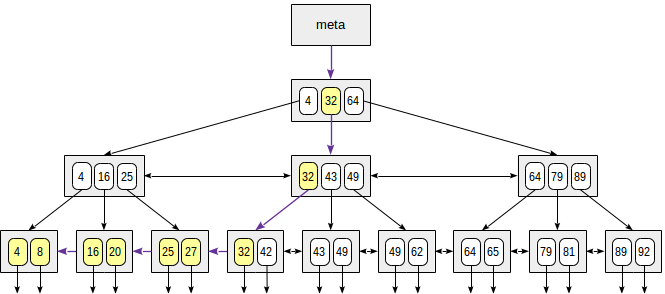

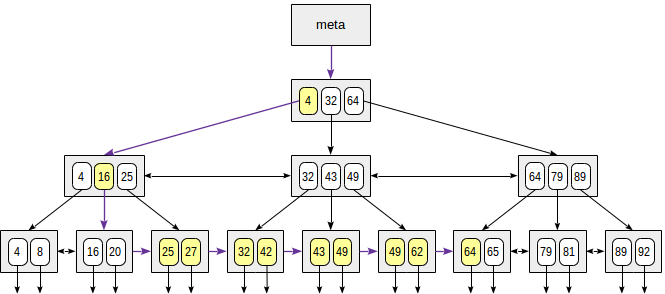

When searching by the condition "*indexed-field* ≤ *expression*" (or "*indexed-field* ≥ *expression*"), we first find a value (if any) in the index by the equality condition "*indexed-field* = *expression*" and then walk through leaf pages in the appropriate direction to the end.

The figure illustrates this process for n ≤ 35:

The «greater» and «less» operators are supported in a similar way, except that the value initially found must be dropped.

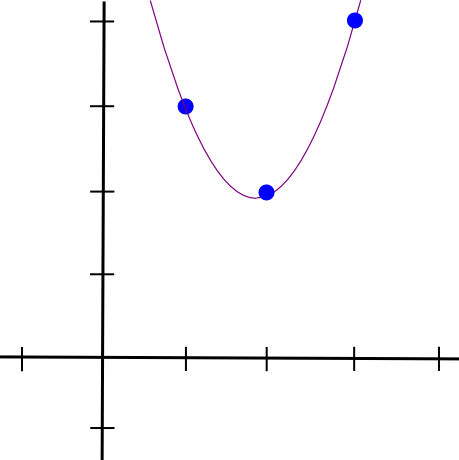

### Search by range

When searching by range "*expression1* ≤ *indexed-field* ≤ *expression2*", we find a value by condition "*indexed-field* = *expression1*", and then keep walking through leaf pages while the condition "*indexed-field* ≤ *expression2*" is met; or vice versa: start with the second expression and walk in an opposite direction until we reach the first expression.

The figure shows this process for condition 23 ≤ n ≤ 64:

Example

-------

Let's look at an example of what query plans look like. As usual, we use the demo database, and this time we will consider the aircraft table. It contains as few as nine rows, and the planner would choose not to use the index since the entire table fits one page. But this table is interesting to us for an illustrative purpose.

```

demo=# select * from aircrafts;

```

```

aircraft_code | model | range

---------------+---------------------+-------

773 | Boeing 777-300 | 11100

763 | Boeing 767-300 | 7900

SU9 | Sukhoi SuperJet-100 | 3000

320 | Airbus A320-200 | 5700

321 | Airbus A321-200 | 5600

319 | Airbus A319-100 | 6700

733 | Boeing 737-300 | 4200

CN1 | Cessna 208 Caravan | 1200

CR2 | Bombardier CRJ-200 | 2700

(9 rows)

```

```

demo=# create index on aircrafts(range);

demo=# set enable_seqscan = off;

```

(Or explicitly, «create index on aircrafts using btree(range)», but it's a B-tree that is built by default.)

Search by equality:

```

demo=# explain(costs off) select * from aircrafts where range = 3000;

```

```

QUERY PLAN

---------------------------------------------------

Index Scan using aircrafts_range_idx on aircrafts

Index Cond: (range = 3000)

(2 rows)

```

Search by inequality:

```

demo=# explain(costs off) select * from aircrafts where range < 3000;

```

```

QUERY PLAN

---------------------------------------------------

Index Scan using aircrafts_range_idx on aircrafts

Index Cond: (range < 3000)

(2 rows)

```

And by range:

```

demo=# explain(costs off) select * from aircrafts

where range between 3000 and 5000;

```

```

QUERY PLAN

-----------------------------------------------------

Index Scan using aircrafts_range_idx on aircrafts

Index Cond: ((range >= 3000) AND (range <= 5000))

(2 rows)

```

Sorting

-------

Let's once again emphasize the point that with any kind of scan (index, index-only, or bitmap), «btree» access method returns ordered data, which we can clearly see in the above figures.

Therefore, if a table has an index on the sort condition, the optimizer will consider both options: index scan of the table, which readily returns sorted data, and sequential scan of the table with subsequent sorting of the result.

### Sort order

When creating an index we can explicitly specify the sort order. For example, we can create an index by flight ranges this way in particular:

```

demo=# create index on aircrafts(range desc);

```

In this case, larger values would appear in the tree on the left, while smaller values would appear on the right. Why can this be needed if we can walk through indexed values in either direction?

The purpose is multi-column indexes. Let's create a view to show aircraft models with a conventional division into short-, middle-, and long-range craft:

```

demo=# create view aircrafts_v as

select model,

case

when range < 4000 then 1

when range < 10000 then 2

else 3

end as class

from aircrafts;

demo=# select * from aircrafts_v;

```

```

model | class

---------------------+-------

Boeing 777-300 | 3

Boeing 767-300 | 2

Sukhoi SuperJet-100 | 1

Airbus A320-200 | 2

Airbus A321-200 | 2

Airbus A319-100 | 2

Boeing 737-300 | 2

Cessna 208 Caravan | 1

Bombardier CRJ-200 | 1

(9 rows)

```

And let's create an index (using the expression):

```

demo=# create index on aircrafts(

(case when range < 4000 then 1 when range < 10000 then 2 else 3 end),

model);

```

Now we can use this index to get data sorted by both columns in ascending order:

```

demo=# select class, model from aircrafts_v order by class, model;

```

```

class | model

-------+---------------------

1 | Bombardier CRJ-200

1 | Cessna 208 Caravan

1 | Sukhoi SuperJet-100

2 | Airbus A319-100

2 | Airbus A320-200

2 | Airbus A321-200

2 | Boeing 737-300

2 | Boeing 767-300

3 | Boeing 777-300

(9 rows)

```

```

demo=# explain(costs off)

select class, model from aircrafts_v order by class, model;

```

```

QUERY PLAN

--------------------------------------------------------

Index Scan using aircrafts_case_model_idx on aircrafts

(1 row)

```

Similarly, we can perform the query to sort data in descending order:

```

demo=# select class, model from aircrafts_v order by class desc, model desc;

```

```

class | model

-------+---------------------

3 | Boeing 777-300

2 | Boeing 767-300

2 | Boeing 737-300

2 | Airbus A321-200

2 | Airbus A320-200

2 | Airbus A319-100

1 | Sukhoi SuperJet-100

1 | Cessna 208 Caravan

1 | Bombardier CRJ-200

(9 rows)

```

```

demo=# explain(costs off)

select class, model from aircrafts_v order by class desc, model desc;

```

```

QUERY PLAN

-----------------------------------------------------------------

Index Scan BACKWARD using aircrafts_case_model_idx on aircrafts

(1 row)

```

However, we cannot use this index to get data sorted by one column in descending order and by the other column in ascending order. This will require sorting separately:

```

demo=# explain(costs off)

select class, model from aircrafts_v order by class ASC, model DESC;

```

```

QUERY PLAN

-------------------------------------------------

Sort

Sort Key: (CASE ... END), aircrafts.model DESC

-> Seq Scan on aircrafts

(3 rows)

```

(Note that, as a last resort, the planner chose sequential scan regardless of «enable\_seqscan = off» setting made earlier. This is because actually this setting does not forbid table scanning, but only sets its astronomic cost — please look at the plan with «costs on».)

To make this query use the index, the latter must be built with the needed sort direction:

```

demo=# create index aircrafts_case_asc_model_desc_idx on aircrafts(

(case

when range < 4000 then 1

when range < 10000 then 2

else 3

end) ASC,

model DESC);

demo=# explain(costs off)

select class, model from aircrafts_v order by class ASC, model DESC;

```

```

QUERY PLAN

-----------------------------------------------------------------

Index Scan using aircrafts_case_asc_model_desc_idx on aircrafts

(1 row)

```

### Order of columns

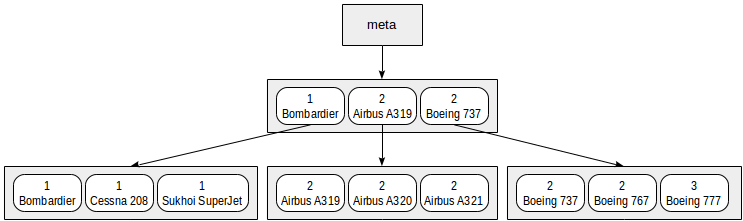

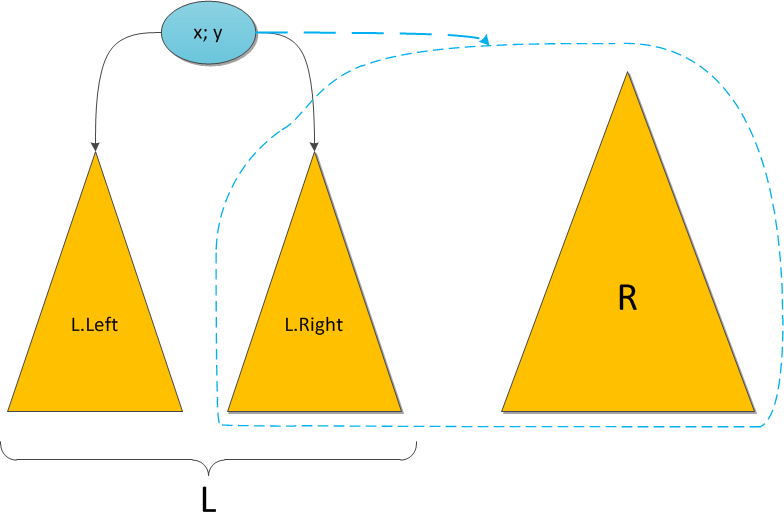

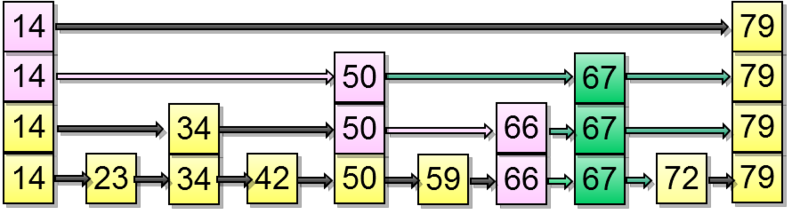

Another issue that arises when using multi-column indexes is the order of listing columns in an index. For B-tree, this order is of huge importance: the data inside pages will be sorted by the first field, then by the second one, and so on.

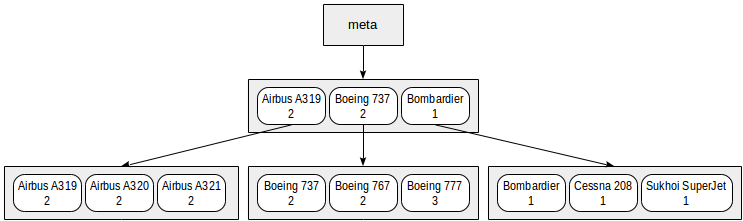

We can represent the index that we built on range intervals and models in a symbolic way as follows:

Actually such a small index will for sure fit one root page. In the figure, it is deliberately distributed among several pages for clarity.

It is clear from this chart that search by predicates like «class = 3» (search only by the first field) or «class = 3 and model = 'Boeing 777-300'» (search by both fields) will work efficiently.

However, search by the predicate «model = 'Boeing 777-300'» will be way less efficient: starting with the root, we cannot determine to which child node to descend, therefore, we will have to descend to all of them. This does not mean that an index like this cannot ever be used — its efficiency is at issue. For example, if we had three classes of aircraft and a great many models in each class, we would have to look through about one third of the index and this might have been more efficient than the full table scan… or not.

However, if we create an index like this:

```

demo=# create index on aircrafts(

model,

(case when range < 4000 then 1 when range < 10000 then 2 else 3 end));

```

the order of fields will change:

With this index, search by the predicate «model = 'Boeing 777-300'» will work efficiently, but search by the predicate «class = 3» will not.

### NULLs

«btree» access method indexes NULLs and supports search by conditions IS NULL and IS NOT NULL.

Let's consider the table of flights, where NULLs occur:

```

demo=# create index on flights(actual_arrival);

demo=# explain(costs off) select * from flights where actual_arrival is null;

```

```

QUERY PLAN

-------------------------------------------------------

Bitmap Heap Scan on flights

Recheck Cond: (actual_arrival IS NULL)

-> Bitmap Index Scan on flights_actual_arrival_idx

Index Cond: (actual_arrival IS NULL)

(4 rows)

```

NULLs are located on one or the other end of leaf nodes depending on how the index was created (NULLS FIRST or NULLS LAST). This is important if a query includes sorting: the index can be used if the SELECT command specifies the same order of NULLs in its ORDER BY clause as the order specified for the built index (NULLS FIRST or NULLS LAST).

In the following example, these orders are the same, therefore, we can use the index:

```

demo=# explain(costs off)

select * from flights order by actual_arrival NULLS LAST;

```

```

QUERY PLAN

--------------------------------------------------------

Index Scan using flights_actual_arrival_idx on flights

(1 row)

```

And here these orders are different, and the optimizer chooses sequential scan with subsequent sorting:

```

demo=# explain(costs off)

select * from flights order by actual_arrival NULLS FIRST;

```

```

QUERY PLAN

----------------------------------------

Sort

Sort Key: actual_arrival NULLS FIRST

-> Seq Scan on flights

(3 rows)

```

To use the index, it must be created with NULLs located at the beginning:

```

demo=# create index flights_nulls_first_idx on flights(actual_arrival NULLS FIRST);

demo=# explain(costs off)

select * from flights order by actual_arrival NULLS FIRST;

```

```

QUERY PLAN

-----------------------------------------------------

Index Scan using flights_nulls_first_idx on flights

(1 row)

```

Issues like this are certainly caused by NULLs not being sortable, that is, the result of comparison for NULL and any other value is undefined:

```

demo=# \pset null NULL

demo=# select null < 42;

```

```

?column?

----------

NULL

(1 row)

```

This runs counter to the concept of B-tree and does not fit into the general pattern. NULLs, however, play such an important role in databases that we always have to make exceptions for them.

Since NULLs can be indexed, it is possible to use an index even without any conditions imposed on the table (since the index contains information on all table rows for sure). This may make sense if the query requires data ordering and the index ensures the order needed. In this case, the planner can rather choose index access to save on separate sorting.

Properties

----------

Let's look at properties of «btree» access method (queries [have already been provided](https://habr.com/ru/company/postgrespro/blog/442546/)).

```

amname | name | pg_indexam_has_property

--------+---------------+-------------------------

btree | can_order | t

btree | can_unique | t

btree | can_multi_col | t

btree | can_exclude | t

```

As we've seen, B-tree can order data and supports uniqueness — and this is the only access method to provide us with properties like these. Multicolumn indexes are also permitted, but other access methods (although not all of them) may also support such indexes. We will discuss support of EXCLUDE constraint next time, and not without reason.

```

name | pg_index_has_property

---------------+-----------------------

clusterable | t

index_scan | t

bitmap_scan | t

backward_scan | t

```

«btree» access method supports both techniques to get values: index scan, as well as bitmap scan. And as we could see, the access method can walk through the tree both «forward» and «backward».

```

name | pg_index_column_has_property

--------------------+------------------------------

asc | t

desc | f

nulls_first | f

nulls_last | t

orderable | t

distance_orderable | f

returnable | t

search_array | t

search_nulls | t

```

First four properties of this layer explain how exactly values of a certain specific column are ordered. In this example, values are sorted in ascending order («asc») and NULLs are provided last («nulls\_last»). But as we've already seen, other combinations are possible.

«search\_array» property indicates support of expressions like this by the index:

```

demo=# explain(costs off)

select * from aircrafts where aircraft_code in ('733','763','773');

```

```

QUERY PLAN

-----------------------------------------------------------------

Index Scan using aircrafts_pkey on aircrafts

Index Cond: (aircraft_code = ANY ('{733,763,773}'::bpchar[]))

(2 rows)

```

«returnable» property indicates support of index-only scan, which is reasonable since rows of the index store indexed values themselves (unlike in hash index, for example). Here it makes sense to say a few words about covering indexes based on B-tree.

### Unique indexes with additional rows

As we discussed [earlier](https://habr.com/ru/company/postgrespro/blog/441962/), a covering index is the one that stores all values needed for a query, access to the table itself not being required (nearly). A unique index can specifically be covering.

But let's assume that we want to add extra columns needed for a query to the unique index. However, uniqueness of such composite values does not guarantee uniqueness of the key, and two indexes on the same columns will then be needed: one unique to support integrity constraint and another one to be used as covering. This is inefficient for sure.

In our company Anastasiya Lubennikova [lubennikovaav](https://habr.com/ru/users/lubennikovaav/) improved «btree» method so that additional, non-unique, columns could be included in a unique index. We hope, this patch will be adopted by the community to become a part of PostgreSQL, but this will not happen as early as in version 10. At this point, the patch is available in Pro Standard 9.5+, and this is what it looks like.

> In fact this patch was committed to PostgreSQL 11.

>

>

Let's consider the bookings table:

```

demo=# \d bookings

```

```

Table "bookings.bookings"

Column | Type | Modifiers

--------------+--------------------------+-----------

book_ref | character(6) | not null

book_date | timestamp with time zone | not null

total_amount | numeric(10,2) | not null

Indexes:

"bookings_pkey" PRIMARY KEY, btree (book_ref)

Referenced by:

TABLE "tickets" CONSTRAINT "tickets_book_ref_fkey" FOREIGN KEY (book_ref) REFERENCES bookings(book_ref)

```

In this table, the primary key (book\_ref, booking code) is provided by a regular «btree» index. Let's create a new unique index with an additional column:

```

demo=# create unique index bookings_pkey2 on bookings(book_ref) INCLUDE (book_date);

```

Now we replace the existing index with a new one (in the transaction, to apply all changes simultaneously):

```

demo=# begin;

demo=# alter table bookings drop constraint bookings_pkey cascade;

demo=# alter table bookings add primary key using index bookings_pkey2;

demo=# alter table tickets add foreign key (book_ref) references bookings (book_ref);

demo=# commit;

```

This is what we get:

```

demo=# \d bookings

```

```

Table "bookings.bookings"

Column | Type | Modifiers

--------------+--------------------------+-----------

book_ref | character(6) | not null

book_date | timestamp with time zone | not null

total_amount | numeric(10,2) | not null

Indexes:

"bookings_pkey2" PRIMARY KEY, btree (book_ref) INCLUDE (book_date)

Referenced by:

TABLE "tickets" CONSTRAINT "tickets_book_ref_fkey" FOREIGN KEY (book_ref) REFERENCES bookings(book_ref)

```

Now one and the same index works as unique and serves as a covering index for this query, for example:

```

demo=# explain(costs off)

select book_ref, book_date from bookings where book_ref = '059FC4';

```

```

QUERY PLAN

--------------------------------------------------

Index Only Scan using bookings_pkey2 on bookings

Index Cond: (book_ref = '059FC4'::bpchar)

(2 rows)

```

Creation of the index

---------------------

It is well-known, yet no less important, that for a large-size table, it is better to load data there without indexes and create needed indexes later. This is not only faster, but most likely the index will have smaller size.

The thing is that creation of «btree» index uses a more efficient process than row-wise insertion of values into the tree. Roughly, all data available in the table are sorted, and leaf pages of these data are created. Then internal pages are «built over» this base until the entire pyramid converges to the root.

The speed of this process depends on the size of RAM available, which is limited by the «maintenance\_work\_mem» parameter. So, increasing the parameter value can speed up the process. For unique indexes, memory of size «work\_mem» is allocated in addition to «maintenance\_work\_mem».

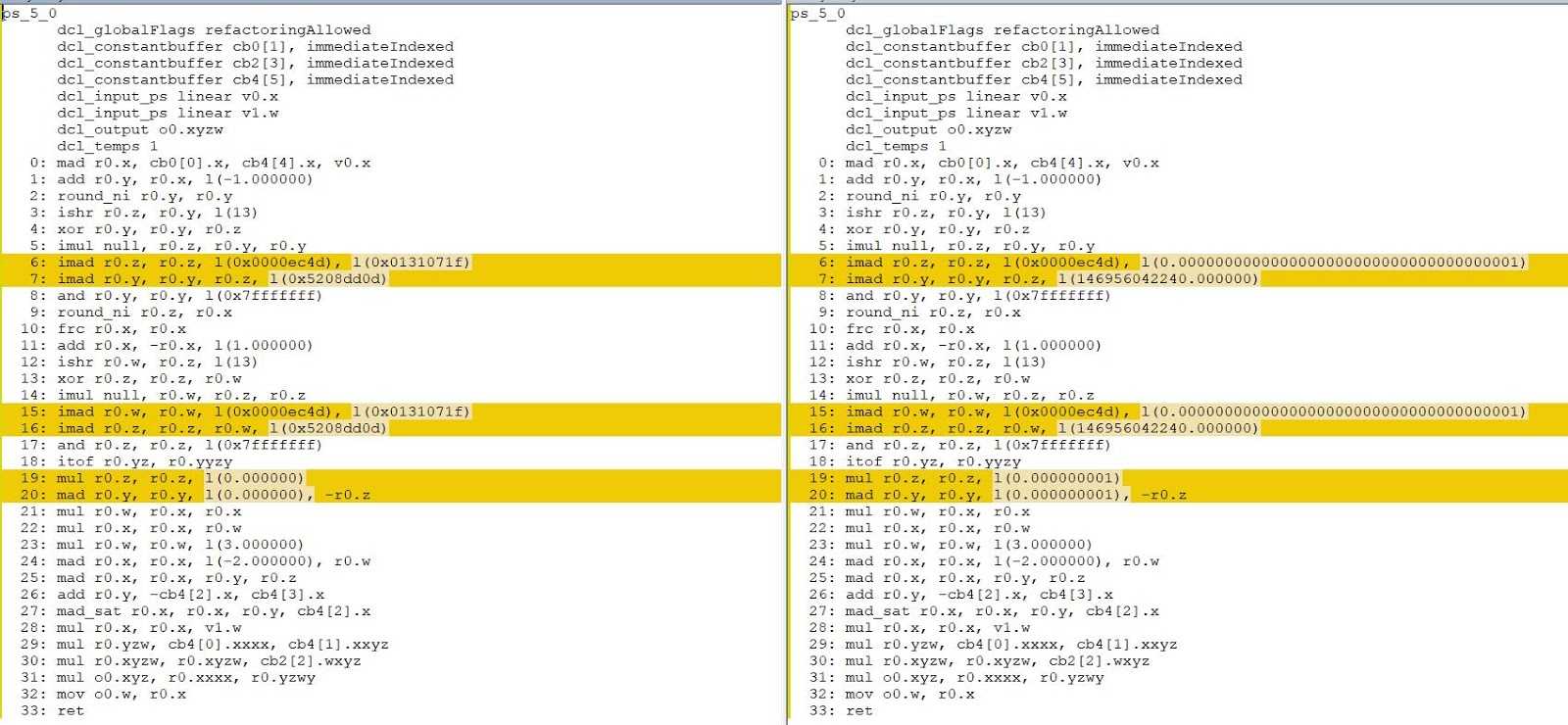

### Comparison semantics

[Last time](https://habr.com/ru/company/postgrespro/blog/442546/) we've mentioned that PostgreSQL needs to know which hash functions to call for values of different types and that this association is stored in «hash» access method. Likewise, the system must figure out how to order values. This is needed for sortings, groupings (sometimes), merge joins, and so on. PostgreSQL does not bind itself to operator names (such as >, <, =) since users can define their own data type and give corresponding operators different names. An operator family used by «btree» access method defines operator names instead.

For example, these comparison operators are used in the «bool\_ops» operator family:

```

postgres=# select amop.amopopr::regoperator as opfamily_operator,

amop.amopstrategy

from pg_am am,

pg_opfamily opf,

pg_amop amop

where opf.opfmethod = am.oid

and amop.amopfamily = opf.oid

and am.amname = 'btree'

and opf.opfname = 'bool_ops'

order by amopstrategy;

```

```

opfamily_operator | amopstrategy

---------------------+--------------

<(boolean,boolean) | 1

<=(boolean,boolean) | 2

=(boolean,boolean) | 3

>=(boolean,boolean) | 4

>(boolean,boolean) | 5

(5 rows)

```

Here we can see five comparison operators, but as already mentioned, we should not rely on their names. To figure out which comparison each operator does, the strategy concept is introduced. Five strategies are defined to describe operator semantics:

* 1 — less

* 2 — less or equal

* 3 — equal

* 4 — greater or equal

* 5 — greater

Some operator families can contain several operators implementing one strategy. For example, «integer\_ops» operator family contains the following operators for strategy 1:

```

postgres=# select amop.amopopr::regoperator as opfamily_operator

from pg_am am,

pg_opfamily opf,

pg_amop amop

where opf.opfmethod = am.oid

and amop.amopfamily = opf.oid

and am.amname = 'btree'

and opf.opfname = 'integer_ops'

and amop.amopstrategy = 1

order by opfamily_operator;

```

```

opfamily_operator

----------------------

<(integer,bigint)

<(smallint,smallint)

<(integer,integer)

<(bigint,bigint)

<(bigint,integer)

<(smallint,integer)

<(integer,smallint)

<(smallint,bigint)

<(bigint,smallint)

(9 rows)

```

Thanks to this, the optimizer can avoid type casts when comparing values of different types contained in one operator family.

### Index support for a new data type

The documentation provides [an example](https://postgrespro.com/docs/postgrespro/9.6/xindex) of creation of a new data type for complex numbers and of an operator class to sort values of this type. This example uses C language, which is absolutely reasonable when the speed is critical. But nothing hinders us from using pure SQL for the same experiment in order just to try and better understand the comparison semantics.

Let's create a new composite type with two fields: real and imaginary parts.

```

postgres=# create type complex as (re float, im float);

```

We can create a table with a field of the new type and add some values to the table:

```

postgres=# create table numbers(x complex);

postgres=# insert into numbers values ((0.0, 10.0)), ((1.0, 3.0)), ((1.0, 1.0));

```

Now a question arises: how to order complex numbers if no order relation is defined for them in the mathematical sense?

As it turns out, comparison operators are already defined for us:

```

postgres=# select * from numbers order by x;

```

```

x

--------

(0,10)

(1,1)

(1,3)

(3 rows)

```

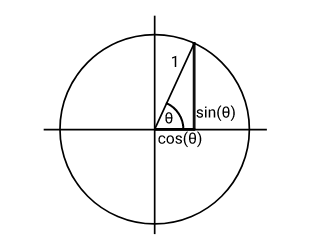

By default, sorting is componentwise for a composite type: first fields are compared, then second fields, and so on, roughly the same way as text strings are compared character-by-character. But we can define a different order. For example, complex numbers can be treated as vectors and ordered by the modulus (length), which is computed as the square root of the sum of squares of the coordinates (the Pythagoras' theorem). To define such an order, let's create an auxiliary function that computes the modulus:

```

postgres=# create function modulus(a complex) returns float as $$

select sqrt(a.re*a.re + a.im*a.im);

$$ immutable language sql;

```

Now we will systematically define functions for all the five comparison operators using this auxiliary function:

```

postgres=# create function complex_lt(a complex, b complex) returns boolean as $$

select modulus(a) < modulus(b);

$$ immutable language sql;

postgres=# create function complex_le(a complex, b complex) returns boolean as $$

select modulus(a) <= modulus(b);

$$ immutable language sql;

postgres=# create function complex_eq(a complex, b complex) returns boolean as $$

select modulus(a) = modulus(b);

$$ immutable language sql;

postgres=# create function complex_ge(a complex, b complex) returns boolean as $$

select modulus(a) >= modulus(b);

$$ immutable language sql;

postgres=# create function complex_gt(a complex, b complex) returns boolean as $$

select modulus(a) > modulus(b);

$$ immutable language sql;

```

And we'll create corresponding operators. To illustrate that they do not need to be called ">", "<", and so on, let's give them «weird» names.

```

postgres=# create operator #<#(leftarg=complex, rightarg=complex, procedure=complex_lt);

postgres=# create operator #<=#(leftarg=complex, rightarg=complex, procedure=complex_le);

postgres=# create operator #=#(leftarg=complex, rightarg=complex, procedure=complex_eq);

postgres=# create operator #>=#(leftarg=complex, rightarg=complex, procedure=complex_ge);

postgres=# create operator #>#(leftarg=complex, rightarg=complex, procedure=complex_gt);

```

At this point, we can compare numbers:

```

postgres=# select (1.0,1.0)::complex #<# (1.0,3.0)::complex;

```

```

?column?

----------

t

(1 row)

```

In addition to five operators, «btree» access method requires one more function (excessive but convenient) to be defined: it must return -1, 0, or 1 if the first value is less than, equal to, or greater than the second one. This auxiliary function is called support. Other access methods can require defining other support functions.

```

postgres=# create function complex_cmp(a complex, b complex) returns integer as $$

select case when modulus(a) < modulus(b) then -1

when modulus(a) > modulus(b) then 1

else 0

end;

$$ language sql;

```

Now we are ready to create an operator class (and same-name operator family will be created automatically):

```

postgres=# create operator class complex_ops

default for type complex

using btree as

operator 1 #<#,

operator 2 #<=#,

operator 3 #=#,

operator 4 #>=#,

operator 5 #>#,

function 1 complex_cmp(complex,complex);

```

Now sorting works as desired:

```

postgres=# select * from numbers order by x;

```

```

x

--------

(1,1)

(1,3)

(0,10)

(3 rows)

```

And it will certainly be supported by «btree» index.

To complete the picture, you can get support functions using this query:

```

postgres=# select amp.amprocnum,

amp.amproc,

amp.amproclefttype::regtype,

amp.amprocrighttype::regtype

from pg_opfamily opf,

pg_am am,

pg_amproc amp

where opf.opfname = 'complex_ops'

and opf.opfmethod = am.oid

and am.amname = 'btree'

and amp.amprocfamily = opf.oid;

```

```

amprocnum | amproc | amproclefttype | amprocrighttype

-----------+-------------+----------------+-----------------

1 | complex_cmp | complex | complex

(1 row)

```

Internals

---------

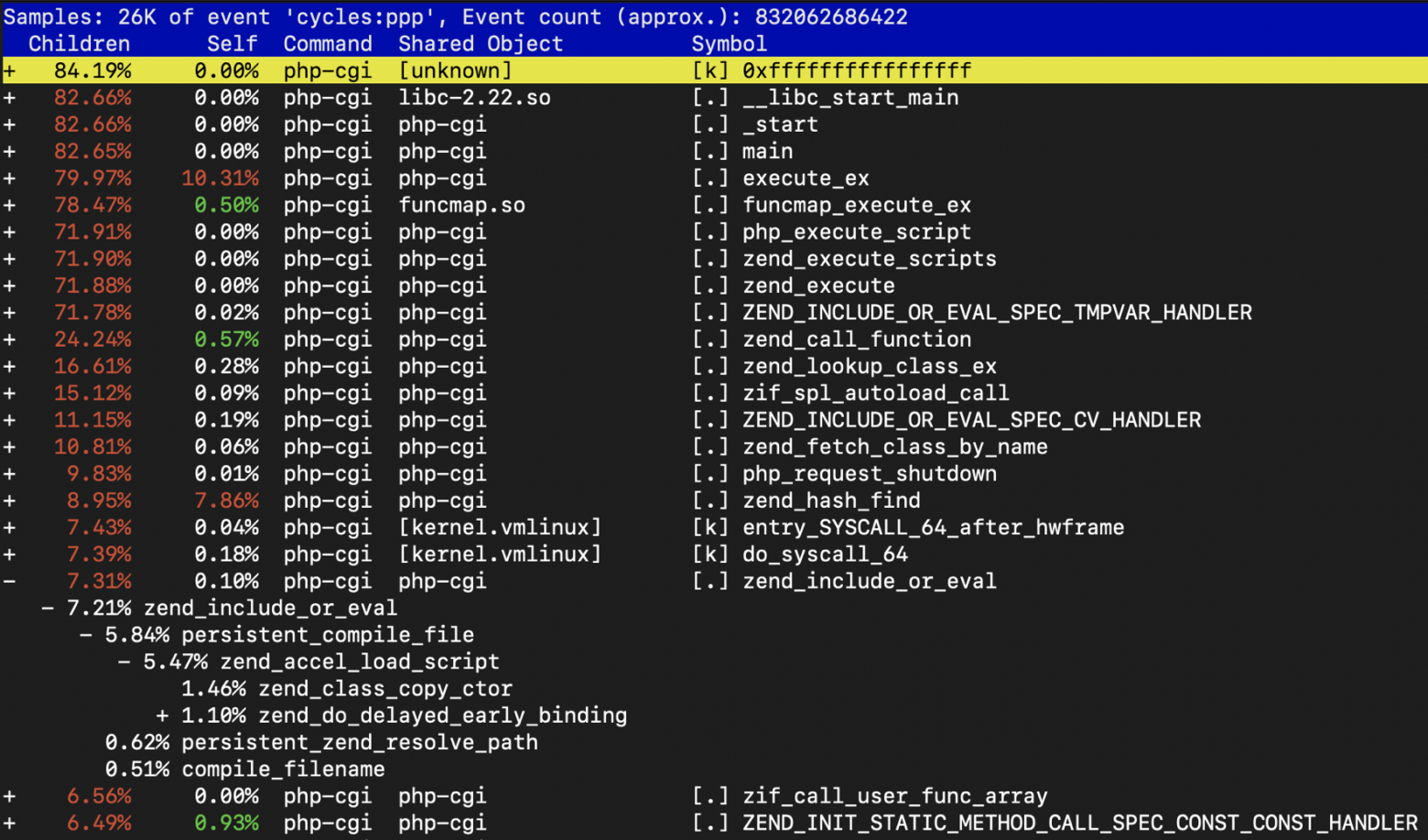

We can explore the internal structure of B-tree using «pageinspect» extension.

```

demo=# create extension pageinspect;

```

Index metapage:

```

demo=# select * from bt_metap('ticket_flights_pkey');

```

```

magic | version | root | level | fastroot | fastlevel

--------+---------+------+-------+----------+-----------

340322 | 2 | 164 | 2 | 164 | 2

(1 row)

```

The most interesting here is the index level: the index on two columns for a table with one million rows required as few as 2 levels (not including the root).

Statistical information on block 164 (root):

```

demo=# select type, live_items, dead_items, avg_item_size, page_size, free_size

from bt_page_stats('ticket_flights_pkey',164);

```

```

type | live_items | dead_items | avg_item_size | page_size | free_size

------+------------+------------+---------------+-----------+-----------

r | 33 | 0 | 31 | 8192 | 6984

(1 row)

```

And the data in the block (the «data» field, which is here sacrificed to the screen width, contains the value of the indexing key in binary representation):

```

demo=# select itemoffset, ctid, itemlen, left(data,56) as data

from bt_page_items('ticket_flights_pkey',164) limit 5;

```

```

itemoffset | ctid | itemlen | data

------------+---------+---------+----------------------------------------------------------

1 | (3,1) | 8 |

2 | (163,1) | 32 | 1d 30 30 30 35 34 33 32 33 30 35 37 37 31 00 00 ff 5f 00

3 | (323,1) | 32 | 1d 30 30 30 35 34 33 32 34 32 33 36 36 32 00 00 4f 78 00

4 | (482,1) | 32 | 1d 30 30 30 35 34 33 32 35 33 30 38 39 33 00 00 4d 1e 00

5 | (641,1) | 32 | 1d 30 30 30 35 34 33 32 36 35 35 37 38 35 00 00 2b 09 00

(5 rows)

```

The first element pertains to techniques and specifies the upper bound of all elements in the block (an implementation detail that we did not discuss), while the data itself starts with the second element. It is clear that the leftmost child node is block 163, followed by block 323, and so on. They, in turn, can be explored using the same functions.

Now, following a good tradition, it makes sense to read the documentation, [README](https://git.postgresql.org/gitweb/?p=postgresql.git;a=blob;f=src/backend/access/nbtree/README;hb=HEAD), and source code.

Yet one more potentially useful extension is "[amcheck](https://postgrespro.com/docs/postgresql/10/amcheck)", which will be incorporated in PostgreSQL 10, and for lower versions you can get it from [github](https://github.com/petergeoghegan/amcheck). This extension checks logical consistency of data in B-trees and enables us to detect faults in advance.

> That's true, «amcheck» is a part of PostgreSQL starting from version 10.

>

>

[Read on](https://habr.com/ru/company/postgrespro/blog/444742/).

|

https://habr.com/ru/post/443284/

| null |

en

| null |

# Kafka как хранилище данных: реальный пример от Twitter

Привет, Хабр!

Нас давно занимала тема использования Apache Kafka в качестве хранилища данных, рассмотренная с теоретической точки зрения, например, [здесь](https://dzone.com/articles/is-apache-kafka-a-database-the-2020-update). Тем интереснее предложить вашему вниманию перевод материала из блога Twitter (оригинал — декабрь 2020), в котором описан нетрадиционный вариант использования Kafka в качестве базы данных для обработки и воспроизведения событий. Надеемся, статья будет интересна и натолкнет вас на свежие мысли и решения при работе с [Kafka](https://www.piter.com/collection/all/product/apache-kafka-potokovaya-obrabotka-i-analiz-dannyh).

Введение

--------

Когда разработчики потребляют общедоступные данные Twitter через API Twitter, они рассчитывают на надежность, скорость и стабильность. Поэтому некоторое время назад в Twitter запустили [Account Activity Replay](https://developer.twitter.com/en/docs/twitter-api/enterprise/account-activity-api/guides/activity-replay-api#:~:text=The%20Account%20Activity%20Replay%20API%20was%20developed%20for%20any%20scenario,real-time%20delivery%20of%20activities.) API для [Account Activity](https://developer.twitter.com/en/docs/twitter-api/enterprise/account-activity-api/overview) API, чтобы разработчикам было проще обеспечить стабильность своих систем. Account Activity Replay API – это инструмент восстановления данных, позволяющий разработчикам извлекать события со сроком давности до пяти дней. Этот API восстанавливает события, которые не были доставлены по разным причинам, в том числе, из-за аварийных отказов сервера, происходивших при попытках доставки в режиме реального времени.

Инженеры Twitter стремились не только создать API, которые будут положительно восприняты разработчиками, но и:

* Повысить производительность труда инженеров;

* Добиться, чтобы систему было легко поддерживать. В частности, минимизировать необходимость переключения контекстов для разработчиков, [SRE-инженеров](https://www.piter.com/product_by_id/110769373) и всех прочих, кто имеет дело с системой.

По этой причине при работе над созданием системы воспроизведения, на которую полагается при работе API, было решено взять за основу имеющуюся систему для работы в режиме реального времени, на которой основан Account Activity API. Так удалось повторно воспользоваться имеющимися разработками и минимизировать переключение контекста и объем обучения, которые были бы гораздо значительнее, если бы для описанной работы создавалась совершенно новая система.

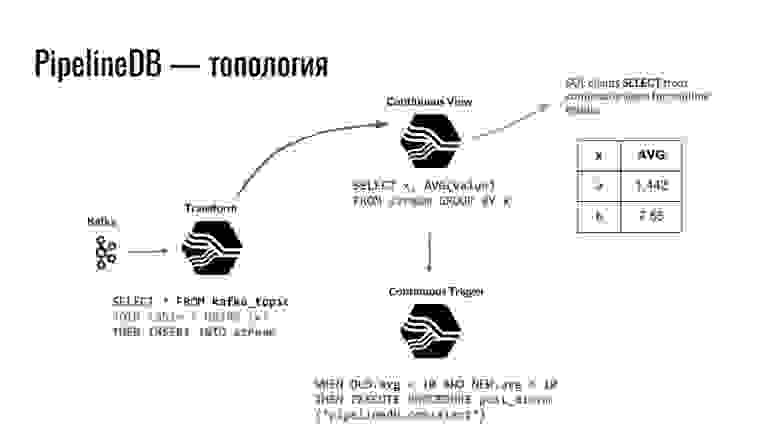

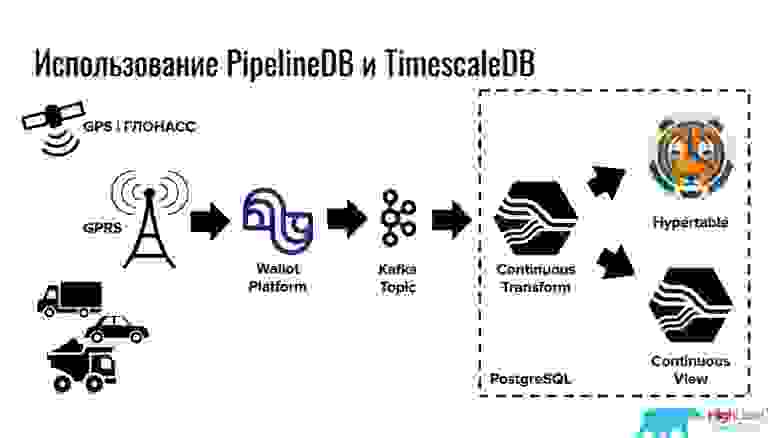

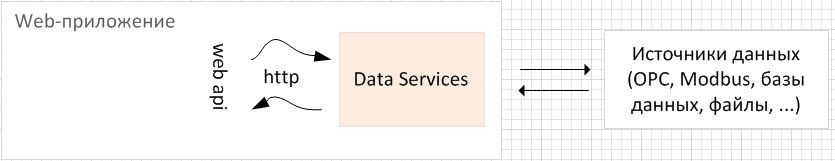

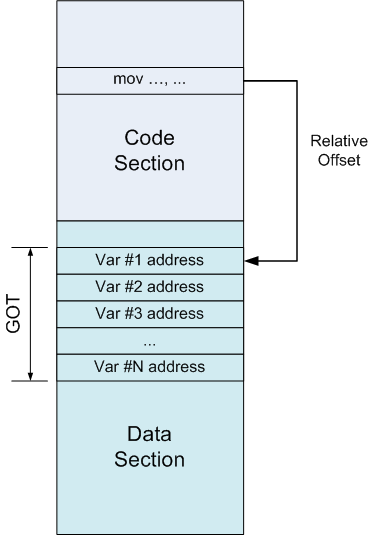

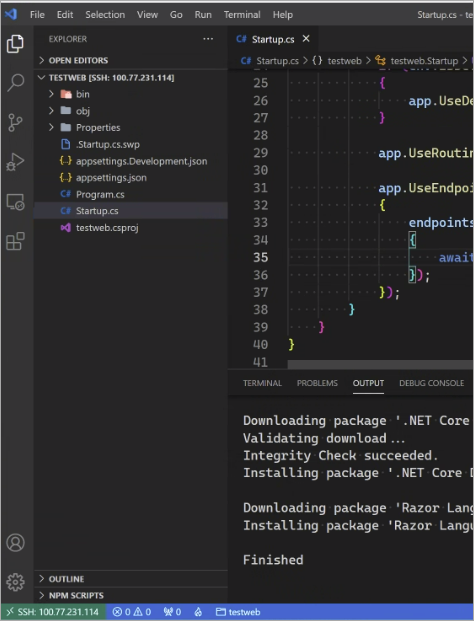

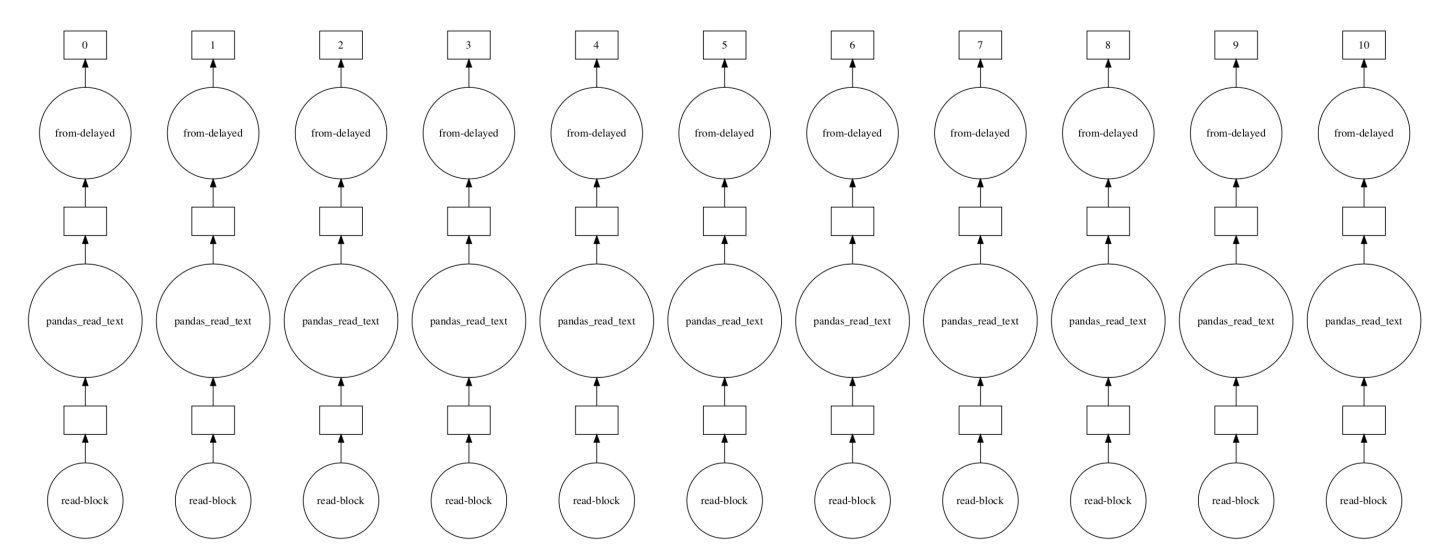

Решение для работы в режиме реального времени базируется на архитектуре «публикация-подписка». Для такой цели, учитывая поставленные задачи и создавая уровень хранения информации, с которого она будет считываться, возникла идея переосмыслить известную потоковую технологию — Apache Kafka.

Контекст

--------

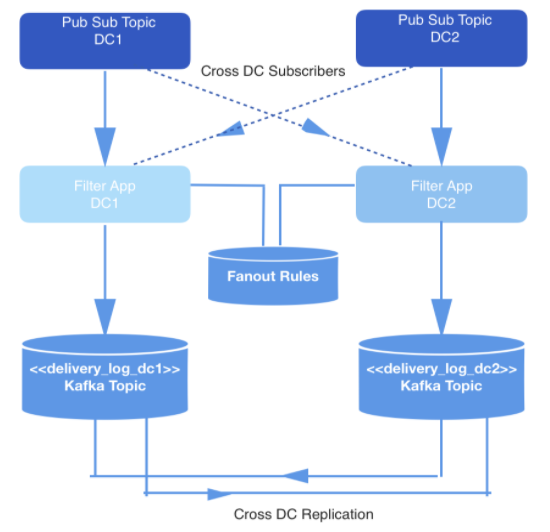

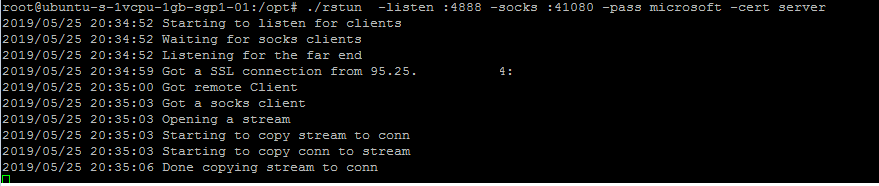

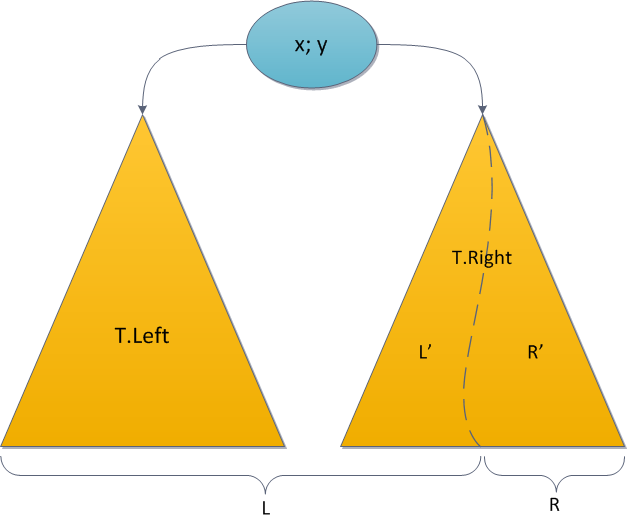

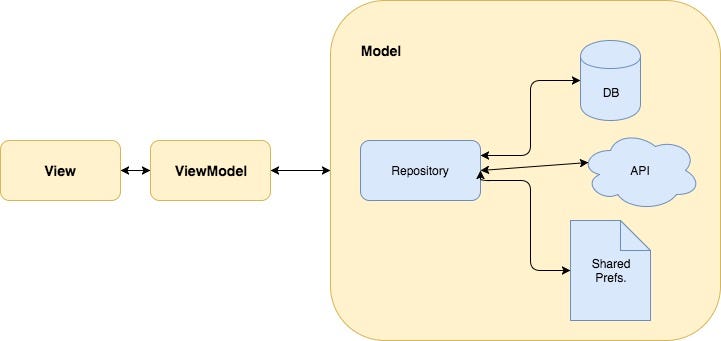

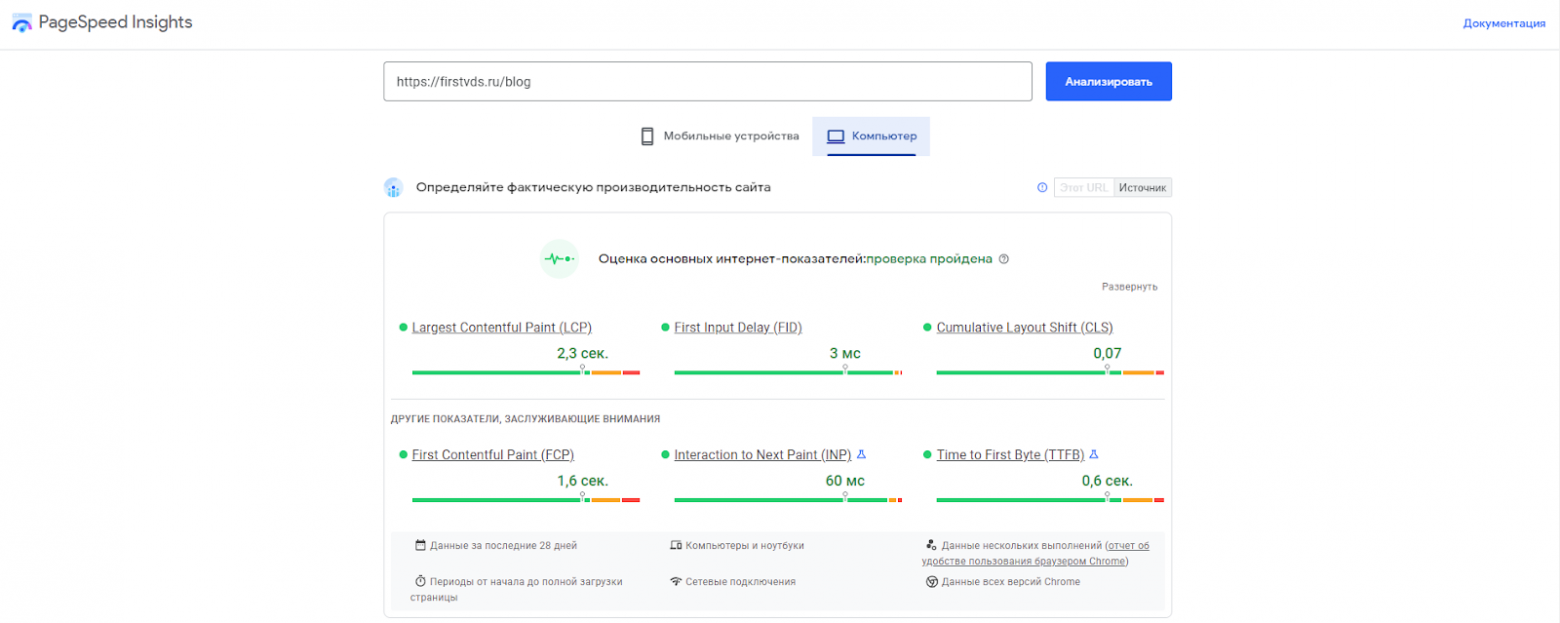

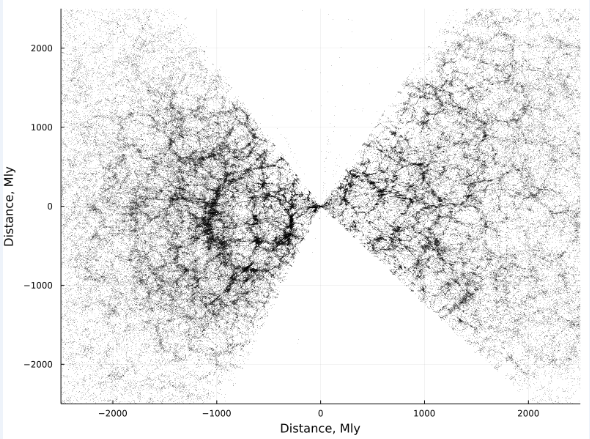

События, происходящие в режиме реального времени, производятся в двух датацентрах. Когда эти события порождаются, их записывают в топики, работающие по принципу «публикация-подписка», которые в целях обеспечения избыточности подвергаются перекрестной репликации в двух датацентрах.

Доставлять требуется не все события, поэтому все события фильтруются внутренним приложением, которое потребляет события из нужных топиков, сверяет каждое с набором правил в хранилище ключей и значений, и решает, должно ли событие быть доставлено конкретному разработчику через общедоступный API. События доставляются через вебхук, а URL каждого вебхука принадлежит разработчику, идентифицируемому уникальным ID.

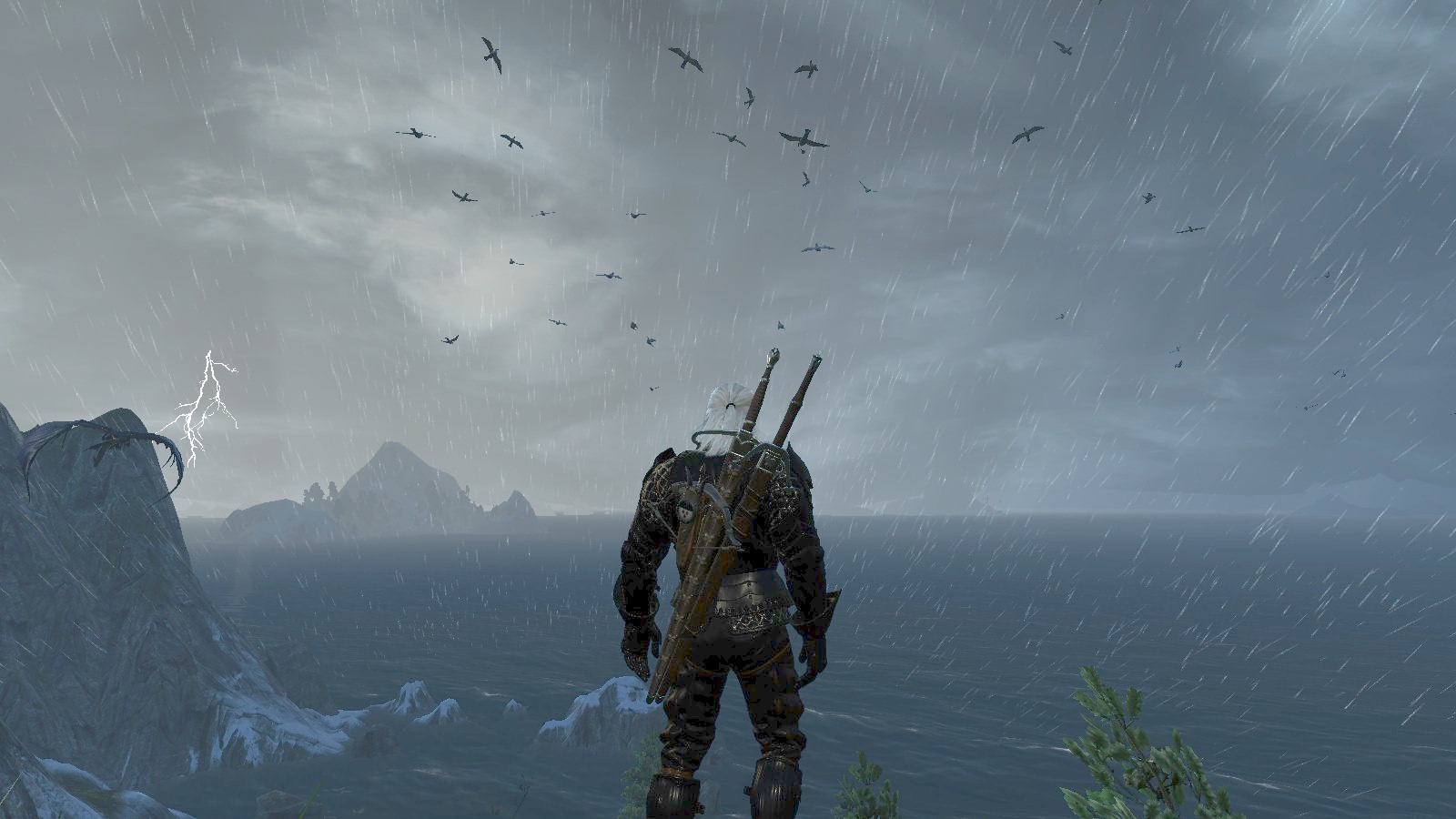

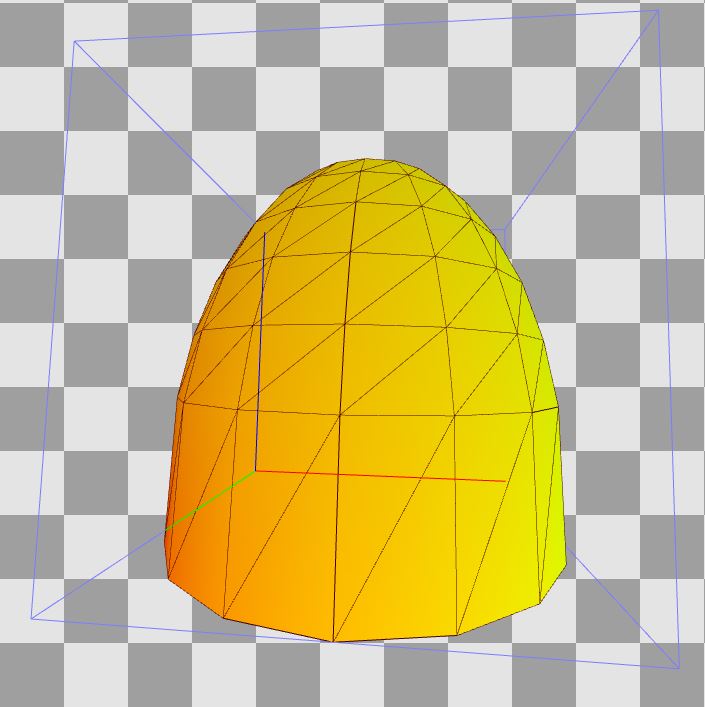

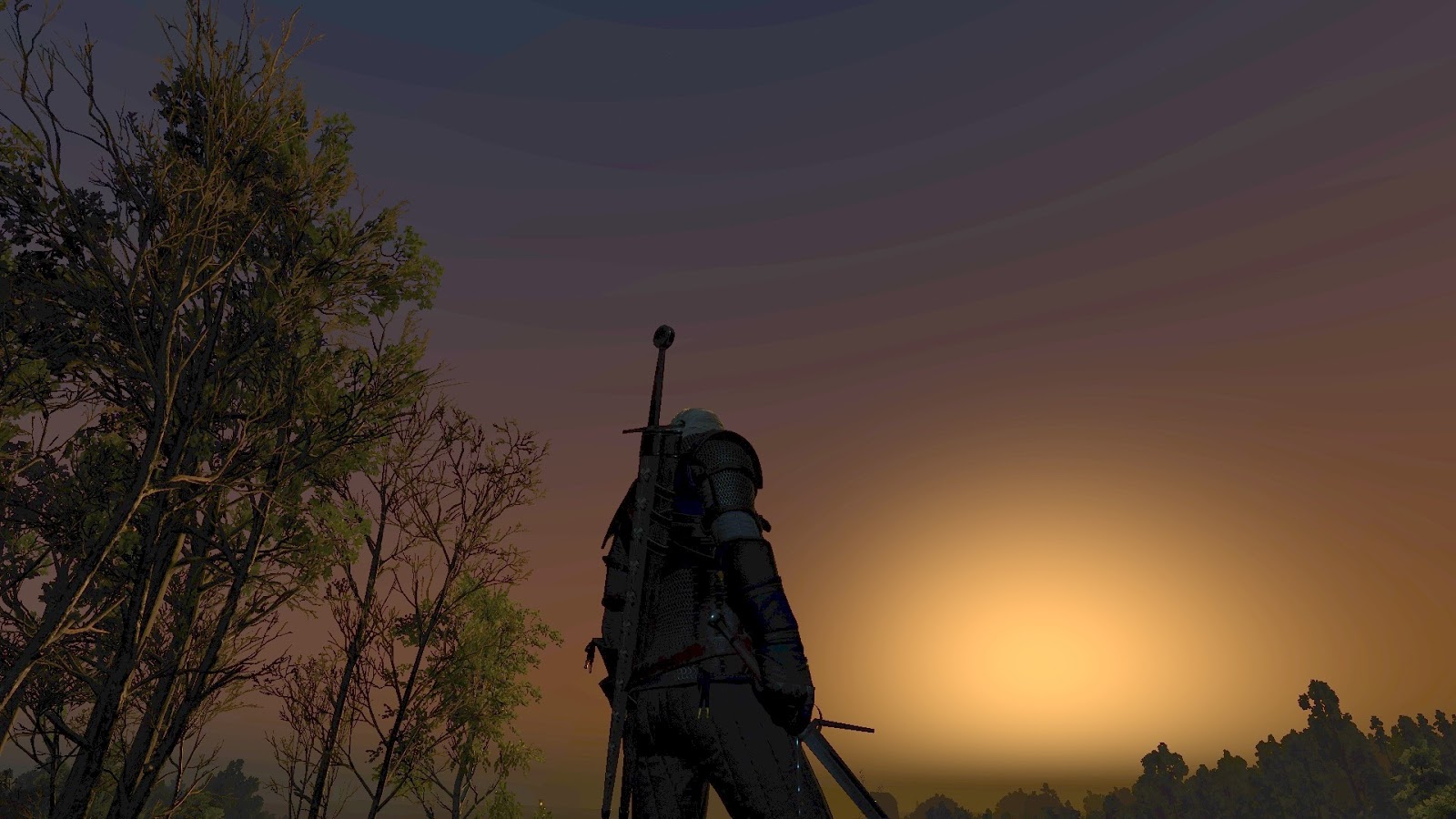

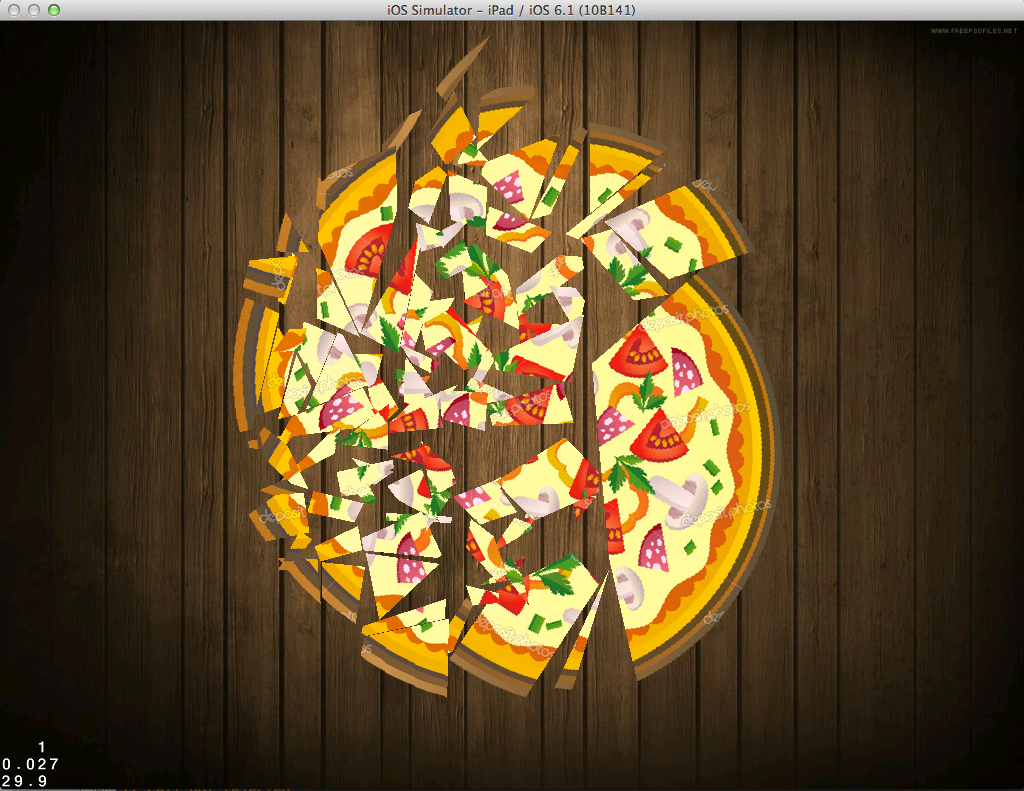

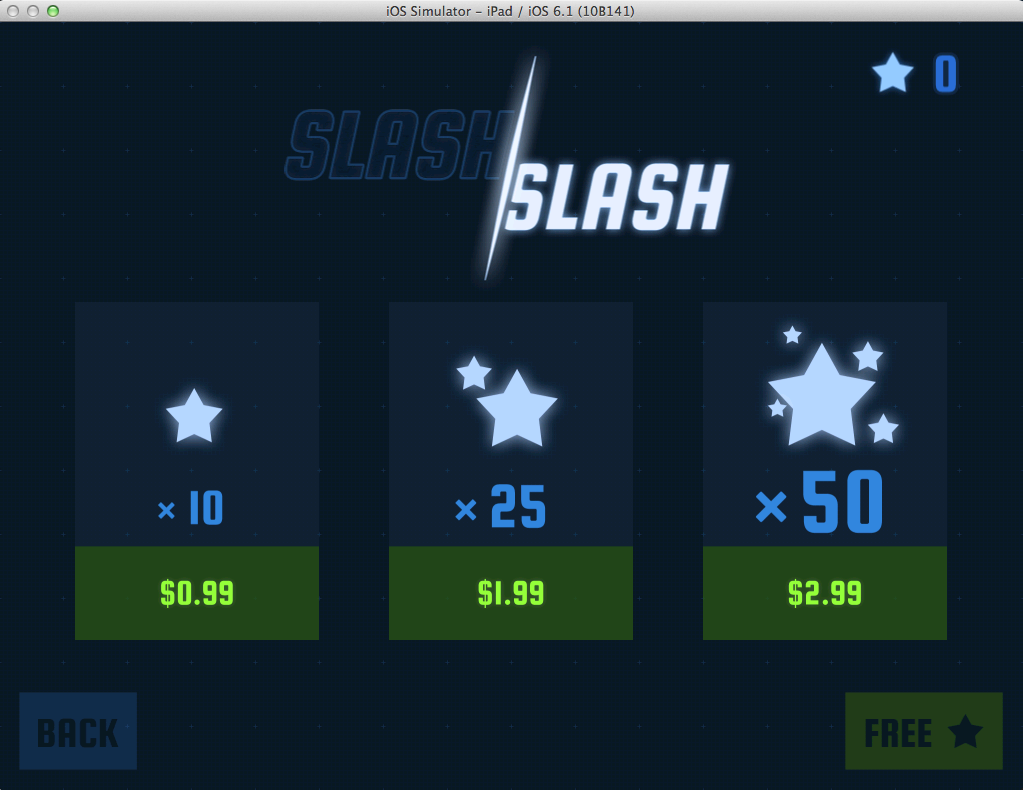

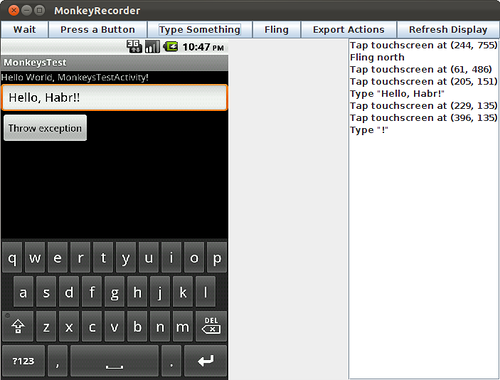

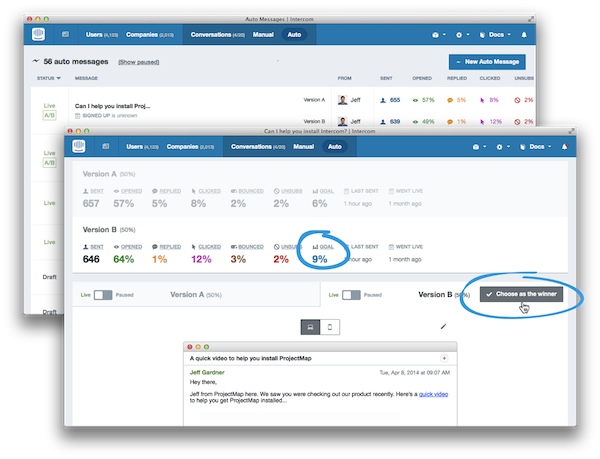

*Рис. 1: Конвейер генерации данных*

Хранение и сегментирование

--------------------------

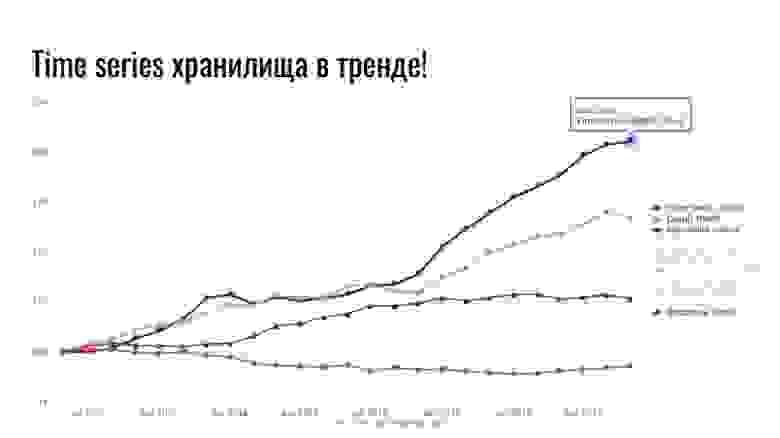

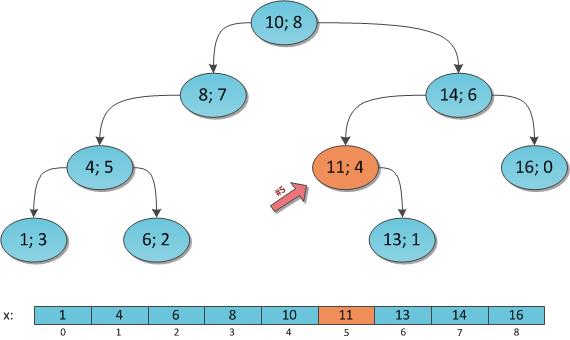

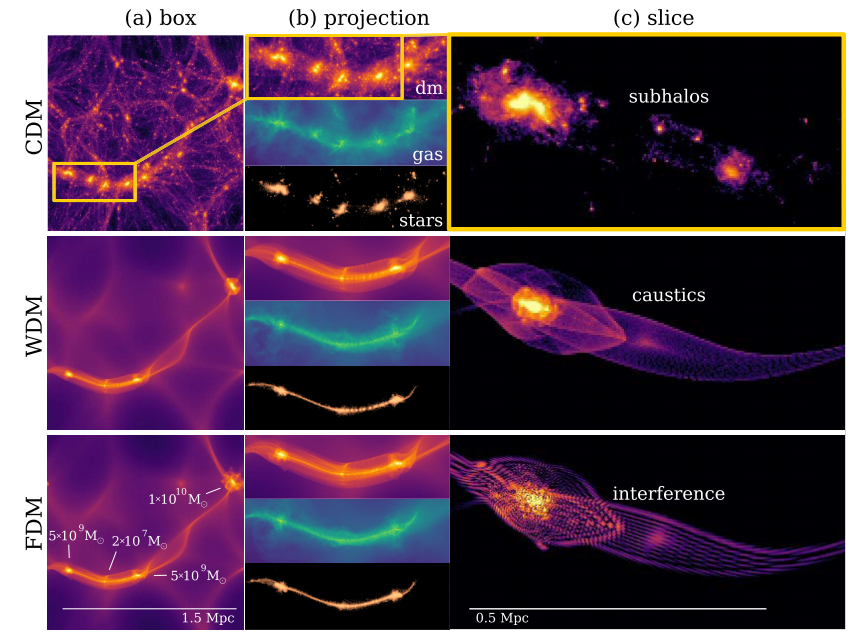

Как правило, при создании системы воспроизведения, требующей подобного хранилища данных, выбирается архитектура на основе Hadoop и HDFS. В данном случае, напротив, был выбран Apache Kafka, по двум причинам:

* Система для работы в режиме реального времени была по принципу «публикация-подписка», органичному для устройства Kafka

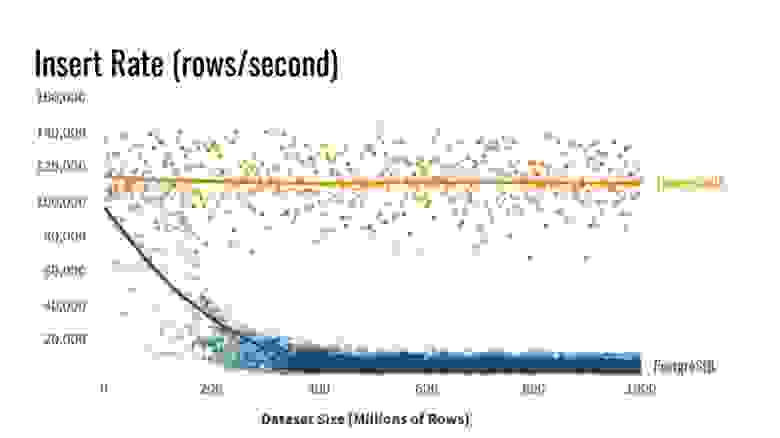

* Объем событий, который требуется хранить в системе воспроизведения, исчисляется не петабайтами. Мы храним данные не более чем за несколько дней. Кроме того, обращаться с заданиями MapReduce для Hadoop затратнее и медленнее, чем потреблять данные в Kafka, и первый вариант не отвечает ожиданиям разработчиков.

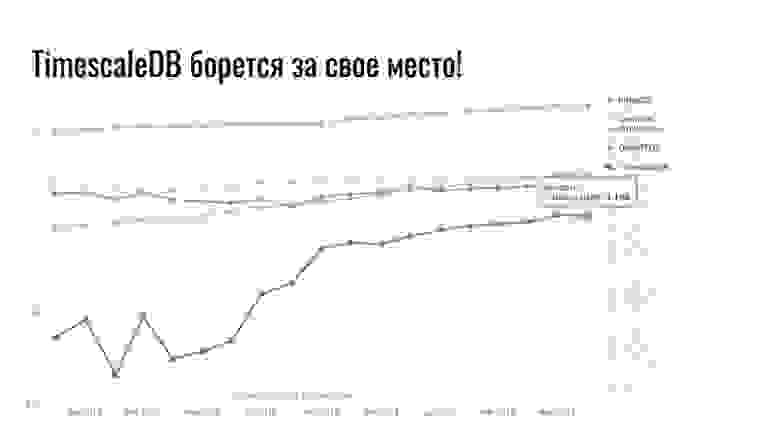

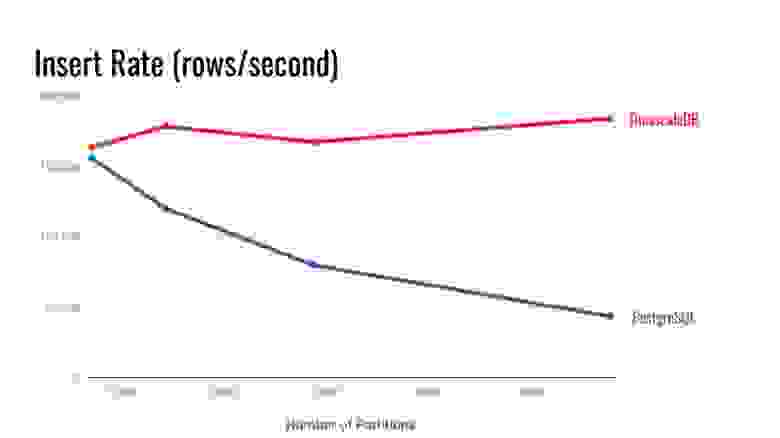

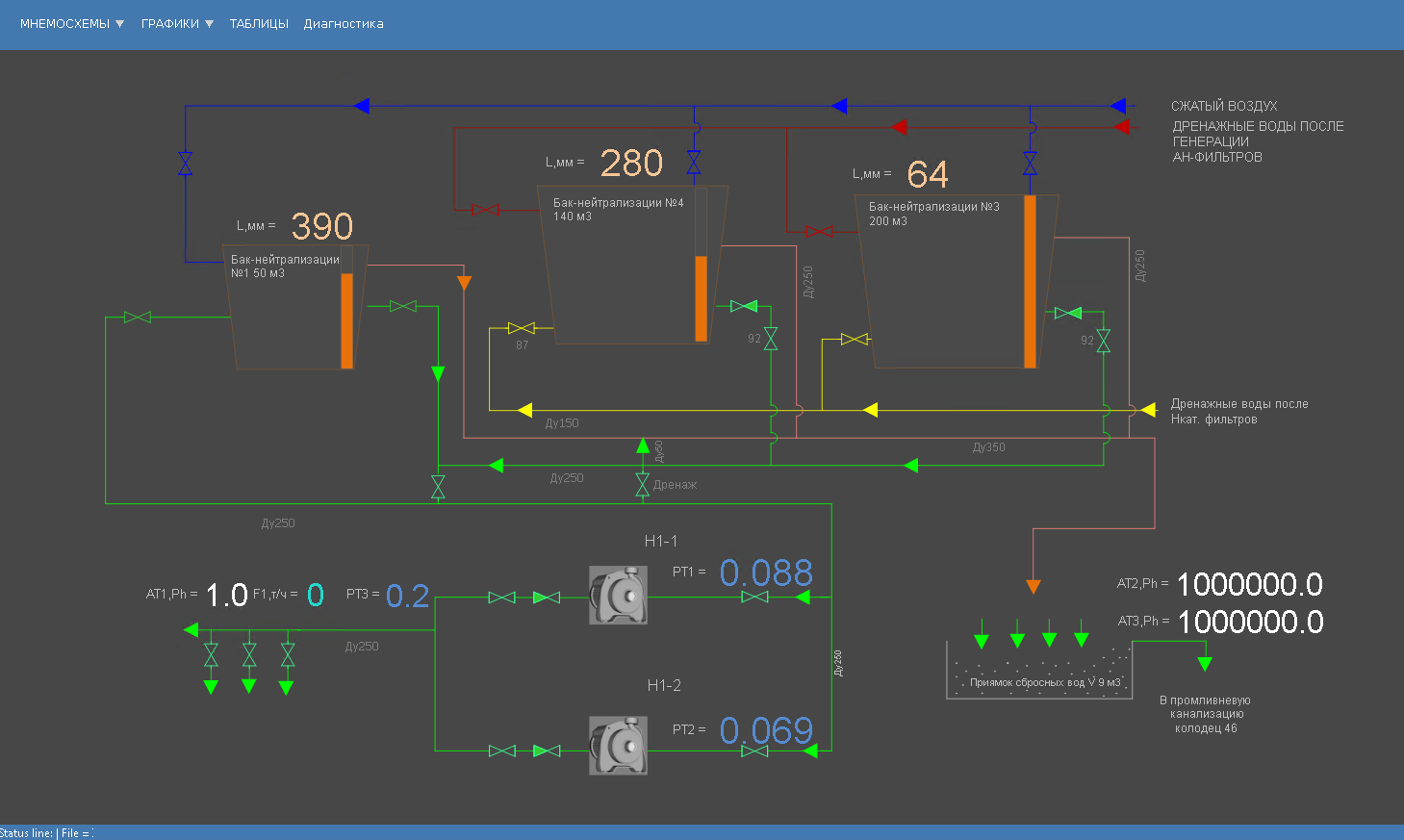

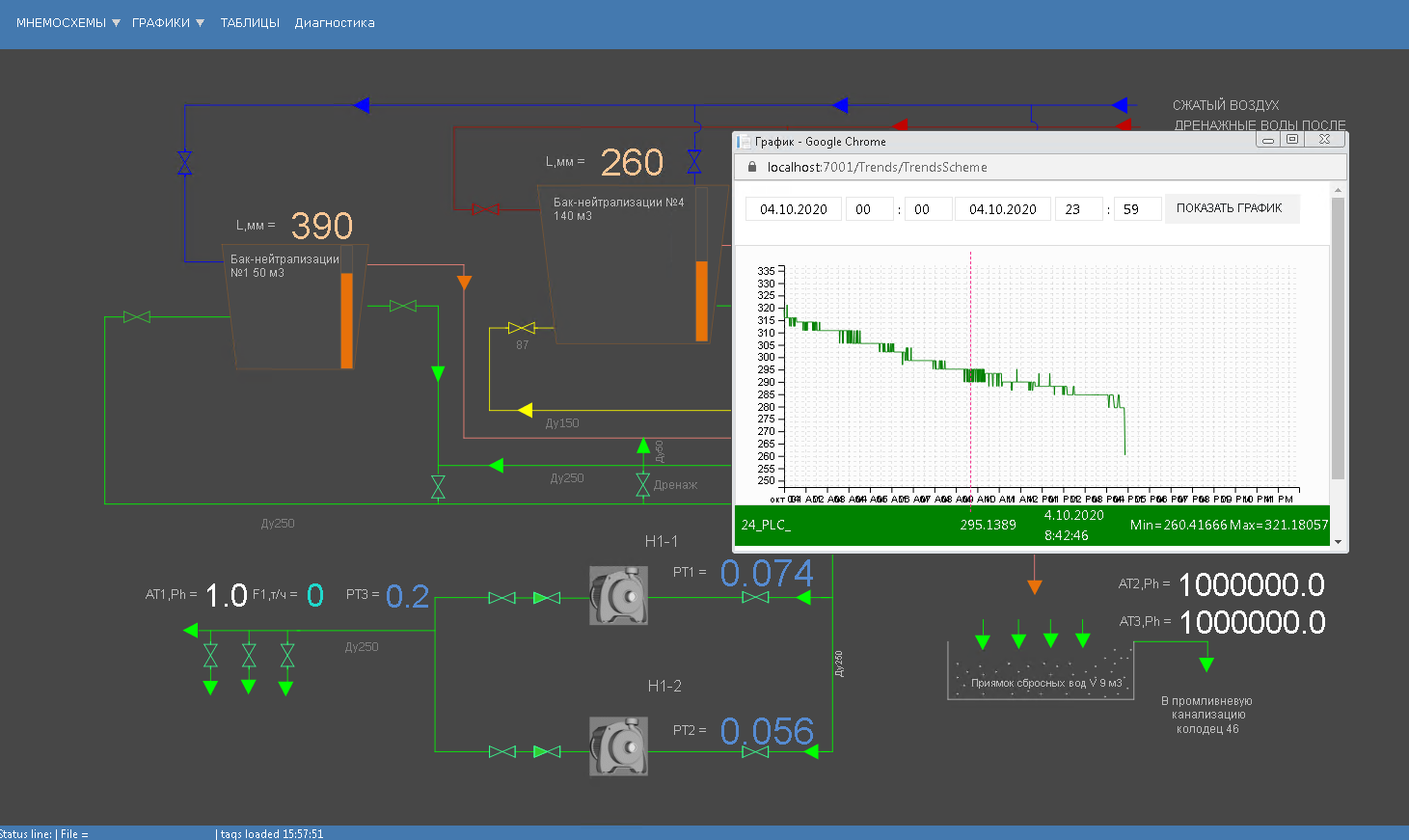

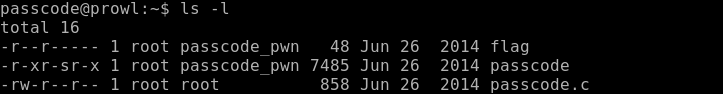

В данном случае основная нагрузка ложится на конвейер воспроизведения данных, работающий в режиме реального времени и гарантирующий, что события, которые должны быть доставлены каждому разработчику, будут храниться в Kafka. Назовем топик Kafka delivery\_log; по одному такому топику будет на каждый датацентр. Эти топики подвергаются перекрестной репликации для обеспечения избыточности, что позволяет выдавать из одного датацентра запрос на репликацию. Перед доставкой сохраненные таким образом события проходят дедупликацию.

В данном топике Kafka мы создаем множество партиций, использующих задаваемое по умолчанию семантическое сегментирование. Следовательно, партиции соответствуют хешу webhookId разработчика, и этот id служит ключом каждой записи. Предполагалось использовать статическое сегментирование, но в итоге от него отказались из-за повышенного риска, что в одной партиции окажется больше данных, чем в других, если какие-то разработчики в ходе своей деятельности генерируют больше событий, чем другие. Вместо этого было выбрано фиксированное количество партиций, по которым распределяются данные, а стратегия сегментирования была оставлена по умолчанию. Таким образом снижается риск возникновения несбалансированных партиций, а также не приходится считывать все партиции в топике Kafka.

Напротив, на основе webhookId, для которого поступает запрос, сервис воспроизведения определяет конкретную партицию, с которой будет происходить считывание, и поднимает новый потребитель Kafka для данной партиции. Количество партиций в топике не меняется, так как от этого зависит хеширование ключей и распределение событий.

Чтобы минимизировать пространство под хранилище данных, информация подвергается сжатию при помощи алгоритма [snappy](https://opensource.google/projects/snappy), поскольку известно, что большая часть информации в описываемой задаче обрабатывается на стороне потребителя. Кроме того, snappy быстрее поддается [декомпрессии](https://blog.cloudflare.com/squeezing-the-firehose/), нежели другие алгоритмы сжатия, поддерживаемые Kafka: [gzip](https://www.gzip.org) и [lz4](https://github.com/lz4/lz4).

Запросы и обработка

-------------------

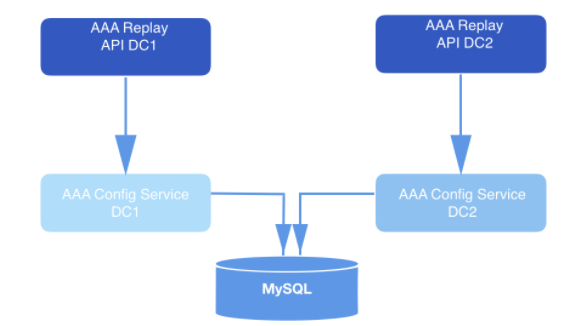

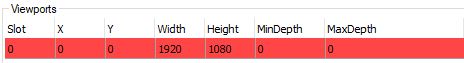

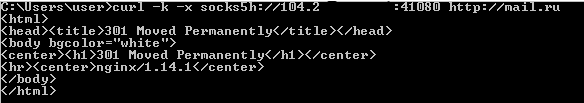

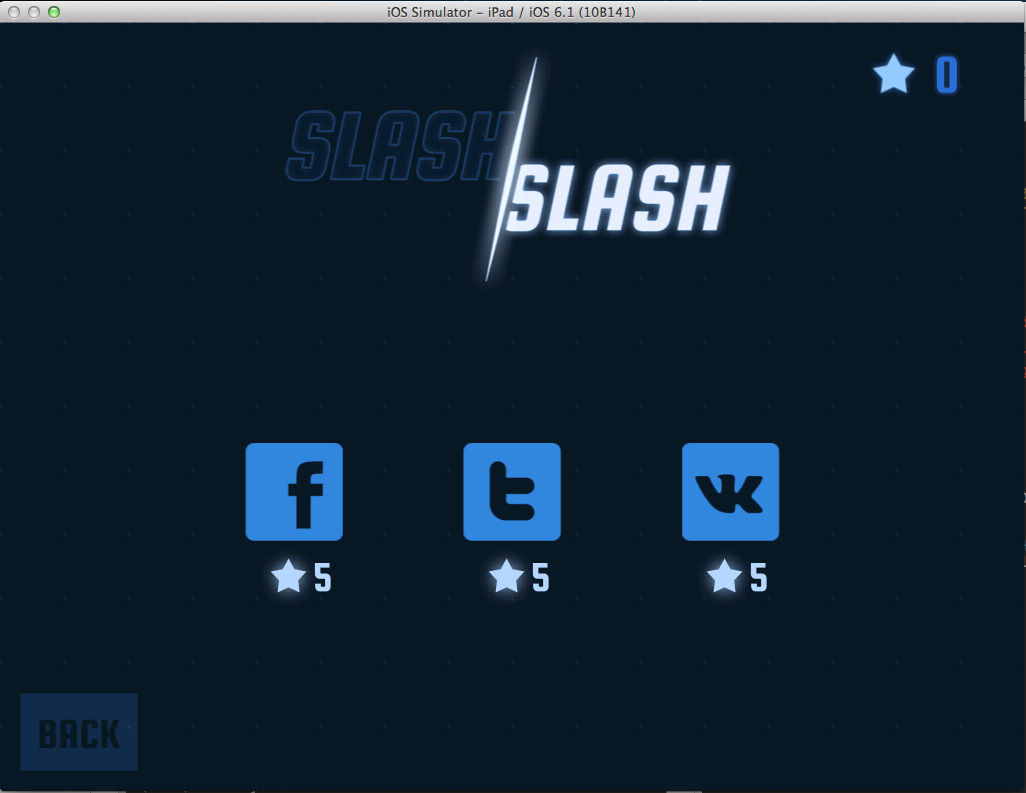

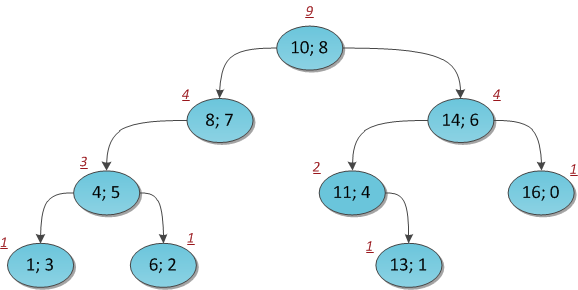

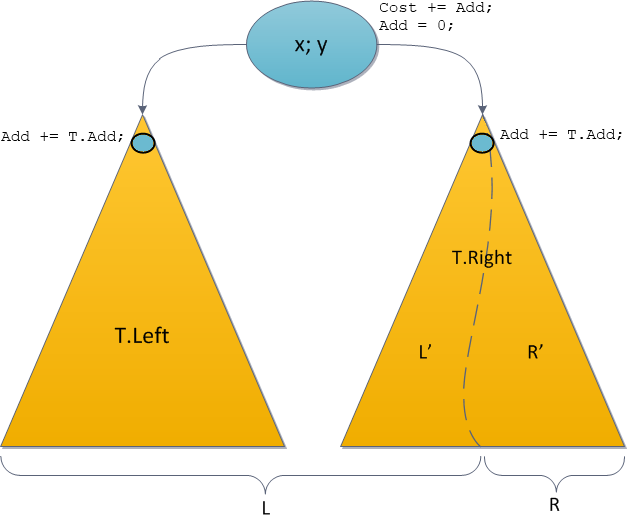

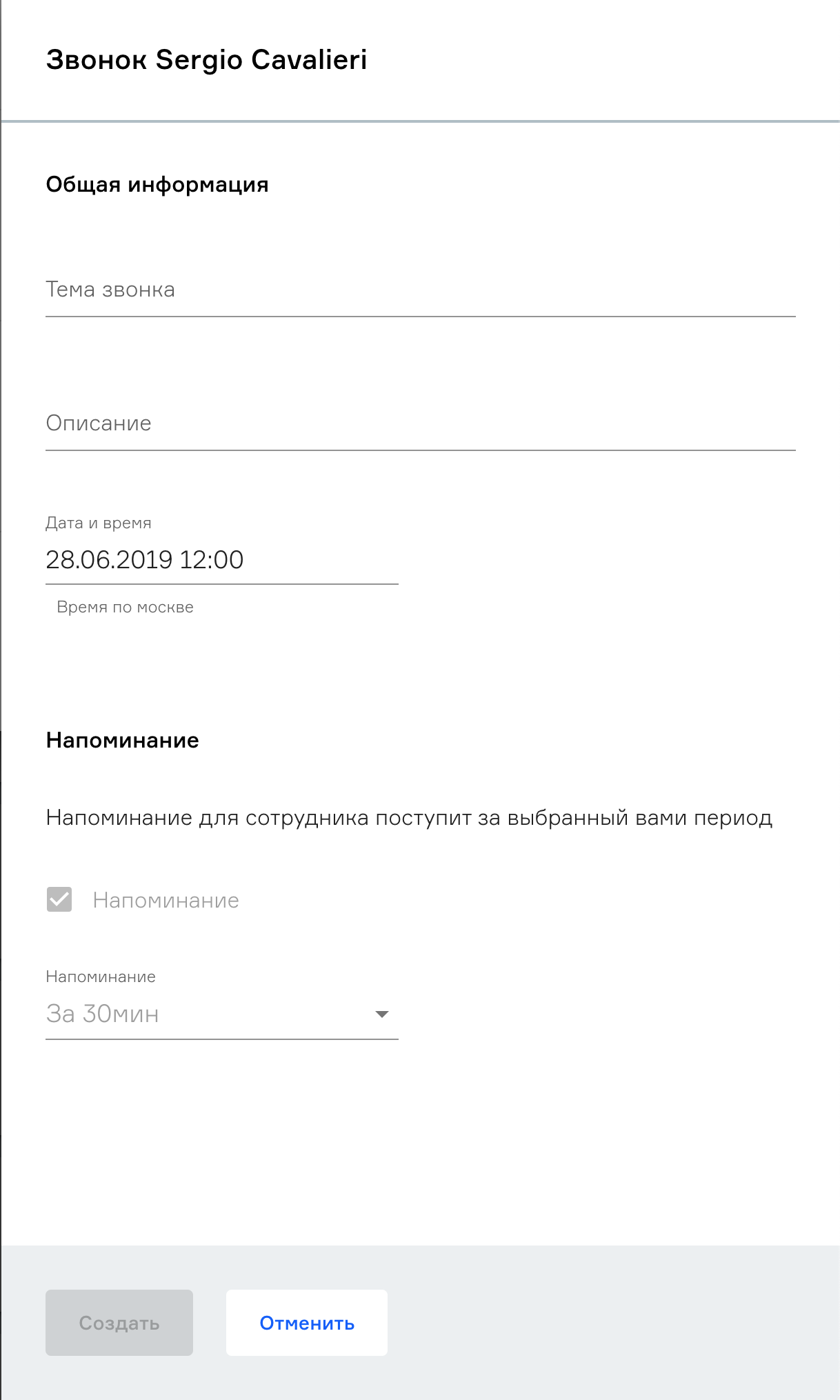

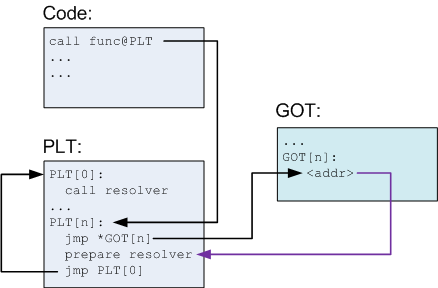

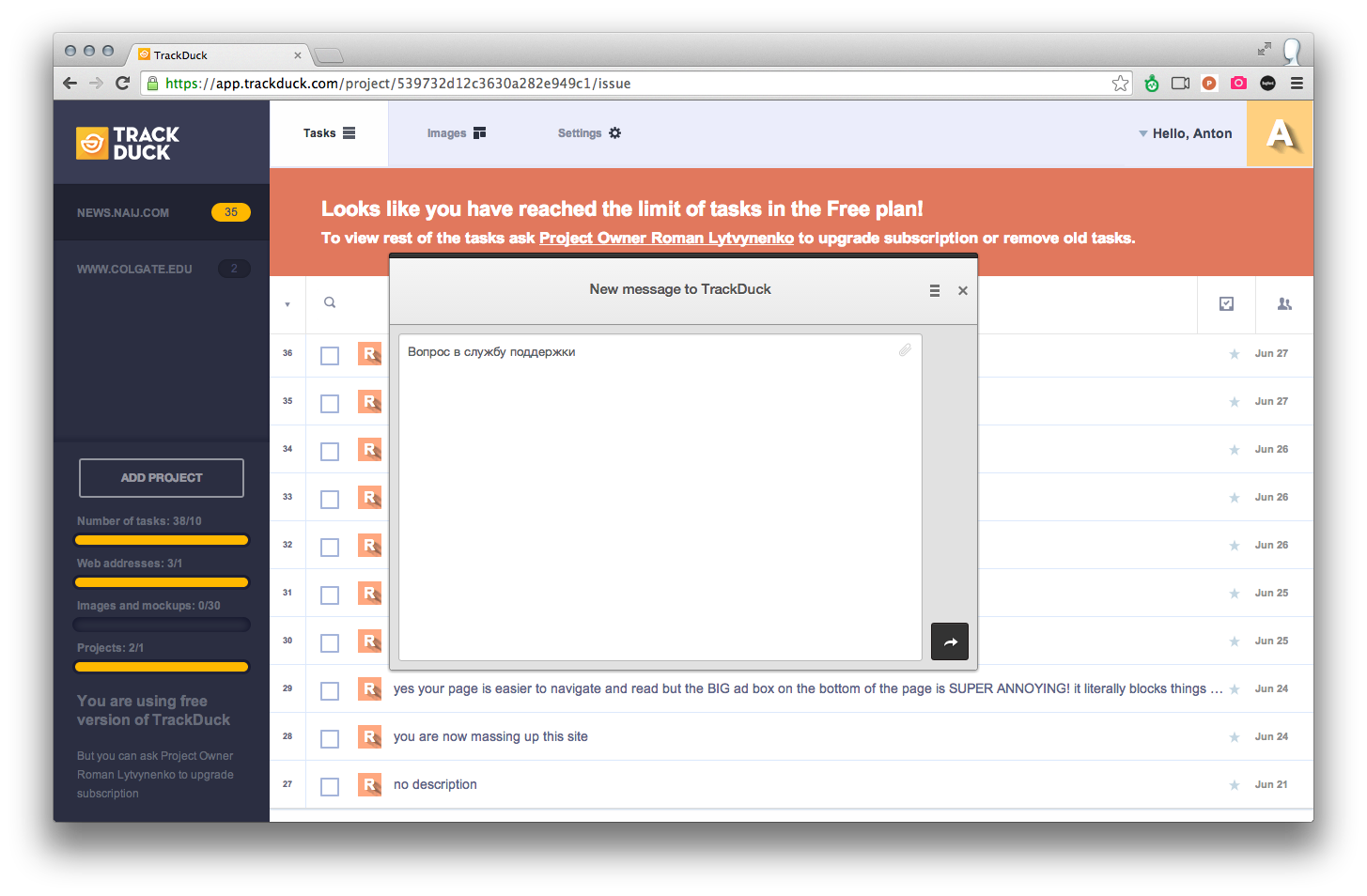

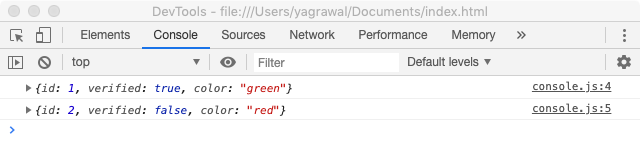

В системе, сконструированной таким образом, API отправляет запросы на воспроизведение. В составе полезной нагрузки каждого валидируемого запроса приходит webhookId и диапазон данных, для которых должны быть воспроизведены события. Эти запросы долговременно хранятся в MySQL и ставятся в очередь до тех пор, пока их не подхватит сервис воспроизведения. Диапазон данных, указанный в запросе, используется, чтобы определить смещение, с которым нужно начать считывание с диска. Функция `offsetForTimes` объекта `Consumer` используется для получения смещений.

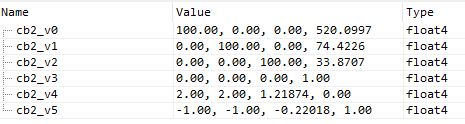

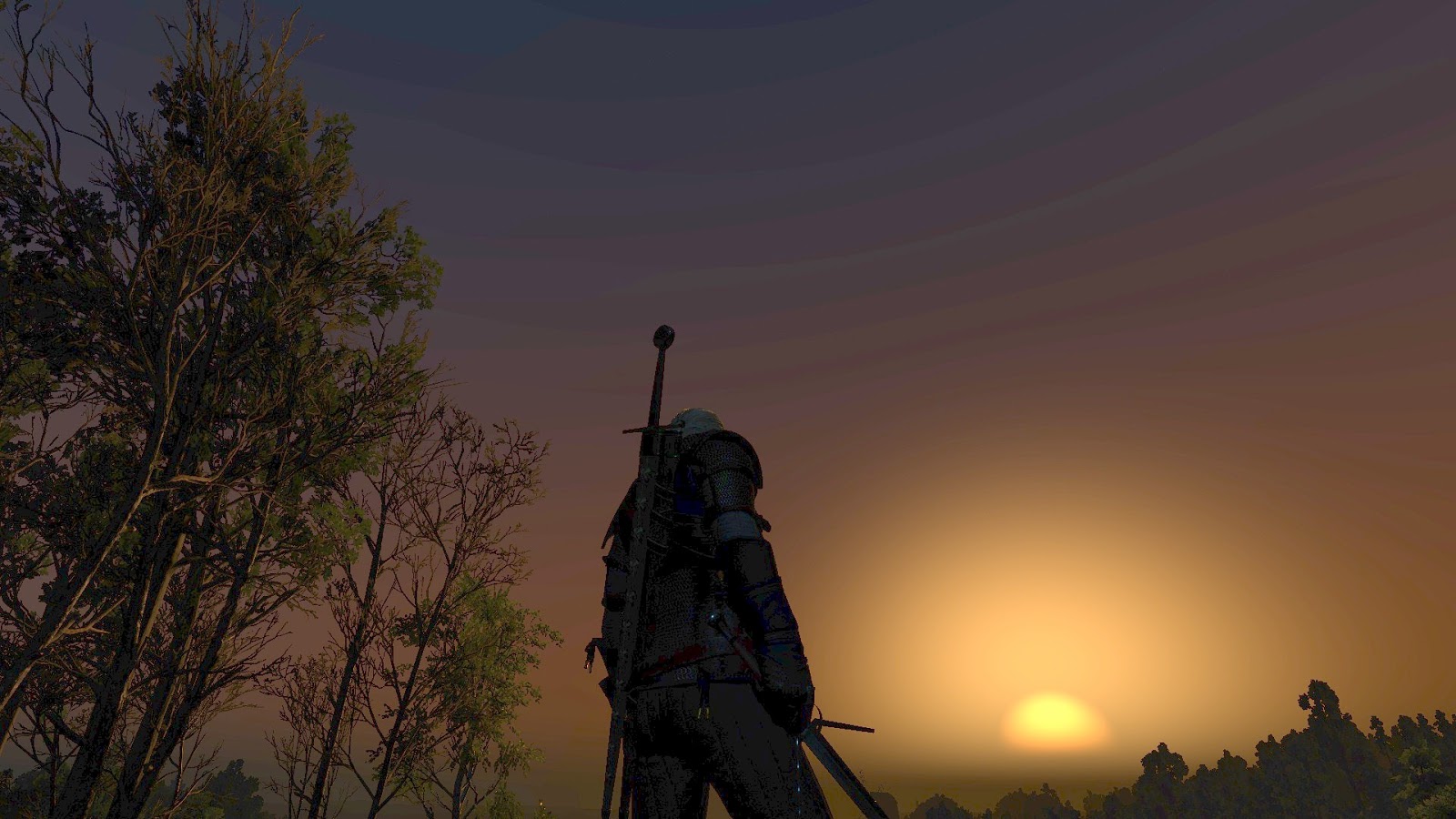

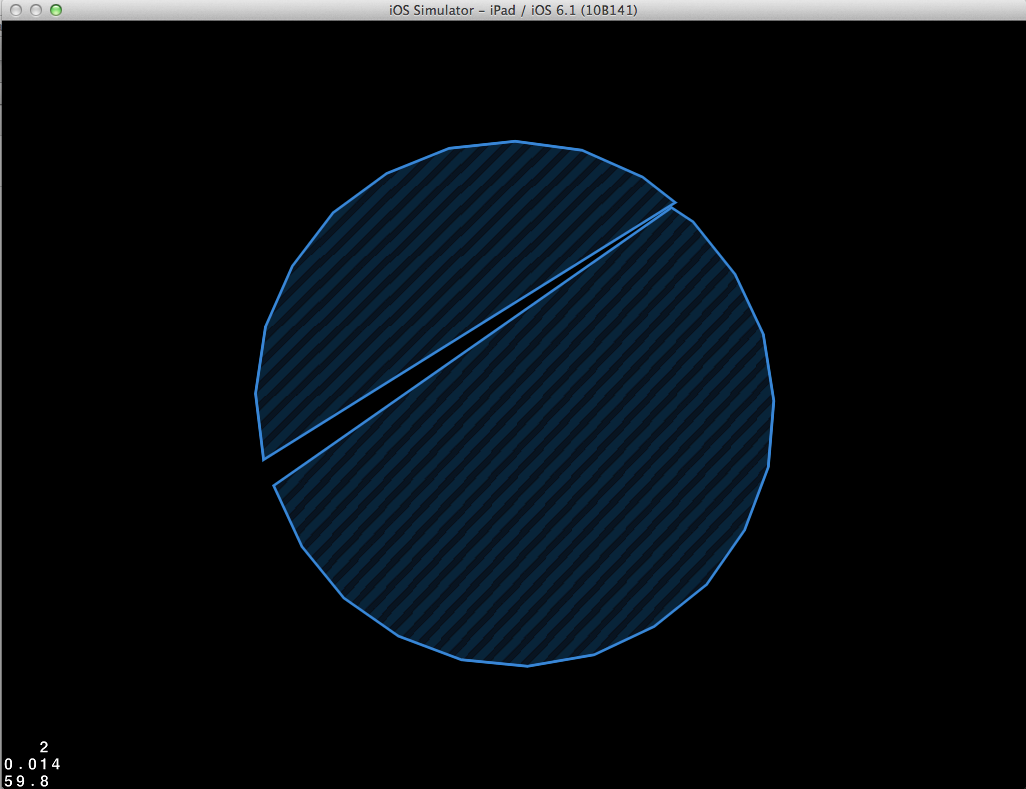

*Рис. 2: Система воспроизведения. Она получает запрос и отправляет его сервису конфигурации (уровень доступа к данным) для дальнейшего долговременного хранения в базе данных.*

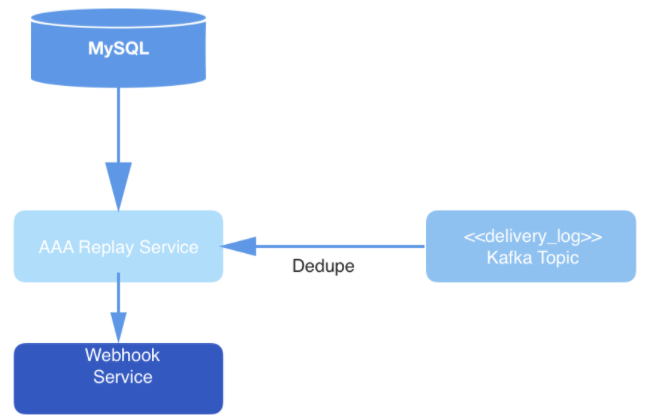

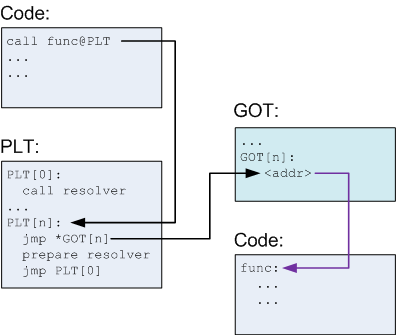

Инстансы сервиса воспроизведения обрабатывают каждый запрос на воспроизведение. Инстансы координируются друг с другом при помощи MySQL, чтобы обработать следующую запись на воспроизведение, хранимую в базе данных. Каждый рабочий процесс, обеспечивающий воспроизведение, периодически опрашивает MySQL, чтобы узнать, нет ли там задания, которое следует обработать. Запрос переходит от состояния к состоянию. Запрос, который не был подхвачен для обработки, находится в состоянии OPEN. Запрос, который только что был выведен из очереди, находится в состоянии STARTED. Запрос, обрабатываемый в данный момент, находится в состоянии ONGOING. Запрос, претерпевший все переходы, оказывается в состоянии COMPLETED. Рабочий процесс, отвечающий за воспроизведение, подбирает только такие запросы, обработка которых еще не началась (то есть, находящиеся в состоянии OPEN).

Периодически, после того, как рабочий процесс выведет запрос из очереди на обработку, он отстукивается в таблице MySQL, оставляя метки времени и демонстрируя тем самым, что задание на воспроизведение до сих пор обрабатывается. В случаях, когда инстанс воспроизводящего рабочего процесса отмирает, не успев закончить обработку запроса, такие задания перезапускаются. Следовательно, воспроизводящие процессы выводят из очереди не только запросы, находящиеся в состоянии OPEN, но и подбирают те запросы, что были переведены в состояние STARTED или ONGOING, но не получили отстука в базе данных, спустя заданное количество минут.

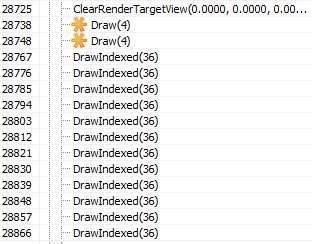

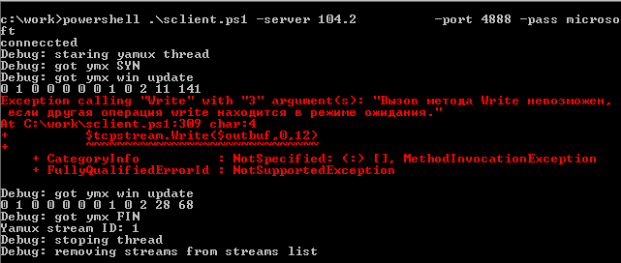

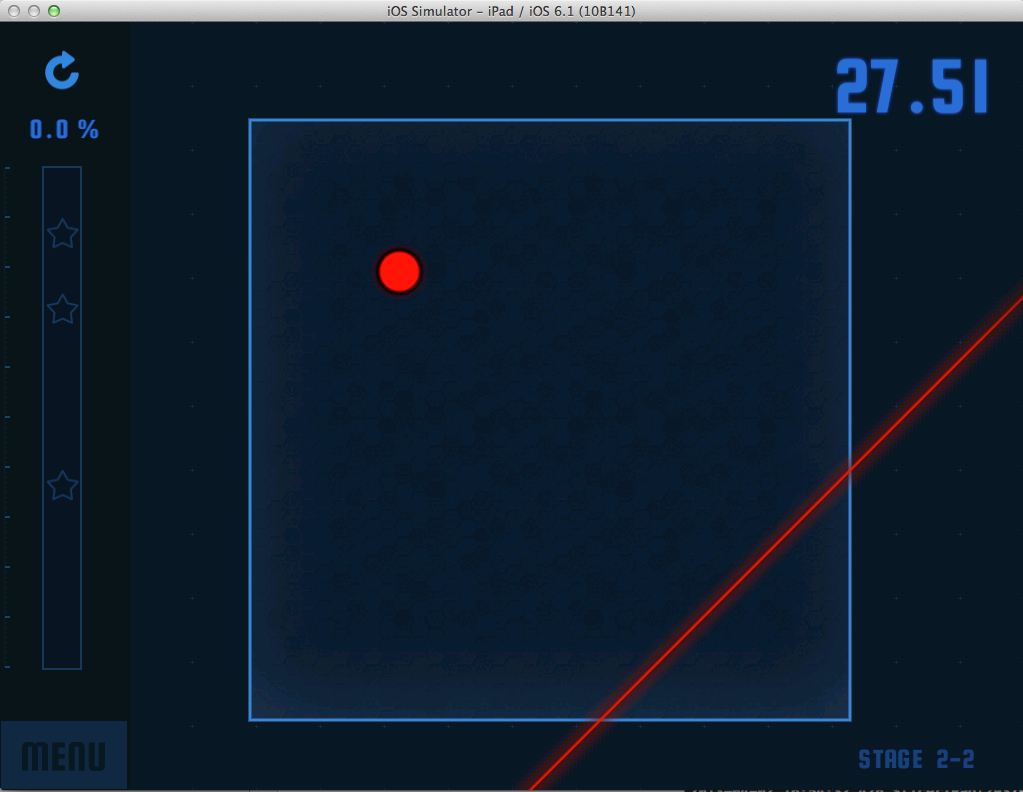

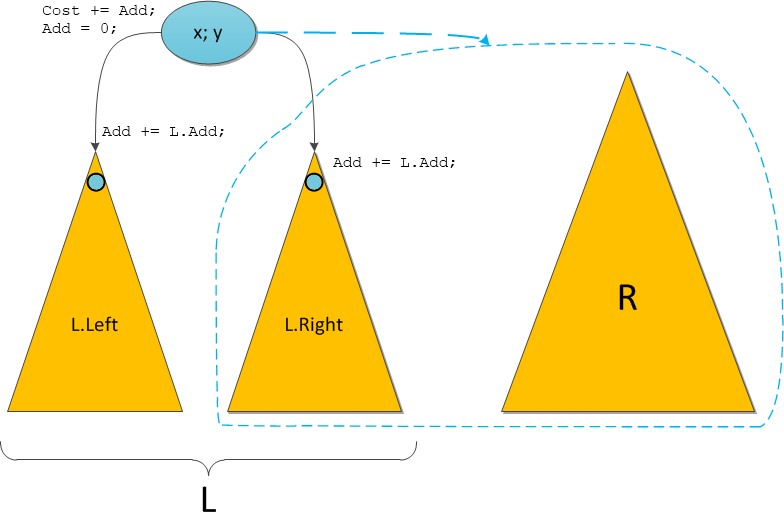

*Рис. 3: Уровень доставки данных: сервис воспроизведения опрашивает MySQL по поводу нового задания на обработку запроса, потребляет запрос из топика Kafka и доставляет события через сервис Webhook.*

В конечном итоге события из топика проходят дедупликацию в процессе считывания, а затем публикуются по URL вебхука конкретного пользователя. Дедупликация выполняется путем ведения кэша считываемых событий, которые при этом хешируются. Если попадется событие с хешем, идентичный которому уже имеется в хэше, то оно доставлено не будет.

В целом, такое использование Kafka нельзя назвать традиционным. Но в рамках описанной системы Kafka успешно работает в качестве хранилища данных и участвует в работе API, который способствует как удобству работы, так и легкости доступа к данным при восстановлении событий. Сильные стороны, имеющиеся в системе для работы в режиме реального времени, пригодились и в рамках такого решения. Кроме того, темпы восстановления данных в такой системе полностью оправдывают ожидания разработчиков.

|

https://habr.com/ru/post/536360/

| null |

ru

| null |

# Справочник фронт-энд девелопера: виды горизонтальных панелей навигации

Предисловие: работая верстальщиком, ваш покорный слуга заметил, что существует несколько типов меню; при этом для верстки каждого из них следует использовать свои приемы.

Подробности — под катом.

Данная статья нацелена скорее на начинающих верстальщиков, но, может быть, матерые профессионалы тоже найдут в ней что-то новое или будут обращаться к ней как к справочнику.

Топик структурирован следующим образом: сначала ставится задача — описывается вид требуемого навигационного блока, затем рассматриваются приемы, позволяющие создать именно такую навигацию.

Подразумевается, что написание стилей ведется под семантически корректную структуру меню, которая выглядит примерно так:

```Домой`

`Сделать заказ`

`Обратная связь```

При верстке под doctype, отличный от html5, элемент nav опускаем или заменяем на соответствующий div.

Что ж, начнем!..

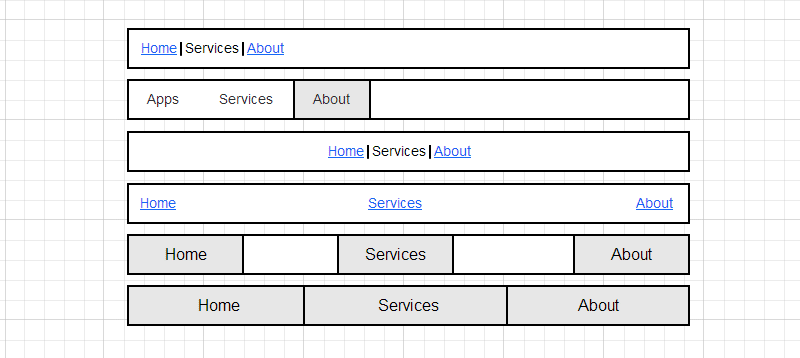

#### Пункты меню, расположенные по правой/левой стороне

В данном разделе рассмотрены навигационные блоки, в которых элементы размещены по правой/левой стороне. Для верстки таких блоков, в зависимости от ситуации, можно использовать несколько способов:

1. display: inline;

2. float: left/right;

3. display: inline-block.

##### Display: inline

**Когда применяем**

Данный способ целесообразно применять при верстке меню простого вида, в котором элементы представлены в виде отдельных слов, не имея padding'ов и разделены лишь пробелами между ними:

**Живой пример**[Blurtopia:](http://www.blurtopia.com/)

**Как делается**

У элементов li в CSS нужно установить свойство display: inline. Кстати, это уберет и ненужные в большинстве меню такого вида маркеры, так как они находятся в дополнительных блоках, которые содержатся у элементов с display: list-item, а у inline'ов отсутствуют.

У ul устанавливаем свойство text-align в значение right или left соответсвенно.

**Примечания**

* При использовании этого варианта стоит помнить, что у inline элементов вертикальные margin'ы не учитываются, но горизонтальные работают;

* при необходимости верстки pixel perfect, есть вероятность столкновения с проблемой: в разных браузерах ширина пробела между элементами разная. Для решения проблемы расстояние между элементами выставляют margin'ами, а [пробелы убирают](http://ruseller.com/lessons.php?rub=29&id=1429);

* если подчеркивание в ссылках элементов меню сделать нижним border'ом, в современных браузерах можно получить красивое анимированное на :hover меню ([JSFiddle](http://jsfiddle.net/kjCL7/3/)).

##### Float: left/right

**Когда применяем**

Когда необходимо сделать меню с элементами, имеющими padding'и и/или фиксированную высоту/ширину:

**Живой пример**Таким способом сверстано верхнее меню [Themeforest](http://themeforest.net/):

**Как делается**

Устанавливаем float: left или float:right элементам li. Если нужно убрать маркеры, нужно добавить display: block или list-style: none.

**Примечания**

* Необходимо «очистить» ul, задав ему класс .clearfix или поместив в его конец элемент с clear: both, иначе у ul высота будет равна нулю; о других способах «очистки» float'ов можно прочитать [здесь](http://habrahabr.ru/post/174443/);

* пример интересного меню, сверстанного float'ами: [html5guy](http://html5guy.com/).

##### Display: inline-block

**Когда применяем**

Задачи те же, что и при верстке с float. И да, при решении такой задачи inline-block пал в неравном бою. Во-первых, кроссбраузерность такого решения ниже, чем у float'a, а во-вторых, между inline-block'ами, как и между inline-элементами, появляются пробелы, зачастую ненужные. Эти проблемы решаемы, но зачем их создавать?

**Как делается**

Устанавливаем display: inline-block элементам li. Ну, а для IE7 (если вы его поддерживаете) прописываем \*display:inline; \*zoom: 1.

#### Симметричные относительно левой и правой сторон блоки навигации

В данном разделе рассмотрены навигационные блоки, расположенные симметрично. Существует несколько видов таких меню; каждому из них соответствует свой способ верстки:

1. пункты меню выровнены по центру;

2. пункты меню равномерно распределены по всей ширине, между элементами имеется промежуток;

3. пункты меню равномерно распределены по всей ширине, элементы заполняют всю ширину ul.

##### Пункты меню выровнены по центру

**Когда применяем**

Меню расположено по центру:

**Живой пример**[Rambler](http://www.rambler.ru/):

**Как делается**

В зависимости от вида пунктов меню, устанавливаем display: inline или display: inline-block (если для пунктов меню предусмотрены padding'и задана ширина и/или высота) элементам li. Родителю (ul) устанавливаем text-align: center.

**Примечания**

Позволю себе повториться: иногда появляется необходимость в том, чтобы убрать пробелы между inline- и inline-block- элементами; несколько способов решения этой задачи можно найти [здесь](http://ruseller.com/lessons.php?rub=29&id=1429).

##### Пункты меню равномерно распределены по всей ширине, между элементами имеется промежуток

**Когда применяем**

Пункты меню равномерно распределены по всей ширине, между отдельными пунктами имеются промежутки:

**Живой пример**К сожалению, меню такого типа найти не удалось, поэтому здесь — пример с [JSFiddle](http://jsfiddle.net/xsvhj/3/).

**Как делается**

В зависимости от вида пунктов меню, устанавливаем display: inline или display: inline-block элементам li. Родителю (ul) устанавливаем text-align: justify. Но сразу justify не заработает — нужно переполнить первую строку (если непонятно почему так — запускаем ворд и пытаемся растянуть несколько слов на всю ширину при помощи justify). Поэтому в конец элемента ul добавляем дополнительный элемент с display: inline-block и width: 100%, или, что лучше, псевдо-элемент ::after с такими же характеристиками.

**Примечания**

Помните, в предыдущих типах меню мы убирали пробелы между элементами со свойством display, установленным в inline и inline-block? Так вот, в этом случае так делать категорически нельзя — браузеру нужны промежутки между пунктами меню. Кстати, если убрать пробелы между некоторыми элементами, можно группировать кнопки ([JSFiddle](http://jsfiddle.net/xsvhj/5/)):

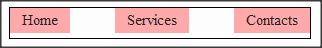

##### Пункты меню равномерно распределены по всей ширине, элементы заполняют всю ширину ul.

**Когда применяем**

Между пунктами меню нет промежутков, любое количество пунктов меню занимает всю ширину:

**Живой пример**[Apple.com](https://www.apple.com/):

Пример подобного меню на JSFiddle можно потрогать [здесь](http://jsfiddle.net/xsvhj/6/).

**Как делается**

При решении данной задачи есть соблазн сверстать меню таблицами; но мы же не собираемся нарушать семантику документа, правда? Поэтому используем display: table-cell для li и display: table для ul; потом задаем ширину для ul

Если нужна поддержка старых браузеров, используем [скрипт-полифилл](http://tanalin.com/projects/display-table-htc/), подменяющий такие блоки на таблицы для IE6 и IE7 или организуем fallback другими способами.

**Примечания**

При верстке меню данным способом нужно помнить, что нельзя размещать элементы с position: absolute относительно table-cell.