text

stringlengths 20

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

# Несколько советов по OpenMP

OpenMP– стандарт, определяющий набор директив компилятора, библиотечных процедур и переменных среды окружения для создания многопоточных программ.

Много статей статей было по OpenMP. Однако, статья содержит несколько советов, которые помогут избежать некоторых ошибок. Эти советы не так часто фигурируют в лекциях или книгах.

##### 1. **Именуйте критические секции**

*В очередь, сукины дети, в очередь!* //М. А. Булгаков «Собачье сердце»

С помощью директивы **critical** мы можем указать участок кода, который будет исполняться только одним потоком в один момент времени. Если один из потоков начал выполнение критической секции с данным именем, то остальные потоки, начавшие выполнение этой же секции, будут заблокированы. Они будут ждать своей очереди. Как только первый поток завершит выполнение секции, один из заблокированных потоков войдет в нее. Выбор следующего потока, который будет выполнять критическую секцию, будет случайным.

```

#pragma omp critical [(имя)] новая строка

структурированный блок

```

Критические секции могут быть именованными или не именованными. В различных ситуациях улучшает производительность. Согласно стандарту все критические секции без имени, будут ассоциированы одним именем. Присвоение имени позволит вам одновременно выполнять две и более критические секции.

Пример:

```

#pragma omp critical (first)

{

workA();

}

#pragma omp critical (second)

{

workB();

}

//секции с workA() и workB() будут выполнены одновременно

#pragma omp critical

{

workC();

}

#pragma omp critical

{

workD();

}

// будет завершена секция с workC() , а только потом с workD()

```

При присвоении имени будьте осторожны, не стоит присваивать имена системных функций или же имена, которые были уже использованы. Если ваши критические секции работают с одним и тем же ресурсом(вывод в один файл, вывод на экран) стоит присвоить одно и тоже имя или же не присваивать вовсе.

##### 2. **Не стоит использовать != в управлении циклом**

Директива for накладывает ограничения на структуру соответствующего цикла. Определенно, соответствующий цикл должен иметь каноническую форму.

Ответ разработчиков из OpenMP Architecture Review Board

Если мы разрешим !=, программисты могут получить неопределенное количество итераций цикла. Проблема в компиляторе когда он генерирует код для вычисления количества итераций.

Для простого цикла как:

```

for( i = 0; i < n; ++i )

```

можно определить количество итераций, n если n>=0, и ноль итераций если n < 0.

```

for( i = 0; i != n; ++i )

```

можно определить n итераций, если n>=0; если n < 0, мы не знаем количество итераций.

```

for( i = 0; i < n; i += 2 )

```

число итераций целая часть от ((n+1)/2) если n >= 0, и 0 если n < 0.

```

for( i = 0; i != n; i += 2 )

```

не можем определить когда i равняется n. Что если n нечетное число?

```

for( i = 0; i < n; i += k )

```

количество итераций наибольшее целое от ((n+k-1)/k) если n >= 0, и 0 если n < 0; в случае, если k < 0, это не допустимая OpenMP программа.

```

for( i = 0; i != n; i += k )

```

i увеличивается или уменьшается? Будет ли равенство? Это все может привести к бесконечному циклу.

##### 3. **Внимательно устанавливайте nowait**

> Если Хатико хочет ждать, он должен ждать.// Хатико: Самый верный друг

Если клауза **nowait** не указана, то конструкция **for** неявно завершится барьерной синхронизацией. В конце параллельного цикла происходит неявная барьерная синхронизация параллельно работающих потоков: их дальнейшее выполнение происходит только тогда, когда все они достигнут данной точки; если в подобной задержке нет необходимости, опция nowait позволяет потокам, уже дошедшим до конца цикла, продолжить выполнение без синхронизации с остальными.

Пример:

```

#pragma omp parallel shared(n,a,b,c,d,sum) private(i) schedule(dynamic)

{

#pragma omp for nowait

for (i = 0; i < n; i++)

a[i] += b[i];

#pragma omp for nowait

for (i = 0; i < n; i++)

c[i] += d[i];

#pragma omp for nowait reduction(+:sum)

for (i = 0; i < n; i++)

sum += a[i] + c[i];

}

```

Данном примере есть ошибка, она заключается в **schedule(dynamic)**. Дело в том, что зависимых по данным циклы **nowait** допустим только c **schedule(static)**. Только в этом способе планирования работ стандарт гарантирует корректную работу c **nowait** для циклов зависимых по данным. В нашем случае достаточно стереть **schedule(dynamic)** в большинстве реализаций по умолчанию используется **schedule(static)**.

##### 4. **Тщательно проверьте код перед использованием task untied**

```

int dummy;

#pragma omp threadprivate(dummy)

void foo() {dummy = …; }

void bar() {… = dummy; }

#pragma omp task untied

{

foo();

bar();

}

```

**task untied** специфицирует, что задача не привязана к потоку, который начал ее исполнять. Другой поток может продолжить исполнение задачи после приостановки. В данном примере неправильное использование **task untied**. Программист предполагает, что обе функции в задаче будут исполнены одним потоком. Однако, если после приостановки задачи bar() будет выполнен другим. По причине того, что у каждого потока своя переменная dummy (в нашем случае она **threadprivate** ). Присвоение в bar() произойдет некорректное.

Надеюсь, данные советы помогут начинающим.

**Полезные ссылки:**

[Примеры OpenMP 4.0 pdf](http://openmp.org/mp-documents/openmp-examples-4.0.2.pdf)

[Примеры OpenMP 4.0 github](https://github.com/OpenMP/Examples)

[Стандарт OpenMP 4.0 pdf](http://www.openmp.org/mp-documents/OpenMP4.0.0.pdf)

[Все директивы на 4 листах C++ pdf](http://openmp.org/mp-documents/OpenMP-4.0-C.pdf)

[Все директивы на 4 листах Fortran pdf](http://openmp.org/mp-documents/OpenMP-4.0-Fortran.pdf)

[Одни из лучших слайдов по OpenMP на русском языке от Михаила Курносова pdf](https://yadi.sk/d/anm7BiVzgxekT)

|

https://habr.com/ru/post/259153/

| null |

ru

| null |

# Vanilla JS — очень мощный javascript-фреймворк

Как ни странно, на Хабре упоминание этого мощнейшего фреймворка нашлось лишь в одном комментарии от апреля 2012 года.

### Вступление

Для меня эта тема особенно актуальна, ведь последнее время на Хабре упоминается огромное количество js-фреймворков. Какие-то из них авторы [различных проектов](http://habrahabr.ru/post/138071/) находят в Сети, какие-то — пишут сами, ~~не очень понимая зачем~~. Кто-то просто пишет [свои велосипеды](http://habrahabr.ru/post/138939/).

Моё же мнение — надо стремиться к отсутствию избыточного кода, к максимальному минимализму, простите за тавтологию.

Если на весь сайт вам нужно только выбирать html-элементы по их id — глупо подключать jQuery.

Если вам на Node.js проекте [надо собрать пачку js-файлов и сжать их](http://habrahabr.ru/post/150496/) — глупо писать или подключать тяжёлые фреймворки с кучей настроек, параметров, дополнений и методов, ведь простейший скрипт, склеивающий файлы и прогоняющий их через Кроукфордский jsmin будет намного быстрее, надёжнее и проще.

Чем больше кода — тем больше ошибок. Чем больше стороннего кода — тем сложнее поддерживать проект. Ведь когда вы берёте чужой код, вы берёте на себя и ответственность за его поддержку. Нельзя будет сказать «этот баг не мой, а вон из той библиотеки».

### Vanilla JS

Итак, начнём обзор этого мощнейшего и самого популярного в мире JS-фреймворка.

###### (далее — перевод с [официального сайта фреймворка](http://vanilla-js.com/))

> Команда Vanilla JS поддерживает каждый байт кода фреймворка и каждый день много трудится, чтобы сделать его маленьким и интуитивным.

>

> Кто использует Vanilla JS? Хорошо, что вы спросили, вот несколько примеров: Facebook, Google, YouTube, Yahoo, Wikipedia, Windows Live, Twitter, Amazon, LinkedIn, MSN, eBay, Microsoft, Tumblr, Apple, Pinterest, PayPal, Reddit, Netflix, Stack Overflow.

>

>

>

> Вообще-то, Vanilla JS уже используется на большем количестве сайтов, чем jQuery, Prototype JS, MooTools, YUI и Google Web Toolkit **вместе взятые**!

На сайте вы можете скачать фреймворк, выбрав нужную вам функциональность:

* DOM (Манипуляции / Селекторы)

* Прототипная система объектов

* AJAX

* Анимации

* Система событий

* Регулярные выражения

* Функции как объекты

* Замыкания

* Библиотеку математических методов

* Библиотеку для работы с массивами

* Библиотеку для работы со строками

Плюс можете настроить вашу сборку:

* Сжать исходники

* В кодировке UTF8

* Использовать «CRLF» переносы строк (Windows)

При максимальной комплектации фреймворк будет весить:

Несжатый: 0 байт, сжатый: 25 байт.

##### Деплоймент

Команда Vanilla JS гордится тем фактом, что это самый лёгкий фреймворк всех времён; используйте нашу стратегию выкладки на продакшн, и браузеры ваших пользователей загрузят Vanilla JS в память ещё даже до того, как начнут загружать ваш сайт.

Чтобы подключить Vanilla JS, просто добавьте следующую строку в ваш HTML:

Когда будете готовы выложить свой проект на продакшн, смените подключение на намного более быстрый метод:

```

```

Всё верно, совсем без кода. Vanilla JS настолько популярна, что браузеры автоматически загружают фреймворк уже лет десять.

#### Сравнение скорости работы с другими фреймворками

##### Поиск DOM-элемента по ID

| Фреймворк | Код | Оп.\сек |

| --- | --- | --- |

| Vanilla JS |

```

document.getElementById('test-table');

```

| 12,137,211 |

| Dojo |

```

dojo.byId('test-table');

```

| 5,443,343 |

| Prototype JS |

```

$('test-table')

```

| 2,940,734 |

| Ext JS |

```

delete Ext.elCache['test-table']; Ext.get('test-table');

```

| 997,562 |

| jQuery |

```

$jq('#test-table');

```

| 350,557 |

| YUI |

```

YAHOO.util.Dom.get('test-table');

```

| 326,534 |

| MooTools |

```

document.id('test-table');

```

| 78,802 |

##### Поиск элементов по названию тэга

| Фреймворк | Код | Оп.\сек |

| --- | --- | --- |

| Vanilla JS |

```

document.getElementsByTagName("span");

```

| 8,280,893 |

| Prototype JS |

```

Prototype.Selector.select('span', document);

```

| 62,872 |

| YUI |

```

YAHOO.util.Dom.getElementsBy(function(){return true;},'span');

```

| 48,545 |

| Ext JS |

```

Ext.query('span');

```

| 46,915 |

| jQuery |

```

$jq('span');

```

| 19,449 |

| Dojo |

```

dojo.query('span');

```

| 10,335 |

| MooTools |

```

Slick.search(document, 'span', new Elements);

```

| 5,457 |

#### Примеры кода

##### Плавно скрыть элемент

| | |

| --- | --- |

| Vanilla JS |

```

var s = document.getElementById('thing').style;

s.opacity = 1;

(function(){(s.opacity-=.1)<0?s.display="none": setTimeout(arguments.callee,40)})();

```

|

| jQuery |

```

$('#thing').fadeOut();

```

|

##### AJAX-вызов

| | |

| --- | --- |

| Vanilla JS |

```

var r = new XMLHttpRequest();

r.open("POST", "path/to/api", true);

r.onreadystatechange = function () {

if (r.readyState != 4 || r.status != 200) return;

alert("Success: " + r.responseText);

};

r.send("banana=yellow");

```

|

| jQuery |

```

$.ajax({

type: 'POST',

url: "path/to/api",

data: "banana=yellow",

success: function (data) {

alert("Success: " + data);

},

});

```

|

##### Заключение

Больше информации о Vanilla JS вы можете найти по ссылкам:

* [Документация](https://developer.mozilla.org/en-US/docs/JavaScript) по Vanilla JS

* Различные [книги](http://www.amazon.com/s?field-keywords=javascript) по Vanilla JS

* или попробуйте что-нибудь из [плагинов](http://en.wikipedia.org/wiki/Comparison_of_JavaScript_frameworks) для Vanilla JS

Когда вы фигачите ваш проект на Vanilla JS, можете использовать эту удобную кнопку:

##### --

###### от автора поста

Что ж, пожалуй, это и вправду самый лучший JS-фреймворк!

Советую, в первую очередь, рассматривать именно его, и лишь при острой необходимости браться за что-то другое.

|

https://habr.com/ru/post/150594/

| null |

ru

| null |

# Как создавать компактный и эффективный javascript используя RollupJS

Последнее время все чаще и чаще на ряду с другими сборщиками javascript стал встречать rollupJS. И даже стал использовать его для написания модулей, используемых в основном проекте компании. Поэтому хочу поделиться с вами переводом стать об этом компактном и удобном сборщике.

*Стиль — авторский.*

Узнаете, об использовании Rollup как более компактную и эффективную альтернативу webpack и Browserify для объединения файлов JavaScript.

В конце этого руководства мы сконфигурируем Rollup для:

* объединения нашего скрипта,

* удаления неиспользуемого кода,

* трансплайнинг его для работы со старыми браузерами,

* поддержки использования модулей Node в браузере,

* работы с переменными окружения и

* оптимизации нашего кода для уменьшения размера выходного файла

### Предварительные требования

* Начальные знания в JavaScript.

* Первоначальное знакомство с [модулями ES2015](https://github.com/getify/You-Dont-Know-JS/blob/master/es6%20%26%20beyond/ch3.md#modules) также не повредит.

* На вашем компьютере должен быть установлен `npm`. (У вас его нет? Установите Node.js [здесь](https://nodejs.org/).)

### Что такое Rollup?

Как описывают сами разработчики:

> Rollup — это инструмент следующего поколение для пакетной обработки JavaScript-модулей. Создайте свое приложение или библиотеку с помощью модулей ES2015, затем объедините их в один файл для эффективного использования в браузерах и Node.js. Это похоже на использование Browserify и webpack. Вы можете также назвать Rollup инструментом построения, который стоит на одном ряду с такими инструментами как Grunt и Gulp. Тем не менее, важно отметить, что, хотя вы можете использовать Grunt и Gulp для решения задач пакетной обработки JavaScript, эти инструменты будут использовать подобный функционал Rollup, Browserify или webpack.

>

>

### Почему вам может помочь Rollup?

Что может делать Rollup точно, дак это формировать по настоящему оптимизированные по размеру файлы. И если без скучных и нудных формальностей, то подытожить можно так: по сравнению с другими средствами для пакетной обработки JavaScript, Rollup почти всегда будет создавать меньший по объему пакет, и делать это быстрее.

Это происходит потому, что Rollup основан на модулях ES2015, которые являются более эффективными, чем модули CommonJS, которые используются в Browserify и webpack. Кроме того, Rollup гораздо проще удалить неиспользуемый код из модулей используя *tree-shaking*, что в итоге означает, что только тот код, который нам действительно нужен, будет включен в окончательный пакет.

Tree-shaking становится очень эффективным, когда мы используем сторонние библиотеки или фреймворки, в которых есть десятки доступных функций и методов. Если мы используем только один или два метода — например, lodash или jQuery — то загрузка библиотеки полностью несет за собой много лишних накладных расходов.

В настоящее время Browserify и webpack при сборке включают в себя много неиспользуемого кода. Но Rollup этого не делает — в сборку включается только то, что мы фактически используем.

**UPDATE (2016-08-22)**Для прояснить: Rollup может использовать tree-shaking только на ES-модулях. К модулям CommonJS, которыми, на момент написания, являются как lodash, так и jQuery, не может быть применен tree-shaking. Тем не менее, tree-shaking — это одно из преимуществ Rollup на ряду с основным в виде соотношения скорость/производительность. Смотрите так же [пояснение Ричарда Харриса](https://www.reddit.com/r/javascript/comments/4yprc5/how_to_bundle_javascript_with_rollup_stepbystep/d6qzgzm) и дополнительную [информацию Нолана Лоусона](https://www.reddit.com/r/javascript/comments/4yprc5/how_to_bundle_javascript_with_rollup_stepbystep/d6qzmgh?context=3).

**Примечание**Частично из-за эффективности Rollup, webpack 2 будет иметь поддержку tree-shaking.

### Как использовать Rollup для обработки и сборки JavaScript-файлов?

Чтобы показать, насколько эффективен Rollup, давайте рассмотрим процесс создания чрезвычайно простого проекта, который использует Rollup для сборки JavaScript.

#### ШАГ 0: СОЗДАНИЕ ПРОЕКТА С JAVASCRIPT И CSS.

Для начала нам нужно иметь код, с которым можно работать. В этом уроке мы будем работать с небольшим приложением, доступным на [GitHub](https://github.com/jlengstorf/learn-rollup).

Структура папки выглядит так:

`learn-rollup/

├── build/

│ └── index.html

├── src/

│ ├── scripts/

│ │ ├── modules/

│ │ │ ├── mod1.js

│ │ │ └── mod2.js

│ │ └── main.js

│ └── styles/

│ └── main.css

└── package.json`

Вы можете установить приложение, с которым мы будем работать во время этого руководства, выполнив следующую команду в своем терминале.

```

# Move to the folder where you keep your dev projects.

cd /path/to/your/projects

# Clone the starter branch of the app from GitHub.

git clone -b step-0 --single-branch https://github.com/jlengstorf/learn-rollup.git

# The files are downloaded to /path/to/your/projects/learn-rollup/

```

**Примечание**Если вы не клонируете repo, обязательно скопируйте содержимое `build/index.html` в свой собственный код. В этом руководстве HTML не рассматривается.

#### ШАГ 1: УСТАНОВКА ROLLUP И СОЗДАНИЕ ФАЙЛА КОНФИГУРАЦИИ.

Чтобы начать работу, установите Rollup с помощью следующей команды:

```

npm install --save-dev rollup

```

Затем создайте новый файл с именем `rollup.config.js` в папке `learn-rollup`. В него добавьте следующее.

```

export default {

entry: 'src/scripts/main.js',

dest: 'build/js/main.min.js',

format: 'iife',

sourceMap: 'inline',

};

```

Давайте поговорим о каждой опции данной конфигурации:

* Entry — это файл, который мы хотим, чтобы Rollup обрабатывал. В большинстве приложений это будет основной JavaScript-файл, который инициализирует все и является точкой входа.

* Dest — это место, где будут сохранены обработанные скрипты.

* Format — Rollup поддерживает несколько форматов вывода. Поскольку мы работаем в браузере, мы хотим использовать [немедленно вызываемые функции](http://benalman.com/news/2010/11/immediately-invoked-function-expression/) (IIFE)

**Сноска**Это довольно сложная концепция для понимания, но если в двух словах, мы хотим, чтобы наш код находился внутри своей собственной области видимости, которая предотвращает конфликты с другими скриптами. IIFE — это [замыкание](http://skilldrick.co.uk/2011/04/closures-explained-with-javascript/), которое содержит весь наш код в его собственной области видимости.

* SourceMap — это очень полезно для отладки, чтобы предоставить карту исходного кода. Эта опция добавляет карту к сгенерированному файлу, что упрощает данную задачу.

**Примечание**Для более подробной информации по опции `format`, см. [Rollup's Wiki](https://github.com/rollup/rollup/wiki/JavaScript-API#format).

ПРОВЕРКА КОНФИГУРАЦИИ ROLLUP

После того, как мы создали файл конфигурации, мы можем проверить, что все работает, запустив следующую команду в нашем терминале:

```

./node_modules/.bin/rollup -c

```

Это создаст новую папку под названием `build` в вашем проекте с подпапкой `js`, которая будет содержать наш сгенерированный файл `main.min.js`.

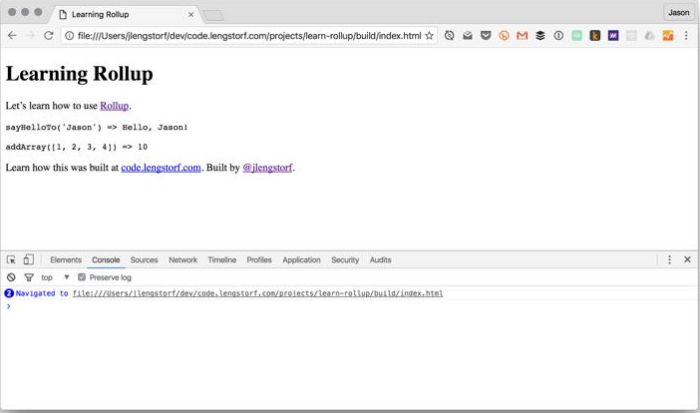

Мы увидим, что пакет был создан правильно, открыв `build/index.html` в нашем браузере:

**Примечание**На этом этапе только современные браузеры будут работать без ошибок. Чтобы этот код работал со старыми браузерами, которые не поддерживают ES2015 / ES6, нам нужно добавить некоторые плагины.

РАЗБИРАЕМ СГЕНЕРИРОВАННЫЙ ПАКЕТ

Использование tree-shaking делает Rollup мощным инструментом, и благодаря чему в выходном файле нет неиспользованного кода из модулей, на которые мы ссылаемся. Например, в `src/scripts/modules/mod1.js` есть функция `sayGoodbyeTo ()`, которая не используется в нашем приложении — и поскольку она никогда не используется, Rollup не включает ее в итоговый пакет:

**Код**

```

(function () {

'use strict';

/**

* Says hello.

* @param {String} name a name

* @return {String} a greeting for `name`

*/

function sayHelloTo( name ) {

const toSay = `Hello, ${name}!`;

return toSay;

}

/**

* Adds all the values in an array.

* @param {Array} arr an array of numbers

* @return {Number} the sum of all the array values

*/

const addArray = arr => {

const result = arr.reduce((a, b) => a + b, 0);

return result;

};

// Import a couple modules for testing.

// Run some functions from our imported modules.

const result1 = sayHelloTo('Jason');

const result2 = addArray([1, 2, 3, 4]);

// Print the results on the page.

const printTarget = document.getElementsByClassName('debug__output')[0];

printTarget.innerText = `sayHelloTo('Jason') => ${result1}\n\n`

printTarget.innerText += `addArray([1, 2, 3, 4]) => ${result2}`;

}());

//# sourceMappingURL=data:application/json;charset=utf-8;base64,...

```

В других инструментах сборки это не всегда так, и сгенерированные пакеты могут быть действительно большими, если мы включим большую библиотеку, такую как [lodash](https://lodash.com/), для ссылки на одну или две функции.

Например, с помощью [webpack](https://webpack.github.io/) включена функция `sayGoodbyeTo ()`, и полученный в результате пакет более чем в два раза превышает размер, который генерирует Rollup.

**Сноска**Однако важно помнить, что, когда мы имеем дело с таким небольшим тестовыми приложениями, удвоение размера файла не занимает много времени. Для сравнения на данный момент этот размер составляет ~ 3KB против ~ 8KB

#### ШАГ 2: УСТАНОВИТЕ BABEL, ЧТО БЫ ИСПОЛЬЗОВАТЬ НОВЫЕ ВОЗМОЖНОСТИ JAVASCRIPT СЕЙЧАС

На данный момент у нас есть код, который будет работать только в современных браузерах, и не будет работать в некоторых браузерах, версия которых отстает на несколько версий — и это не идеально.

К счастью, [Babel](https://babeljs.io/) может нам помочь. Этот проект позволяет [трансплировать](https://scotch.io/tutorials/javascript-transpilers-what-they-are-why-we-need-them) новые возможности JavaScript ([ES6/ES2015 и т.д.](https://github.com/getify/You-Dont-Know-JS/blob/master/es6%20%26%20beyond/ch1.md)) в ES5, и данный код будет работать практически в любом браузере, который все еще может использоваться сегодня.

Если вы никогда не пользовались Babel, ваша жизнь разработчика изменяться навсегда. Доступ к новым функциям JavaScript делает язык проще, чище и приятнее в целом.

Поэтому давайте сделаем его частью нашего процесса сборки, чтобы об этом больше не думать.

УСТАНОВКА НЕОБХОДИМЫХ МОДУЛЕЙ

Сперва, нам нужно установить [плагин Babel Rollup](https://github.com/rollup/rollup-plugin-babel) и [соответствующие Babel-пресеты](https://www.npmjs.com/package/babel-preset-es2015).

```

# Install Rollup’s Babel plugin.

npm install --save-dev rollup-plugin-babel

# Install the Babel preset for transpiling ES2015.

npm install --save-dev babel-preset-es2015

# Install Babel’s external helpers for module support.

npm install --save-dev babel-plugin-external-helpers

```

**Примечание**Babel-пресеты представляет собой набор плагинов Babel, которые указывают Babel, что мы на самом деле хотим трансплировать

СОЗДАНИЕ `.babelrc`.

Затем создайте новый файл с именем `.babelrc` в корневом каталоге проекта `(learn-rollup/`). Внутри добавьте следующий JSON:

```

{

"presets": [

[

"es2015",

{

"modules": false

}

]

],

"plugins": [

"external-helpers"

]

}

```

Это сообщает Babel, какой пресет он должен использовать во время трансплирования.

**Примечание**В более ранних версиях npm (2.15.11) вы можете увидеть ошибку с пресетом `es2015-rollup`. Если вы не можете обновить `npm`, см. [эту проблему](https://github.com/jlengstorf/learn-rollup/issues/2) для альтернативной конфигурации `.babelrc`.

**UPDATE (2016-11-13)**В видео `.babelrc` использует устаревшую конфигурацию. См. [этот pull request для изменения конфигурации](https://github.com/jlengstorf/learn-rollup/pull/17), и [этот для изменений](https://github.com/jlengstorf/learn-rollup/pull/37) в `package.json`.

ОБНОВЛЕНИЕ `rollup.config.js`.

Чтобы добавить Babel к Rollup, нужно обновить rollup.config.js. Внутри мы импортируем плагин Babel, а затем добавляем его в новое свойство конфигурации, называемое plugins, которое будет содержать массив плагинов.

```

// Rollup plugins

import babel from 'rollup-plugin-babel';

export default {

entry: 'src/scripts/main.js',

dest: 'build/js/main.min.js',

format: 'iife',

sourceMap: 'inline',

plugins: [

babel({

exclude: 'node_modules/**',

}),

],

};

```

Чтобы избежать транплирования сторонних скриптов, мы устанавливаем свойство `exclude` для игнорирования каталога `node_modules`.

ПРОВЕРКА ВЫХОДНОГО ПАКЕТА

Со всем установленным и настроенным, мы можем сделать ребилд пакета:

```

./node_modules/.bin/rollup -c

```

Когда мы смотрим на результат, то он выглядит *примерно* так же. Но есть несколько ключевых отличий: например, посмотрите на функцию `addArray ()`:

```

var addArray = function addArray(arr) {

var result = arr.reduce(function (a, b) {

return a + b;

}, 0);

return result;

};

```

Посмотрите, как Babel преобразовал [«жирную» стрелку для функции](https://strongloop.com/strongblog/an-introduction-to-javascript-es6-arrow-functions/) `(arr.reduce ((a, b) => a + b, 0))` в обычную функцию.

Это транспиляция в действии: результат тот же, но код теперь поддерживается в IE9.

**Важно**Babel также предлагает [babel-polyfill](https://babeljs.io/docs/usage/polyfill/), что делает вещи вроде `Array.prototype.reduce ()` доступными в IE8 и более раних версиях.

#### ШАГ 3: ДОБАВЛЕНИЕ ESLINT ДЛЯ ПРОВЕРКИ JAVASCRIPT НА ОШИБКА

Всегда полезно использовать linter для вашего кода, поскольку он обеспечивает согласованную практику кодирования и помогает находить сложные ошибки, например отсутствующие операторные или круглые скобки.

Для этого проекта мы будем использовать [ESLint](http://eslint.org/).

УСТАНОВКА МОДУЛЯ

Чтобы использовать ESLint, нам необходимо установить [плагин ESLint Rollup](https://github.com/TrySound/rollup-plugin-eslint):

```

npm install --save-dev rollup-plugin-eslint

```

ГЕНЕРИРОВАНИЕ `.eslintrc.json`.

Чтобы убедиться, что мы получаем только ошибки, которые нам нужны, мы должны сначала настроить ESLint. К счастью, мы можем автоматически создать большую часть этой конфигурации, выполнив следующую команду:

**Терминал**

```

$ ./node_modules/.bin/eslint --init

? How would you like to configure ESLint? Answer questions about your style

? Are you using ECMAScript 6 features? Yes

? Are you using ES6 modules? Yes

? Where will your code run? Browser

? Do you use CommonJS? No

? Do you use JSX? No

? What style of indentation do you use? Spaces

? What quotes do you use for strings? Single

? What line endings do you use? Unix

? Do you require semicolons? Yes

? What format do you want your config file to be in? JSON

Successfully created .eslintrc.json file in /Users/jlengstorf/dev/code.lengstorf.com/projects/learn-rollup

```

Если вы ответите на вопросы, как показано выше, вы получите следующий результат в `.eslintrc.json`:

**.eslintrc.json**

```

{

"env": {

"browser": true,

"es6": true

},

"extends": "eslint:recommended",

"parserOptions": {

"sourceType": "module"

},

"rules": {

"indent": [

"error",

4

],

"linebreak-style": [

"error",

"unix"

],

"quotes": [

"error",

"single"

],

"semi": [

"error",

"always"

]

}

}

```

TWEAK `.eslintrc.json`

Однако мы должны внести несколько корректировок, чтобы избежать ошибок для нашего проекта:

1. Мы используем 2 пробела вместо 4.

2. Позднее мы будем использовать глобальную переменную, названную `ENV`, поэтому нам нужно занести ее в белый список.

Внесите следующие изменения в свою настройку `.eslintrc.json` — свойство `globals` и настройку свойства `indent`:

**.eslintrc.json**

```

{

"env": {

"browser": true,

"es6": true

},

"globals": {

"ENV": true

},

"extends": "eslint:recommended",

"parserOptions": {

"sourceType": "module"

},

"rules": {

"indent": [

"error",

2

],

"linebreak-style": [

"error",

"unix"

],

"quotes": [

"error",

"single"

],

"semi": [

"error",

"always"

]

}

}

```

ОБНОВЛЕНИЕ `rollup.config.js`

Затем импортируйте плагин ESLint и добавьте его в конфигурацию Rollup:

```

// Rollup plugins

import babel from 'rollup-plugin-babel';

import eslint from 'rollup-plugin-eslint';

export default {

entry: 'src/scripts/main.js',

dest: 'build/js/main.min.js',

format: 'iife',

sourceMap: 'inline',

plugins: [

eslint({

exclude: [

'src/styles/**',

]

}),

babel({

exclude: 'node_modules/**',

}),

],

};

```

ПРОВЕРКА РЕЗУЛЬТАТОВ В КОНСОЛИ

Когда мы запускаем `./node_modules/.bin/rollup -c`, похоже, ничего не происходит. Дело в том, что код приложения в его нынешнем виде проходит linter без проблем.

Но если мы введем проблему, например удаление точки с запятой, мы увидим, как ESLint помогает:

```

$ ./node_modules/.bin/rollup -c

/Users/jlengstorf/dev/code.lengstorf.com/projects/learn-rollup/src/scripts/main.js

12:64 error Missing semicolon semi

1 problem (1 error, 0 warnings)

```

Потенциально что может содержать скрытую ошибку, теперь сразу же видно, включая файл, строку и столбец, где обнаружена проблема.

Хотя это не избавит нас от всех наших ошибок при отладке, но это значительно ускоряет данный процесс, исключая ошибок, вызванных очевидными опечатками.

**Сноска**Наверное многие из нас потратили многочисленные часы, отлавливая ошибки, которые в итоге оказались чем-то таким же глупым, как название с ошибкой, трудно преувеличить повышение эффективности работы от использования линтера.

#### ШАГ 4: ДОБАВЛЕНИЕ ПЛАГИНА ДЛЯ ОБРАБОТКИ НЕ ES-МОДУЛЕЙ

Это важно, если вы используете в своей сборке Node-style модулей. Не используя этот плагин вы получите сообщение об ошибке при подключении данной библиотеки используя `require`.

ДОБАВЛЕНИЕ NODE-МОДУЛЕЙ КАК ЗАВИСИМОСТИ

Было бы легко взломать этот примерный проект без ссылки на сторонний модуль, но это не собирается сокращать его в реальных проектах. Поэтому, чтобы сделать нашу настройку Rollup действительно полезной, давайте убедимся, что мы можем также ссылаться на сторонние модули в нашем коде.

Для простоты мы добавим простой регистратор в наш код, используя пакет `debug`. Начните с его установки:

```

npm install --save debug

```

**Примечание**Поскольку это будет указано в основном проекте, важно использовать --save, что позволит избежать ошибки в продакшене, где devDependencies будет игнорирована.

Затем, внутри `src/scripts/main.js`, давайте добавим простой логинг:

**main.js**

```

// Import a couple modules for testing.

import { sayHelloTo } from './modules/mod1';

import addArray from './modules/mod2';

// Import a logger for easier debugging.

import debug from 'debug';

const log = debug('app:log');

// Enable the logger.

debug.enable('*');

log('Logging is enabled!');

// Run some functions from our imported modules.

const result1 = sayHelloTo('Jason');

const result2 = addArray([1, 2, 3, 4]);

// Print the results on the page.

const printTarget = document.getElementsByClassName('debug__output')[0];

printTarget.innerText = `sayHelloTo('Jason') => ${result1}\n\n`;

printTarget.innerText += `addArray([1, 2, 3, 4]) => ${result2}`;

```

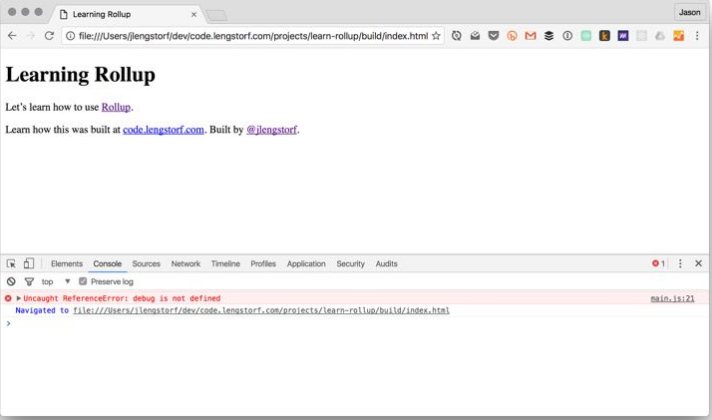

При запуске rollup, мы получаем предупреждение:

```

$ ./node_modules/.bin/rollup -c

Treating 'debug' as external dependency

No name was provided for external module 'debug' in options.globals – guessing 'debug'

```

И если мы снова запустим наш index.html, мы увидим, что в консоли ошибка ReferenceError:

Вот, дрянь. Это не сработало.

Это происходит из-за того, что в узловых Node-модулях используется CommonJS, который несовместим с Rollup. Чтобы решить эту проблему, нам нужно добавить пару плагинов для обработки зависимостей Node и модулей CommonJS.

УСТАНОВКА ЭТИХ МОДУЛЕЙ

Чтобы обойти эту проблему, нам нужно добавить два плагина:

1. `rollup-plugin-node-resolve`, что позволяет загружать сторонние модули из `node_modules`.

2. `rollup-plugin-commonjs`, который обеспечивает поддержку подключения CommonJS-модулей.

Установите оба плагина с помощью следующей команды:

```

npm install --save-dev rollup-plugin-node-resolve rollup-plugin-commonjs

```

ОБНОВЛЕНИЕ `rollup.config.js`

Затем импортируйте его в конфигурацию Rollup:

**rollup.config.js**

```

// Rollup plugins

import babel from 'rollup-plugin-babel';

import eslint from 'rollup-plugin-eslint';

import resolve from 'rollup-plugin-node-resolve';

import commonjs from 'rollup-plugin-commonjs';

export default {

entry: 'src/scripts/main.js',

dest: 'build/js/main.min.js',

format: 'iife',

sourceMap: 'inline',

plugins: [

resolve({

jsnext: true,

main: true,

browser: true,

}),

commonjs(),

eslint({

exclude: [

'src/styles/**',

]

}),

babel({

exclude: 'node_modules/**',

}),

],

};

```

**Примечание**Свойство `jsnext` обеспечивает [простое мигрирование ES2015-модулей для Node-пакетов](https://github.com/rollup/rollup/wiki/jsnext:main). Свойства `main` и `browser` помогают плагину решать, какие файлы следует использовать для пакета.

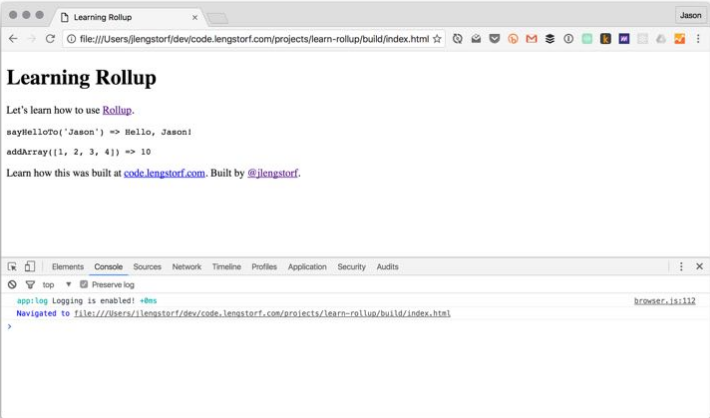

ПРОВЕРКА РЕЗУЛЬТАТОВ В КОНСОЛИ

Выполним ребилд командой `./node_modules/.bin/rollup -c`, затем снова проверьте браузер, чтобы увидеть результат:

#### ШАГ 5: ДОБАВЛЕНИЕ ПЛАГИНА, ОБЕСПЕЧИВАЮЩЕГО ЗАМЕНУ ПЕРЕМЕННОЙ ОКРУЖЕНИЯ

Переменные среды добавляют много дополнительных «фишек» при разработке и дают нам возможность делать такие вещи, как выключение/включение логирования, внедрение только dev-скриптов и многое другое.

Поэтому давайте убедимся, что Rollup позволит нам использовать их.

ДОБАВЛЕНИЕ УСЛОВИЙ ДЛЯ `ENV` В `main.js`

Давайте воспользуемся переменной окружения и включим логирования только в том случае, если мы не в продакшен режиме. В `src/scripts/main.js`, изменим способ инициализации нашего `log()`:

```

// Import a logger for easier debugging.

import debug from 'debug';

const log = debug('app:log');

// The logger should only be disabled if we’re not in production.

if (ENV !== 'production') {

// Enable the logger.

debug.enable('*');

log('Logging is enabled!');

} else {

debug.disable();

}

```

Однако после того, как мы ребилдим наш проект `(./node_modules/.bin/rollup -c)` и посмотрим браузер, мы увидим, что это дает нам `ReferenceError` для `ENV`.

Это не должно удивлять, потому что мы не определили его нигде. Но если мы попробуем что-то вроде `ENV = production ./node_modules/.bin/rollup -c`, он все равно не сработает. Это связано с тем, что установка переменной среды таким образом делает ее доступной только для Rollup, а не к пакету, созданному с помощью Rollup.

Нам нужно использовать плагин для передачи наших переменных окружения в пакет.

УСТАНОВКА ЭТИХ МОДУЛЕЙ

Начните с установки `rollup-plugin-replace`, которая по существу является просто утилитой find-and-replace. Он может делать много вещей, но для наших целей мы просто найдем появление переменной среды и заменим ее фактическим значением (например, все вхождения `ENV` будут заменены на «production» в сборке).

```

npm install --save-dev rollup-plugin-replace

```

### ОБНОВЛЕНИЕ `rollup.config.js`

Давайте в `rollup.config.js` импортируем его и добавим в наш список плагинов.

Конфигурация довольно проста: мы можем просто добавить список пар ключ-значение, где ключ — это строка для замены, а значение — то, чем она должна заменить.

**rollup.config.js**

```

// Rollup plugins

import babel from 'rollup-plugin-babel';

import eslint from 'rollup-plugin-eslint';

import resolve from 'rollup-plugin-node-resolve';

import commonjs from 'rollup-plugin-commonjs';

import replace from 'rollup-plugin-replace';

export default {

entry: 'src/scripts/main.js',

dest: 'build/js/main.min.js',

format: 'iife',

sourceMap: 'inline',

plugins: [

resolve({

jsnext: true,

main: true,

browser: true,

}),

commonjs(),

eslint({

exclude: [

'src/styles/**',

]

}),

babel({

exclude: 'node_modules/**',

}),

replace({

exclude: 'node_modules/**',

ENV: JSON.stringify(process.env.NODE_ENV || 'development'),

}),

],

};

```

В нашей конфигурации мы описываем ENV как process.env.NODE\_ENV — обычный способ установки переменных окружения в приложениях Node — либо «development». Мы используем JSON.stringify (), чтобы получить значение, заключенное в двойные кавычки.

Чтобы исключить проблемы со сторонним кодом, мы также устанавливаем свойство exclude для игнорирования нашего каталога node\_modules и всех пакетов, которые он содержит. (Благодарность [@wesleycoder по этому вопросу](https://github.com/jlengstorf/learn-rollup/issues/3)).

ПРОВЕРИМ РЕЗУЛЬТАТЫ

Сделаем ребилд сборки и проверим браузер. Лог в консоли не должен отличаться от того, что было ранее. Это хорошо — это значит, что мы использовали значение по умолчанию.

Чтобы убедиться, что настройка работает запустим ребилд в продакшен режиме:

```

NODE_ENV=production ./node_modules/.bin/rollup -c

```

**Примечание**В Windows используйте `SET NODE_ENV = production ./node_modules/.bin/rollup -c`, чтобы избежать ошибок при работе с переменными среды. Если у вас есть проблемы с этой командой, [см. эту проблему](https://github.com/jlengstorf/learn-rollup/issues/30) для получения дополнительной информации.

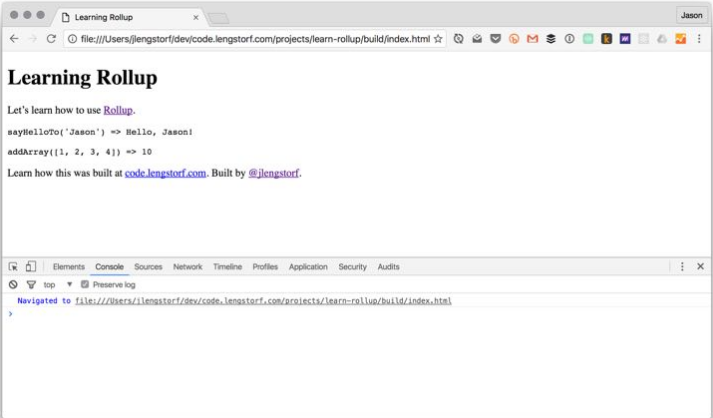

Убедимся, что после перезагрузки страницы в консоль ничего не пишется:

#### ШАГ 6: ДОБАВЛЕНИЕ UGLIFYJS, ДЛЯ СЖАТИЯ И МИНИФИЦИРОВАНИЯ СГЕНЕРИРОВАННОГО СКРИПТА

Последний шаг, который мы рассмотрим в этом руководстве, заключается в добавлении UglifyJS для минификации и сжатия нашего пакета. Это может значительно уменьшить его размер, удалив комментарии, сократив имена переменных, и другие виды «очистки» кода — что делает его более или менее нечитаемым для людей, но гораздо более эффективным для доставки по сети.

УСТАНОВКА ПЛАГИНА

Мы будем использовать [UglifyJS](https://github.com/mishoo/UglifyJS2/) для сжатия пакета, с помощью `[rollup-plugin-uglify](https://github.com/TrySound/rollup-plugin-uglify)`.

Установим его следующей командой:

```

npm install --save-dev rollup-plugin-uglify

```

ОБНОВЛЕНИЕ `rollup.config.js`

Теперь давайте добавим Uglify в нашу конфигурацию Rollup. Для удобства отладки в процессе разработки, давайте сделаем uglification только для продакшен режима:

**rollup.config.js**

```

// Rollup plugins

import babel from 'rollup-plugin-babel';

import eslint from 'rollup-plugin-eslint';

import resolve from 'rollup-plugin-node-resolve';

import commonjs from 'rollup-plugin-commonjs';

import replace from 'rollup-plugin-replace';

import uglify from 'rollup-plugin-uglify';

export default {

entry: 'src/scripts/main.js',

dest: 'build/js/main.min.js',

format: 'iife',

sourceMap: 'inline',

plugins: [

resolve({

jsnext: true,

main: true,

browser: true,

}),

commonjs(),

eslint({

exclude: [

'src/styles/**',

]

}),

babel({

exclude: 'node_modules/**',

}),

replace({

ENV: JSON.stringify(process.env.NODE_ENV || 'development'),

}),

(process.env.NODE_ENV === 'production' && uglify()),

],

};

```

В нашем случае мы загружаем `uglify ()`, когда `NODE_ENV` имеет значение «production».

ПРОВЕРКА МИНИФИЦИРОВАННОЙ СБОРКИ

Сохраните конфигурацию, и запустите Rollup в продакшен режиме:

```

NODE_ENV=production ./node_modules/.bin/rollup -c

```

Содержимое выходного файла имеет не очень красивый вид, но зато он намного меньше. Вот скриншот того, как сейчас выглядит `build/js/main.min.js`:

Раньше наш пакет составлял ~ 42 КБ. После прогона его через UglifyJS, его размер снизился до ~ 29 КБ — мы просто сохранили более 30% на размере файла без дополнительных усилий.

→ [Источник](https://code.lengstorf.com/learn-rollup-js/)

***Личное впечатление:***

Общее впечатление о rollup у меня сложилось достаточно положительное, может по общему набору возможностей не превосходит webpack(но это все зависит от цели использования), но, по моему мнению, более легок и прост в освоении. Не говоря уже, о заявленных самими разработчиками такими фичами, как скорость работы, более эффективная компоновка выходного кода(tree-shaking) и др. Но самый главный показатель для меня это то, что он справился со всеми потребностями моих проектах, о которых обязательно напишу в следующих статьях, где я его использовал достаточно гибко.

|

https://habr.com/ru/post/331412/

| null |

ru

| null |

# Ряды open source игр пополнились еще 4 классными экземплярами

Эпический по размахам марш, инициированный компанией Wolfire — [акция по продаже 6 популярных инди-игр «купи за сколько хочешь» — The Humble Indie Bundle](http://habrahabr.ru/blogs/indie_games/92912/) — World of Goo, Aquaria, Gish, Lugaru, Penumbra и Samorost 2 — закончился около 2 часов назад и возымел такую концовку, о которой многие мечтали уже несколько лет, но в такое всерьёз никто не верил.

За неделю работы удалось собрать больше миллиона долларов США — и 2 часа назад, в знак признательности поддержавшему их сообществу, группа разработчиков Wolfire, Bit Blot, Cryptic Sea и Frictional Games объявила о том, что отныне четыре игры из шести — **Aquaria, Gish, Lugaru и Penumbra** — будут выпущены в свет в исходниках под open source лицензией.

Исходники Lugaru HD [уже выложены](http://blog.wolfire.com/2010/05/Lugaru-goes-open-source), остальные 3 игры должны последовать примеру в течении нескольких дней. Lugaru выложен в виде [Mercurial-репозитария на Icculus.org](http://hg.icculus.org/icculus/lugaru) — код собирается с помощью обычных Makefile'ов (и gcc), как проект XCode и как проект Microsoft Visual Studio. Лицензия — GPL v2.

Уф — а теперь, скинув налет пафоса и эйфории, давайте задумаемся, во-первых, что это дает сообществу, а во-вторых, какие тут есть подводные камни, если есть. Итак, бесспорные (или слегка спорные) плюсы:

Сообщество получило (ладно, еще не получило, но получит) готовые, качественные, проверенные вниманием публики и даже немножко временем движки. Число модов (и всяких partial conversions) того же Lugaru даже без исходников — только за счет подмены карт, сценариев и моделей — исчисляется десятками и сотнями. [На wiki-страничке Wolfire про моды Lugaru](http://wiki.wolfire.com/index.php/Mods) можно ознакомиться с самыми интересными, полноценными и качественными из них — а что тут произойдет — можно представить полет фантазии.

Бессмертная фраза «Code rots. Game code rots even faster», которую приписывают чуть ли не десятку известных людей — от Джона Кармака из iD software до Скотта Миллера из 3D Realms — здесь права как никогда. Сообщество получило свежий, актуальный код движков, а не движок «позапрошлого поколения», как это происходит в случае выпуска кода такими компаниями как iD software (честь им и хвала, впрочем, даже за это):

* Lugaru — интересный трехмерный движок с качественной и очень быстрой ragdoll-физикой — по большому счету — это то, что явилось логичным современным продолжением таких игр как Mortal Kombat и Tekken, вбирая в себе элементы Max Payne.

* Aquaria — качественный, быстрый и фичастый движок двухмерной платформо-подобной игры, с массой современных наворотов вроде particle systems на OpenGL.

* Gish — движок двухмерной физики, в том числе физики аморфных тел — ведь главный герой игры — прыгучий и липкий шарик дёгтя, который может принимать любые формы.

* Penumbra — здесь в силу специфики жанра, конечно, на первом плане сюжет и хоррор-контент игры — но ведь если отвлечься от этого, Penumbra представляет из себя тоже трехмерный движок, с нетривиальным подходом к управлению персонажем, с весьма приличной физикой, с быстрым, качественным и нетрадиционным просчетом светотеней и т.п. Кто знает — может быть мы увидим реинкарнации Alone in the Dark на нем?

Что нам не хватало в этих играх? Multiplayer в Lugaru и Aquaria? Новые приемы, оружие, враги, пара тысяч новых карт? Можно засучить рукава и сделать. Все 4 выпускаемые игры достаточно хорошо поддаются моддингу — можно лишь догадываться, до чего дойдет фантазия, когда заинтересованные люди получат исходный код. Хочется перенести это на другие платформы? iPhone OS, BSD, Solaris, Symbian, Android, MeeGo — теперь всё это легко можно сделать. ~~И наконец-то все эти игры получат нормальные, полноценные 64-битные версии, без 32-битных библиотек и эмуляции.~~ Ну и, в конце концов — это GPL — ничто не мешает взять лишь движок за основу и создать что-то своё, совершенно новое.

Вот так, например, выглядит ragdoll-модель Lugaru изнутри:

Но кроме плюсов, есть ещё и скользкие вопросы, на которые не все обратили внимание. Судя по обещаниям в блоге, все игры будут разделены на «свободный» движок и «несвободный» (или «не совсем свободный») контент. В случае Lugaru контент от демо-версии (artwork, карты, модели, текстуры) выложены в общий репозитарий под расплывчатой лицензией «можно качать и использовать для персонального некоммерческого использования, продавать нельзя» — производные работы от такого контента скорее всего тоже запрещены. Полноценный контент от полной версии остается проприетарным и платным — т.е. таким образом те, кто купил эти игры — купили их не зря — только так в них можно играть легально. Остальные игры скорее всего последуют примеру Lugaru.

В принципе, это правильно — довольно глупо было бы равнять тех, кто купил и заплатил деньги с теми, кто ничем не помог проекту — это же в конце концов не abandonware. Но, с другой стороны, это ставит в некотором роде крест на красивой идее полной доступности этих игр бесплатно из репозитариев операционных систем и возможности поставить всё одной командой типа `apt-get install lugaru`. В лучшем случае будет более сложная процедура «поставьте движок отдельно, подложите вот сюда контент, запускайте».

P.S. Крайне интересны и финансовые результаты кампании: эта акция, без сомнения, стала крупнейшим и успешнейшим подобным мероприятием. Надеюсь, что чуть попозже я освещу на хабре и темы вроде «как заработать миллион $ за неделю» и «пользователи какой операционной системы самые щедрые».

P.P.S. Возможность купить продлена ещё на 3 суток — тем, кто не успел, но все ещё хочет.

|

https://habr.com/ru/post/93317/

| null |

ru

| null |

# О мобильной платформе 1С: Предприятия

Мобильная платформа 1С:Предприятия – это набор инструментов и технологий для быстрой разработки приложений под мобильные ОС iOS, Android, Windows Phone / 8.1 / 10, с использованием тех же сред разработки (Конфигуратор или 1С:Entrprise Development Tools) и тех же методик разработки, что используются для «обычных» приложений 1С. В результате получаются автономные, офлайновые приложения, но с возможностью обмена информацией с внешним миром при помощи широкого спектра средств интеграции, предоставляемого платформой: Web и HTTP-сервисы, е-мейл и т.д. Поскольку протоколы обмена – платформенно-независимые, мобильная платформа 1С, помимо прочего – это средство быстрого создания мобильного фронт-энда для практически любого серверного решения.

### Предыстория

Еще во времена «1С:Предприятия» версии 8.0 (и последующих версий) существовал программный продукт «Расширение для карманных компьютеров». Расширение позволяло создавать продукты только для ОС Windows Mobile, Windows CE и т.д. Продукт обладал собственным конфигуратором, и сервером, и поддерживался вплоть до выпуска «1С:Предприятия» версии 8.3. Последняя версия расширения (8.2.9) была выпущена в октябре 2013 года, а полная поддержка прекратилась 1 января 2015 года.

Расширение имело ограниченное применение даже во времена расцвета коммуникаторов на Windows Mobile, а уход таких устройств с мобильного рынка явно не добавил популярности этому программному продукту. Устройства на iOS и Android заняли практически весь рынок мобильных устройств, и стало очевидно, что поддержка этих ОС является одним из ключевых моментов для системы, которая должна эксплуатироваться в современном мобильном мире. Также казалось очевидным, что основной подход существующей платформы «1С:Предприятие» должен использоваться и на мобильных устройствах: прикладной разработчик должен в первую очередь думать о решении прикладных задач, а во вторую — о том, какие возможности используемой ОС ему задействовать для решения этих задач. Другими словами, нужен инструмент, который изолирует прикладного разработчика от особенностей конкретных мобильных ОС и инструмента разработки.

### Мобильная платформа

Опираясь на опыт разработки и эксплуатации расширения для карманных компьютеров, было принято решение разработать специализированную систему, которая бы удовлетворяла нескольким требованиям:

* она должна поддерживать современные популярные мобильные операционные системы и устройства под их управлением. В первую очередь это ОС iOS фирмы Apple и Android компании Google.

* эта система должна позволять использовать разработанные приложения в стиле, принятом на современных мобильных устройствах. В частности, интерфейс должен опираться на ручное управление (в буквальном смысле этого слова) с использованием сенсорных экранов.

* система должна обеспечивать единообразный программный интерфейс для реализации различных специфических механизмов, вне зависимости от используемой мобильной ОС.

* разработчик должен использовать тот же инструмент и те же подходы к разработке, что и при разработке приложений для «обычного» компьютера.

* прикладной разработчик должен разрабатывать прикладное решение в привычной среде разработки, по возможности используя единый код для настольной и мобильной систем.

* интерфейс прикладного решения, работающего на мобильном устройстве, должен быть аналогичен для различных платформ и в целом однозначно узнаваем.

Результатом разработки явилась так называемая [мобильная платформа](http://v8.1c.ru/overview/Term_000000818.htm), которая была выпущена 29 мая 2013 года в вариантах для iOS и Android. Мобильная платформа «1С:Предприятия» — это набор инструментов и технологий, позволяющий создавать приложения для мобильных ОС iOS, Android, Windows Phone / 8.1 / 10, используя ту же среду разработки (Конфигуратор) и те же методики разработки, что и для обычных приложений на платформе «1С:Предприятие». В результате получаются автономные, офлайновые приложения, но с возможностью обмена информацией с внешним миром при помощи широкого спектра средств интеграции, предоставляемого платформой: Web- и HTTP-сервисы, электронная почта и т.д.

Мобильная платформа была достаточно хорошо воспринята сообществом, начали появляться различные статьи на эту тему (например, [тут](http://infostart.ru/public/242857/), [тут](http://habrahabr.ru/post/212799/) и [тут](http://habrahabr.ru/post/153809/)). Для того, чтобы разработать полнофункциональное приложение, работающее одновременно на подавляющем большинстве мобильных устройств, теперь требовалось минимальное время и знания, принципиально не отличающиеся от знаний «обычного» прикладного разработчика на платформе «1С:Предприятие». Безусловно, такой низкий порог вхождения привлекает разработчиков, которым надо «малой кровью» обеспечить некоторой базовой функциональностью сотрудников, работающих на выезде, начальство, да и прочих мобильных сотрудников, которым требуется работа с корпоративной системой.

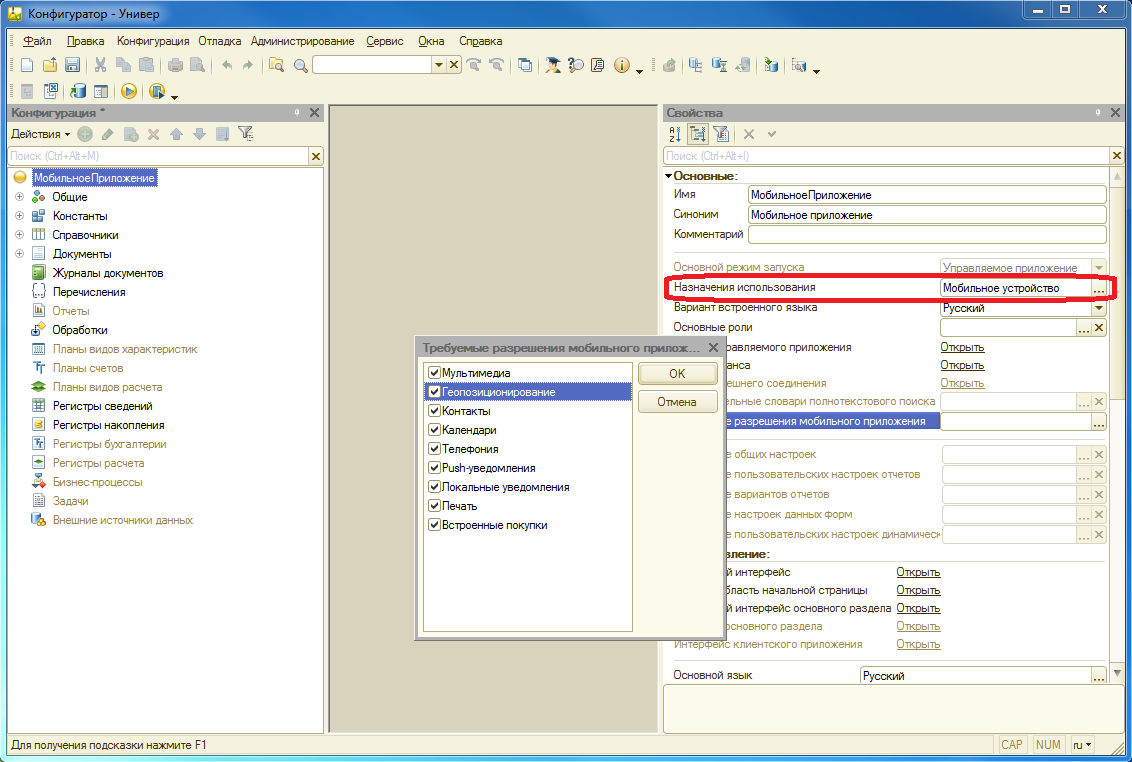

Начать разрабатывать мобильное приложение на платформе «1С:Предприятие» просто. В Конфигураторе нужно установить у конфигурации свойство «Назначение использования» в значение «Мобильное устройство». При этом часть прикладных объектов конфигурации станет недоступна (планы видов характеристик, планы счетов и т.д.), но станут доступны специфичные для мобильных приложений свойства (например, встроенные средства мультимедиа и геопозиционирования мобильного устройства и т.п.).

При этом отлаживать основные алгоритмы приложения (не связанные непосредственно с мобильной спецификой) можно непосредственно в Конфигураторе на компьютере разработчика. При этом участки кода, в которых происходит обращение к «мобильной» функциональности, рекомендуется обрамлять соответствующими инструкциями препроцессору, чтобы избежать ошибки при выполнении кода на персональном компьютере:

```

#Если МобильноеПриложениеКлиент Тогда

Данные = ГеопозиционированиеСервер.ПолучитьИмяПровайдера();

#КонецЕсли

```

Начиная с версии мобильной платформы 8.3.7 стала доступна и отладка приложения непосредственно на мобильном устройстве (подробнее об этом ниже).

Разработка на мобильной платформе может следовать различным подходам, но можно выделить несколько основных моментов. С точки зрения построения собственно мобильного приложения, его функциональной насыщенности и роли в ИТ инфраструктуре предприятия:

* мобильное приложение может быть составной и неотъемлемой частью существующей информационной системы предприятия. Мобильное приложение будет предоставлять интерфейс и другие возможности (включая обмен данными), «заточенные» под возможности существующей информационной системы. В этом случае мобильное приложение очень плотно связано с «обычной» информационной системой и не может эксплуатироваться в отрыве от нее.

* мобильное приложение выполняет специфические задачи, которые практически никак не связаны с информационной системой предприятия. Существует лишь минимальный набор данных, которыми обмениваются мобильное приложение и информационная система. В этом случае, скорее всего, мобильное приложение будет выполнять обмен по некоторому стандартизированному протоколу, что делает возможным применение этого мобильного приложения в совершенно различных случаях и ситуациях.

Две вышеописанные ситуации можно считать крайними вариантами. Но это не единственные варианты разработки. Прикладной разработчик может самостоятельно выбирать возможности интеграции между мобильным приложением и той информационной системой, которая выступает бэк-офисом для него.

Мобильное приложение разрабатывается как полностью автономная конфигурация, но может разделять часть исходного текста с «родительской» конфигурацией. Кстати, «родительская» конфигурация может физически не существовать (например, если вы разрабатываете некое универсальное приложение, которое может работать с разными системами по универсальному протоколу).

### Устройство мобильной платформы

Что же представляет собой мобильная платформа и что она умеет?

Справедливости ради, мобильная платформа — это всего один из компонентов всего комплекса, благодаря которому «1С:Предприятие 8» работает на мобильных устройствах. Итак, прикладной разработчик оперирует следующими компонентами:

1. Собственно мобильная платформа — мобильная часть фреймворка «1С:Предприятие». Она бывает обычной (которая используется во время сборки приложения для публикации в магазине приложений) и мобильной платформой разработчика, которая используется (сюрприз) во время разработки мобильного приложения.

2. Мобильная конфигурация — это конфигурация системы программ «1С:Предприятие», записанная в виде XML-файла.

3. Комбинация мобильной платформы и мобильной конфигурации дает мобильное приложение.

4. Сборщик мобильных приложений — специализированное прикладное решение, которое умеет сделать из мобильной платформы, конфигурации, заставок, иконок и прочих компонентов, готовый файл мобильного приложения, который можно загрузить в магазины Apple AppStore, Google Play, Windows Phone Apps / Windows Apps.

Почему все так сложно? Почему нельзя сделать на мобильном устройстве точно так, как это сделано в большой платформе? Т.е. ставить на устройство одну мобильную платформу и загружать в нее любое количество конфигураций/приложений? Это запрещают делать лицензионные ограничения на приложения, которые распространяются через магазины приложений. Например, если ваше приложение будет загружать исполняемый код (в виде скрипта) через Интернет, то оно никогда не появится в магазине приложений Apple. Следует, однако, понимать, что возможности по загрузке любой конфигурации, которые есть в мобильной платформе разработчика, не предназначены для дистрибуции мобильных приложений даже внутри одной компании, не говоря уже о дистрибуции клиентам разработчика.

После того, как мобильное приложение оказывается на целевом мобильном устройстве, возникает необходимость использовать какую-то базу данных (данные надо где-то хранить). В качестве движка базы данных мобильная платформа использует собственный движок базы данных, который портирован на мобильную платформу из платформы для персонального компьютера. Он компактен и достаточно быстр, но главное — он обеспечивает ровно такое же поведение, к которому привыкли прикладные разработчики, работая на платформе для персональных компьютеров.

Также стоит отметить, что внутри себя мобильное приложение построено по той же схеме, что и работа обычной платформы с файловым вариантом информационной базы: есть клиентская часть, есть серверная часть, есть база данных и есть клиент-серверное взаимодействие.

Собственно мобильная платформа написана как native-приложение, компилируется в двоичный код под основные процессорные архитектуры, используемые сейчас в мобильном мире: это архитектура ARM v5 и выше и x86.

Кроме того, для взаимодействия с теми или иными возможностями мобильного устройства (телефония, GPS, работа со встроенной камерой и т.п.) могут требоваться специальные разрешения. Для iOS они задаются непосредственно в процессе работы самого приложения, а для Android разрешения указываются при создании приложения. Требуемые разрешения указываются при разработке мобильного приложения и используются сборщиком мобильных приложений, но о сборщике — чуть позже.

#### Немного о платформе разработчика

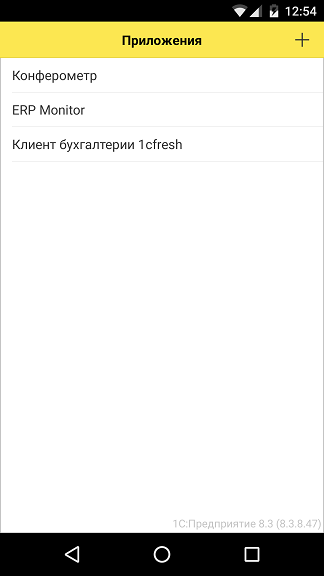

Пока мы ведем разработку мобильного приложения – мы не связаны лицензионными ограничениями, налагаемыми на мобильные приложения, распространяемые через магазины приложений. А значит, мы можем использовать мобильную платформу 1С так же, как используем «большую» платформу на персональном компьютере – установить саму мобильную платформу на смартфон/планшет и подгружать в нее конфигурации мобильных приложений. После запуска платформа покажет нам список зарегистрированных в ней приложений:

Чтобы добавить новое приложение в платформу, нужно разместить XML-файл с его описанием на ресурсе, доступном с мобильного устройства по протоколу HTTP. Удобнее всего сделать это из Конфигуратора, через меню «Конфигурация \ Мобильное приложение \ Публиковать». При этом XML-файл с конфигурацией приложения размещается на веб-сервере на компьютере разработчика (соответственно на этом компьютере должен быть веб-сервер – IIS или Apache).

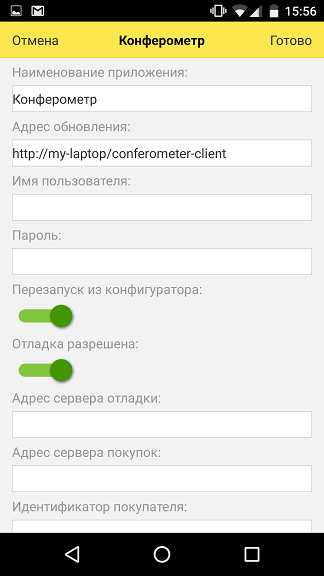

Если для приложения указать опцию «Перезапуск из конфигуратора», то приложение на мобильном устройстве будет автоматически обновляться с компьютера разработчика каждый раз, когда разработчик обновит размещенный на веб-сервере XML файл конфигурации.

При включенной опции «Отладка разрешена» возможна пошаговая отладка приложения на мобильном устройстве из Конфигуратора на компьютере разработчика (в Конфигураторе должна быть выбрана опция «Отладка по протоколу HTTP» в меню «Сервис \ Параметры»). Если в Конфигураторе поставить в коде точки останова и выбрать команду «Мобильное приложение – начать отладку», то мобильное приложение на устройстве остановится, когда исполняемый код дойдет до точки останова, и в Конфигураторе можно будет посмотреть значения переменных, стек вызовов и т.д.

### Что умеет?

Итак, что умеет мобильная платформа? Достаточно много :)

Если не оперировать специфическими терминами «1С:Предприятия», то мобильная платформа предоставляет возможность работать с нормативно-справочной информацией, оформлять документы, описывающие какие-то внешние действия, просматривать отчеты, связываться с внешним миром с помощью интернет-сервисов и многое другое. Т.е. она предоставляет прикладному разработчику возможность написать достаточно функциональное приложение, например, программу учета домашних финансов, программу для выездной торговли и тому подобное.

Но кроме обычной функциональности, которая есть на платформе для персонального компьютера, мобильная платформа должна обеспечивать работу со специфическими возможностями, которые присущи только мобильным устройствам:

* работа со звонками и журналом звонков;

* работа с короткими сообщениями (SMS) и их списком;

* контакты;

* календари;

* геопозиционирование (без прокладки маршрутов);

* позволяет делать фотоснимки, а также осуществлять видео- и аудиозапись;

* реагировать на изменение ориентации экрана;

* работать с уведомлениями (локальными и PUSH, как напрямую, так и через специальный сервис-посредник);

* сканировать штрих- и QR-коды с помощью камеры

* Монетизация мобильных приложений (т.е. способ дать разработчику мобильных приложений возможности для дополнительного заработка):

+ Работа с сервисами покупок Apple In-App Purchase (для ОС iOS) и Google Play In-App Billing (для ОС Android), с помощью которых можно организовывать в мобильном приложении различного рода подписки, покупки функциональности и т.д

+ Показ рекламы в мобильных приложениях (пока поддерживаются сервисы iAd для ОС iOS и AdMob для ОС Android).

* и т.д.

Понятно, что какие-то возможности могут быть недоступны на каждом конкретном устройстве, поэтому для определения того, что можно делать на том устройстве, на котором исполняется мобильное приложение, предусмотрены специальные методы, которые позволяют узнать, доступна на данном устройстве, например, возможность набора номера или нет. Таким образом, реализуется примерно такая схема использования: проверяем, можно использовать какую-то возможность или нельзя и если можно — используем:

```

Если СредстваТелефонии.ПоддерживаетсяНаборНомера() Тогда

СредстваТелефонии.НабратьНомер(НомерТелефона, ВызватьСразу);

КонецЕсли;

```

Спрятать от прикладного разработчика подробности об используемой мобильной ОС, предоставить ему унифицированные механизмы для использования мобильной функциональности – важная задача для нас. Мы считаем, что задача нами успешно решается. Различия в реализуемых механизмах или отсутствуют или сведены к минимуму. Кроме, конечно, случаев, когда функциональности в одной из ОС нет совсем.

Например, техника работа с PUSH-уведомлениями сильно отличается у Google и Apple. Мы приложили немало усилий, чтобы унифицировать механизм работы с PUSH-уведомлениями из прикладного кода. В случае мобильного приложения нам это удалось почти на 100%: один и тот же прикладной код на мобильном устройстве обрабатывает прием PUSH-уведомлений и на iOS, и на Android. И код рассылки PUSH-уведомлений в серверном приложении также выглядит одинаково. Но чтобы добиться такой унификации, нам пришлось разработать специальный сервер-прокси <https://pushnotifications.1c.com/>, который скрывает от разработчика разную технику работы с сервисами Apple Push Notification Service (APNS) и Google Cloud Messaging (GCM). Вся разница заключается в разных настройках непосредственно на сайте-прокси <https://pushnotifications.1c.com/>; для работы c APNS на сайт нужно загрузить SSL-сертификат (который Apple выдает для приложения по заявке разработчика), для работы с GCM – указать уникальный идентификатор приложения.

Очевидно, что сразу невозможно реализовать все возможности, которые вы хотите иметь в мобильном приложении. И всегда приходится искать компромисс между несколькими очень полезными вещами. И если вам чего-то не хватает — пишите нам о том, какие бизнес-задачи (ведь платформа — это в первую очередь инструмент по реализации бизнес-задач!) у вас не получается решить и какой механизм помог бы вам для этого.

### Как выглядит?

Графический интерфейс мобильной платформы – отдельная тема. В 1С:Предприятии, как известно, интерфейс описывается декларативно. Это, с одной стороны, накладывает некоторые ограничения на разработку UI (например, отсутствует возможность попиксельного позиционирования), но, с другой стороны, позволяет платформе единообразно отрисовывать интерфейс на экранах разного размера, в тонком и веб-клиенте. Этого же принципа мы старались придерживаться и в мобильной платформе. Насколько хорошо нам это удалось? Попробуем разобраться.

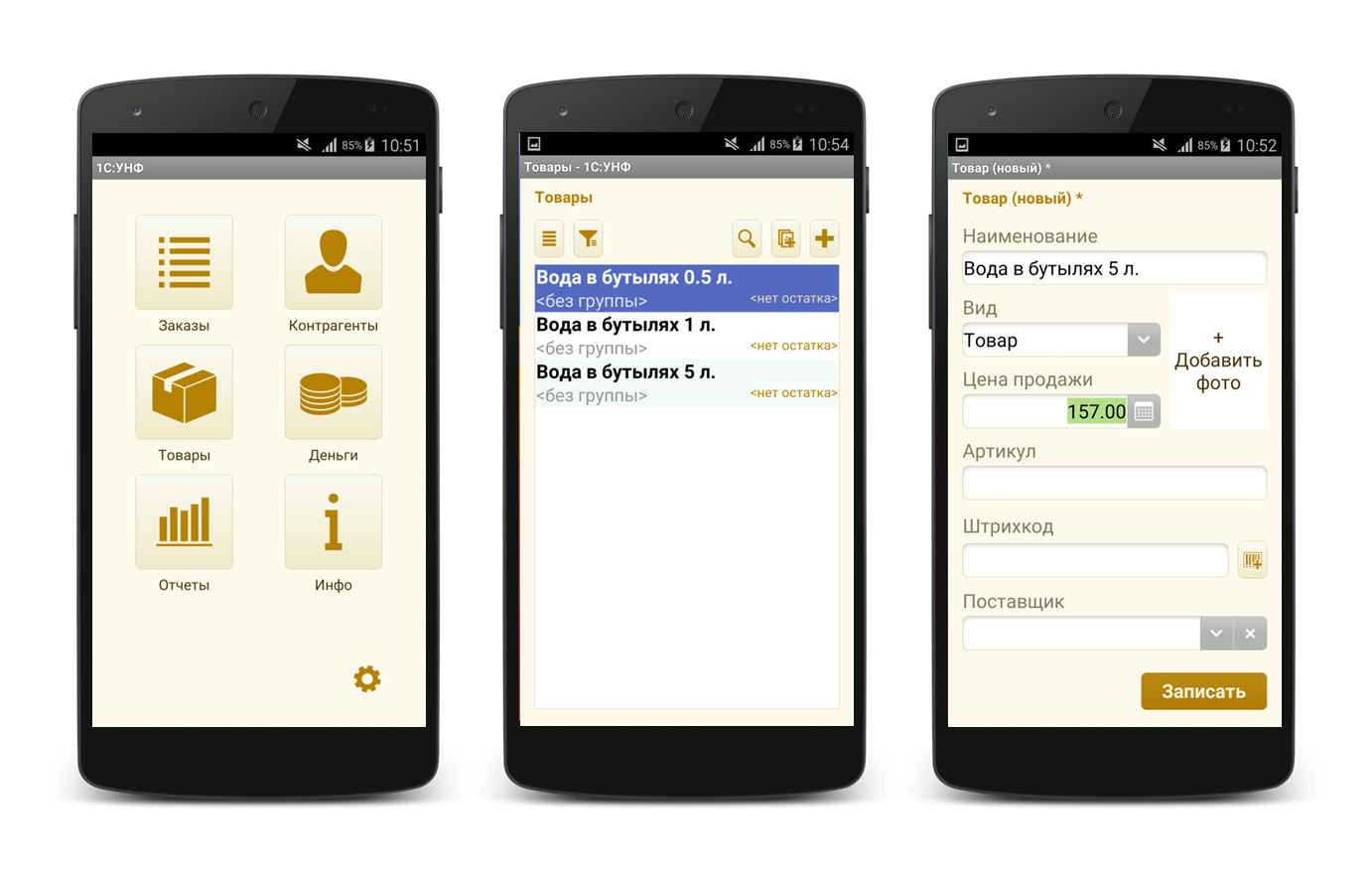

В первых версиях мобильной платформы (до 8.3.5 включительно) графический интерфейс приложений выглядел весьма привычно для искушенных пользователей 1С; фактически он переносил знакомый по «десктопным» версиям 1С интерфейс в мобильный мир. Но с точки зрения пользователей, ранее с 1С не знакомых, интерфейс выглядел несколько архаичным.

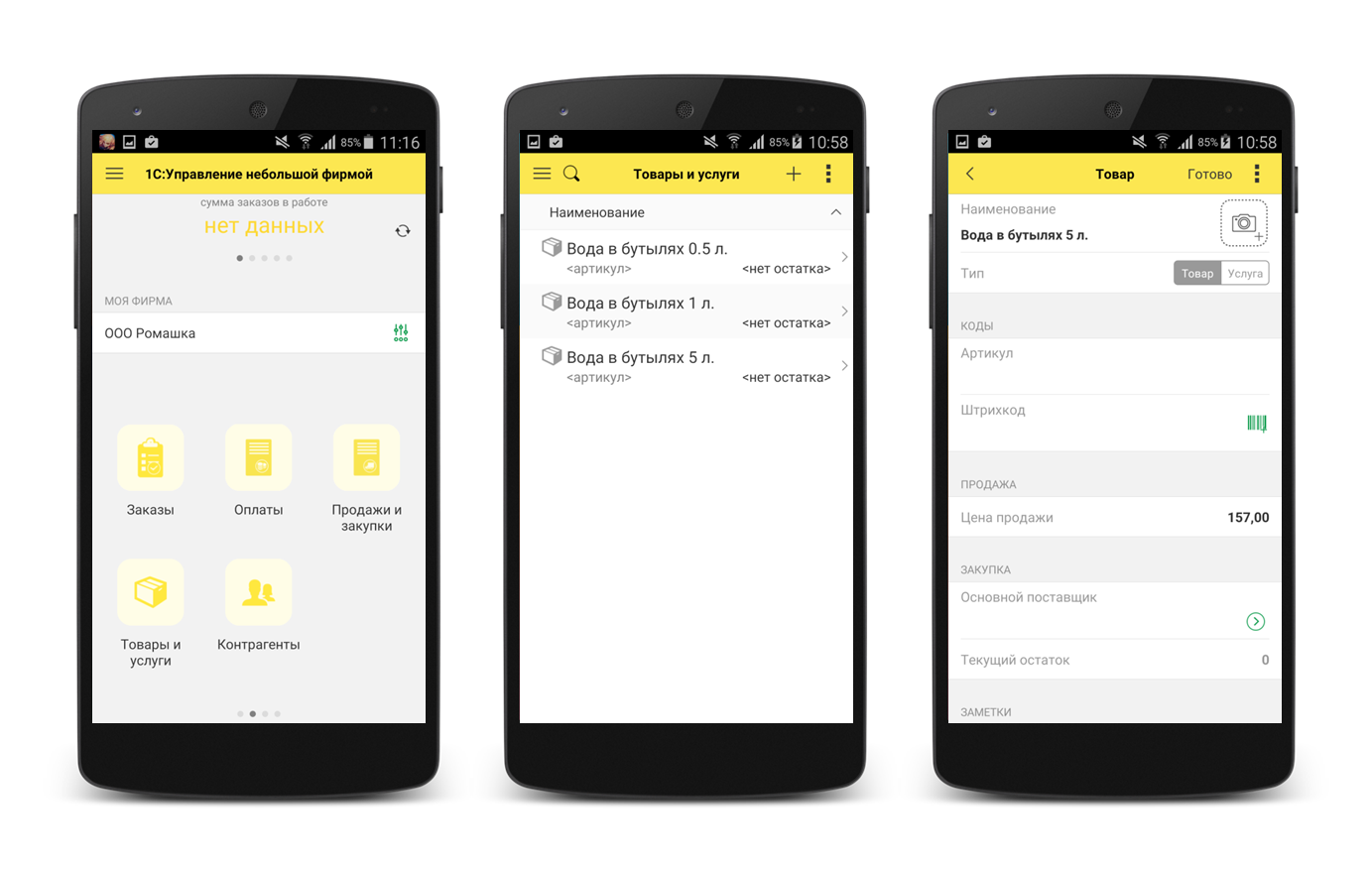

Учтя замечания и пожелания, мы коренным образом [пересмотрели](http://v8.1c.ru/o7/201412mob/index.htm) свой подход к мобильному интерфейсу в версии 8.3.6. Можно сказать, что мы сделали совершенно новый мобильный интерфейс для наших приложений. Он имеет много общего с нашим интерфейсом [«Такси»](http://v8.1c.ru/o7/201309taxi/index.htm). Модель разработки для разработчиков мобильных приложений соответствует модели разработки в «Такси». При этом мобильный интерфейс полностью соответствует принятым в мобильных приложениях подходам к дизайну и [UX](https://ru.wikipedia.org/wiki/%D0%9E%D0%BF%D1%8B%D1%82_%D0%B2%D0%B7%D0%B0%D0%B8%D0%BC%D0%BE%D0%B4%D0%B5%D0%B9%D1%81%D1%82%D0%B2%D0%B8%D1%8F). Интерфейс полностью учитывает специфику мобильного мира: небольшой размер экрана (а значит, оформление графических элементов должно стать более аскетичным – без теней, градиентов), есть поддержка пальцевых жестов и т.д. Интересный факт: [новый механизм платформы](http://v8.1c.ru/o7/201505layout/index.htm), отвечающий за размещение элементов в форме (layouter) оказался настолько удачным и своевременным для мобильной платформы, что был выпущен в ней раньше (в версии 8.3.6) чем в платформе для ПК (в версии 8.3.7), для которой он в первую очередь предназначался.

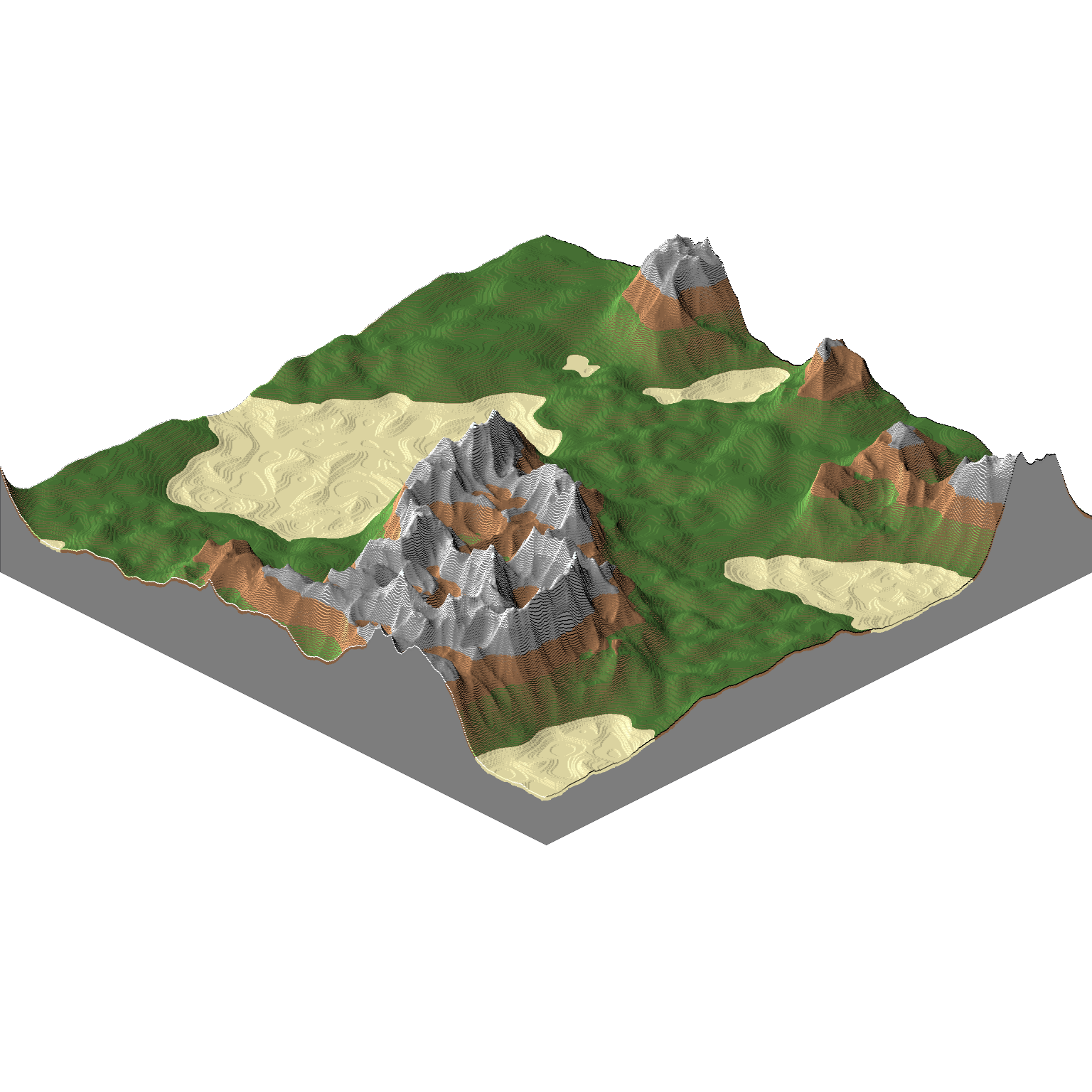

На картинке можно увидеть, как поменялся наш интерфейс.

Приложение «Управление небольшой фирмой» на версии мобильной платформы 8.3.5:

Оно же на версии 8.3.6:

А вот так выглядит интерфейс мобильной платформы вживую:

### Сборщик — и что это за зверь?

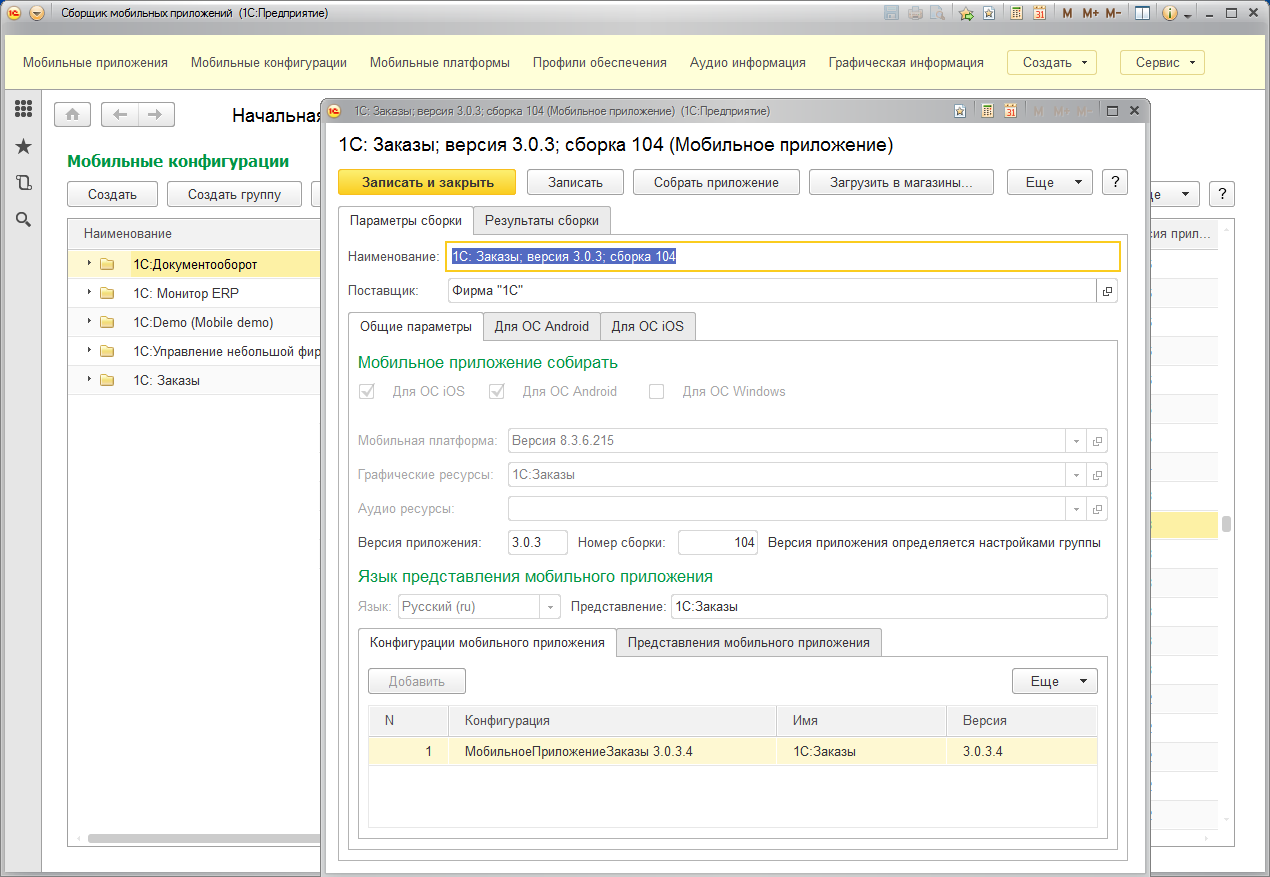

Как уже было сказано ранее, мобильное приложение состоит из нескольких компонентов (собственно мобильная платформа, конфигурация, различные ресурсы), которые должны представлять собой единое целое для помещения приложения в магазин. Чтобы облегчить превращение компонентов в приложение, был разработан сборщик мобильных приложений. Это конфигурация (приложение), созданная на платформе «1С:Предприятие», которая хранит в своей базе данных все компоненты, необходимые для формирования мобильного приложения. Для того чтобы сборщик выполнял свою работу, нужно скачать и установить различные программные пакеты, которые нужны для его работы (Java и Android SDK и т.п.), затем указать пути к этим пакетам в настройках сборщика и задать некоторые дополнительные параметры (ключи разработчиков и т.д.).

После настройки сборщик готов к работе. В общем случае работа со сборщиком выглядит следующим образом:

1. Загружаем версию мобильной платформы 1С, на которой будем собирать приложение

2. Загружаем конфигурацию, из которой будем собирать мобильное приложение

3. Создаем мобильное приложение, в котором указываем, для каких платформ (Android, iOS, Windows) надо выполнять сборку, какую конфигурацию и платформу следует использовать (в частности, указать, какой сертификат для сборки под iOS использовать в случае, если приложение работает с PUSH-уведомлениями).

4. Выполняем «одним кликом» сборку мобильного приложения под все выбранные платформы

5. «Другим кликом» отправляем собранные мобильные приложения в магазины приложений (если это приложение для iOS или Android). В магазины Windows Apps / Windows Phone Apps приложение нужно загружать вручную, т.к. Microsoft пока не предоставляет API для размещения приложения в магазине.

Следует отдельно отметить, что сборщик не нужен для разработки и отладки мобильного приложения. Для этого можно использовать мобильную платформу разработчика и средства Конфигуратора для передачи конфигурации на мобильное устройство. А вот для распространения мобильного приложения — нужен сборщик.

### Приложения на мобильной платформе

Сама фирма «1С» выпускает на мобильной платформе ряд приложений, являющихся мобильными клиентами серверных приложений 1С (1С:Документооборот, 1С:Управление Небольшой Фирмой и т.д.). Эти приложения реализуют некоторое подмножество функциональности «обычных» клиентов. В случае мобильной версии «1С:Управление Небольшой Фирмой» функциональности достаточно для полноценного использования программы, и мы часто видели ситуацию, когда клиентам для ведения бизнеса достаточно мобильной версии приложения.

Наши партнеры используют мобильную платформу как для разработки тиражных мобильных приложений, распространяемых через магазины приложений, так и для заказных приложений, созданных по запросам конкретных клиентов. Среди тиражных приложений встречаются приложения, которые используют не 1С-ный back-end в качестве центрального хранилища данных.

Среди мобильных приложений, созданных по заказу клиентов, можно упомянуть мобильный клиент для «1С:Управления Производственным Предприятием», созданный по заказу крупного машиностроительного холдинга. Около ста сотрудников холдинга используют мобильное приложение в горячих цехах, где по соображениям техники безопасности поставить стационарные компьютеры невозможно. Встроенная камера мобильного устройства используется для чтения штрих-кодов изделий и поиска их в справочнике номенклатур, мобильное приложение позволяет понять, на каком этапе технологической цепочки находится данное изделие, отметить прохождение изделием очередной операции и т.п.

### Заключение

Мы постарались очень поверхностно описать мобильную платформу, то, что она позволяет делать и почему она получилась такой, какой получилась. В данной статье практически ничего не сказано про мобильную Windows. На то есть несколько причин: во-первых, версия мобильной платформы под Windows вышла сравнительно недавно («1С:Предприятие» версии 8.3.7), во-вторых эта версия мобильной платформы не обладает какими-то существенными отличиями от реализации для других мобильных ОС. Естественно, что функциональность для ОС Windows мы будем наращивать. Равно как и наращивать функциональность мобильной платформы в целом. Так, в ближайших планах у нас – поддержка в мобильной платформе внешних компонентов; этот механизм (давно [доступный](http://v8.1c.ru/overview/Term_000000139.htm) в «большой» платформе), позволит разработчикам реализовать функциональность, недоступную в силу каких-либо причин в мобильной платформе.

Традиционно сильными сторонами технологической платформы «1С:Предприятие» являются легкость в освоении для разработчика и быстрота создания и модификации бизнес-приложений. Мобильная платформа 1С перенесла оба этих козыря в мобильный мир. Мобильная платформа 1С – это возможность быстро разработать приложение, работающее на трех самых массовых мобильных платформах (iOS, Android, Windows Phone / 8.1 / 10). А благодаря широкому спектру доступных платформенно-независимых средств интеграции (Web- и HTTP-сервисы и т.д.) мобильная платформа 1С — это возможность быстро создать мобильный клиент под три мобильные платформы для практически любого серверного приложения, поддерживающего любой из способов интеграции, доступных в платформе 1С (Web- и HTTP-сервисы, файловый обмен и т.д).

|

https://habr.com/ru/post/283198/

| null |

ru

| null |

# Проброс портов или как попасть в сеть за NAT используя Node.JS

Привет! Хочу поделиться очередным способом проброса портов, теперь и на Node.JS!

Для чего это нужно? Представим, есть удалённый компьютер, к которому нужно подключиться, например, по ssh, rdp, http(s), proxy, vnc, и т.д. Но, увы, у него нет общедоступного IP по той или иной причине.

*В этом примере предполагается, что у вашего устройства есть внешний IP.*

Что в таком случае можно сделать? Подключиться с помощьюу удалённого ПК к вашему (который слушает, например, порт 3000), *пробросив определённый порт*, например, 22. В результате, зайдя по ssh на localhost:3000, мы установим соединение с удалённым ПК.

**Что же для этого нужно?** На вашем и удалённом ПК:

Клонируем [github.com/mgrybyk/node-tunnel](https://github.com/mgrybyk/node-tunnel) и устанавливаем npm модули:

```

cd node-tunnel

```

```

npm install

```

**Запускаем**

На вашем ПК запускаем:

```

node server

```

в другом терминале:

```

node client

```

На удалённом ПК создаём файл .env, где мы указываем, какой порт нужно пробросить:

`N_T_AGENT_DATA_HOST=localhost

N_T_AGENT_DATA_PORT=22`

```

node agent

```

На этом настройка закончена, можем подключиться:

```

ssh -p 8000 localhost

```

Сессия ssh к удалённой машине установлена!

*Для начала (и чтобы поиграться) server, client и agent можно запустить на одном устройстве, тогда, подключившись к localhost:8000 по ssh, вы зайдёте к себе же. Вместо localhost можно указать другой хост; вместо ssh можно использовать другой TCP порт, например, http(s)*

Но что же делать, если у **вас нет внешнего IP**? Нужно найти промежуточную точку, где он имеется, например, бесплатный контейнер на [AWS](https://aws.amazon.com/free/).

Суть примерно та же, для примера возьмём теперь порт rdp и дадим имена агенту и клиенту.

Имена отдельного агента и клиентов должны совпадать.

На удалённом ПК редактируем .env файл, в этот раз указываем ещё и хост Windows PC внутри вашей сети:

`N_T_SERVER_HOST=хост ПК с внешним IP

N_T_AGENT_DATA_HOST=Windows PC внутри удалённой сети

N_T_AGENT_DATA_PORT=3389

N_T_AGENT_NAME=test-rdp`

И запускаем:

```

node agent

```

На ПК с внешним IP просто запускаем `node server` предварительно склонив репозиторий и установив модули npm.

На вашем ПК создадим .env файл, указав порт, который клиент будет слушать:

`N_T_SERVER_HOST=хост ПК с внешним IP

N_T_CLIENT_NAME=test-rdp

N_T_CLIENT_PORT=3388`

Запустим `node client`. Здорово! Теперь мы можем подключиться по RDP на localhost:3388, открыв rdp сессию к ПК внутри сети агента.

**Больше клиентов?**

Можно рассказать, как настроить (создать .env) клиент, другу. Запустив у себя клиент, он также сможет заходить по rdp туда же.

**.env**

Для удобства можно создавать много файлов типа .env.ssh, .env.rdp, .env.proxy и т.д., после чего запускать agent/client/server, передав имя файла как аргумент, например:

```

node client .env.rdp

```

**Шифрование**ВНИМАНИЕ! Шифрование трафика ещё не готово, пока не разобрался, как это лучше сделать.

При шифровании данных их длина растёт, из-за чего сообщение часто делится на два. После чего, на другой стороне их нужно склеить перед тем, как пускать дальше. Выглядит слишком криво :(

Ух, начну самое сложное, попытаюсь в двух словах объяснить, **как это работает**.

Использовал стандартный модуль [Net](https://nodejs.org/api/net.html), который работает по *TCP*.

Клиенты и агенты подключаются к серверу, который перенаправляет трафик с агента — клиенту и обратно. Это и есть основная магия.

У клиента, сервера и агента есть важные две части.

Первая — сокет для установки соединения; чтобы дать понять, кто есть кто, назовём его — сервисный сокет.

Вторая — сокет для передачи данных. Именно тут и происходит создание pipe'ов:

```

agentSocket.pipe(clientSocket)

clientSocket.pipe(agentSocket)

```

**Пример с ssh**

1. Подключаюсь к клиенту

2. Клиент перенаправляет трафик на сервер

3. Сервер перенаправляет трафик на агента

4. Агент создаёт соединение на указанный host:port и перенаправляет туда трафик.

Ну, и обратно: ответ SSH сервера агенту, далее — сервер, клиент, ssh клиент.

*… немного по каждому отдельно*

**Server**

* Сервер ждёт на клиентов и агентов