text

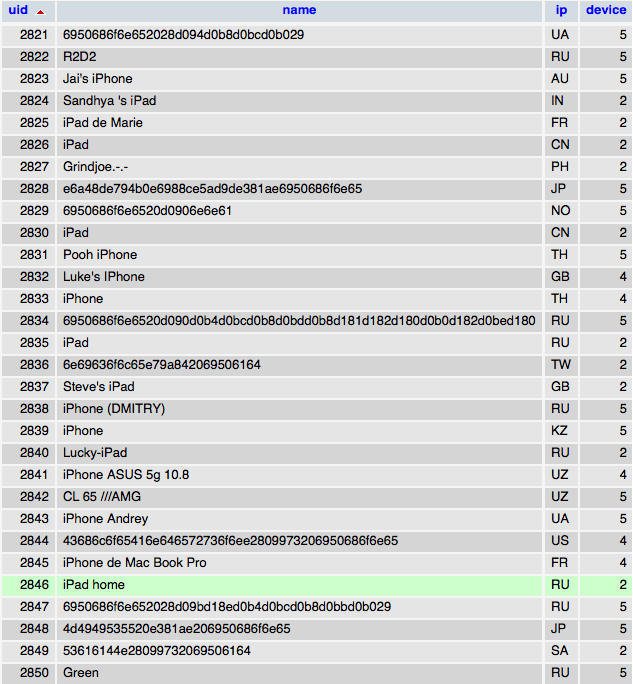

stringlengths 20

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

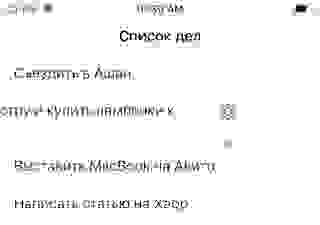

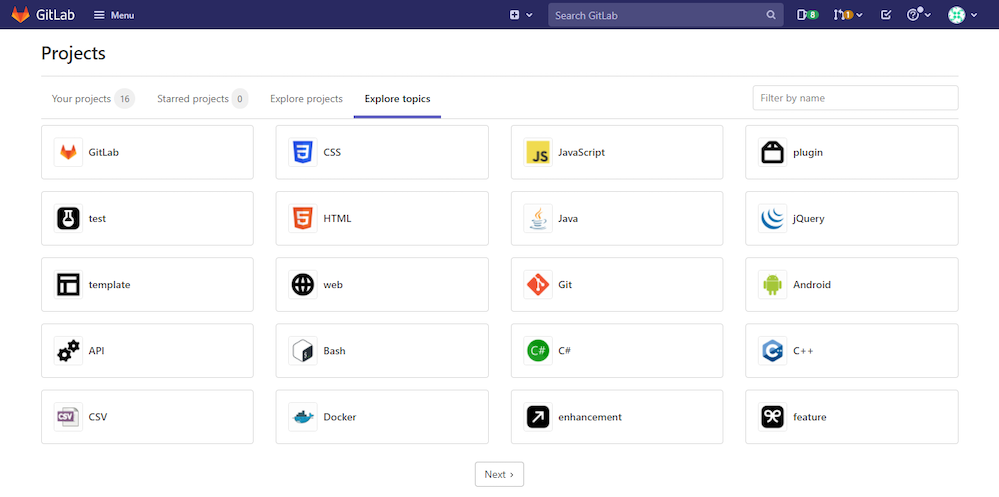

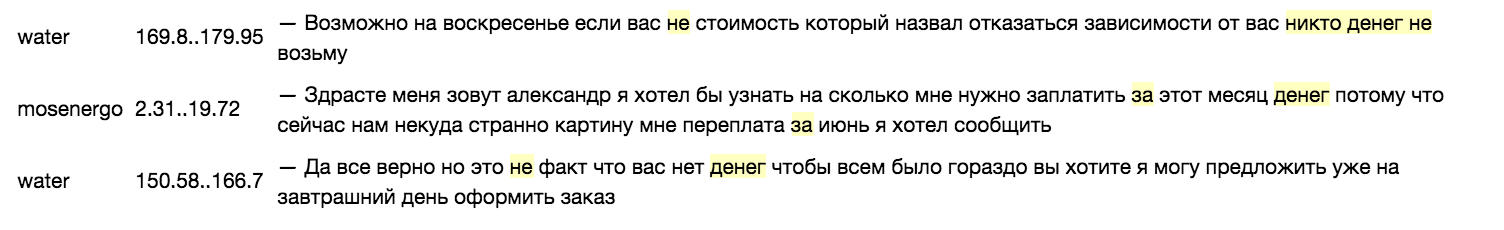

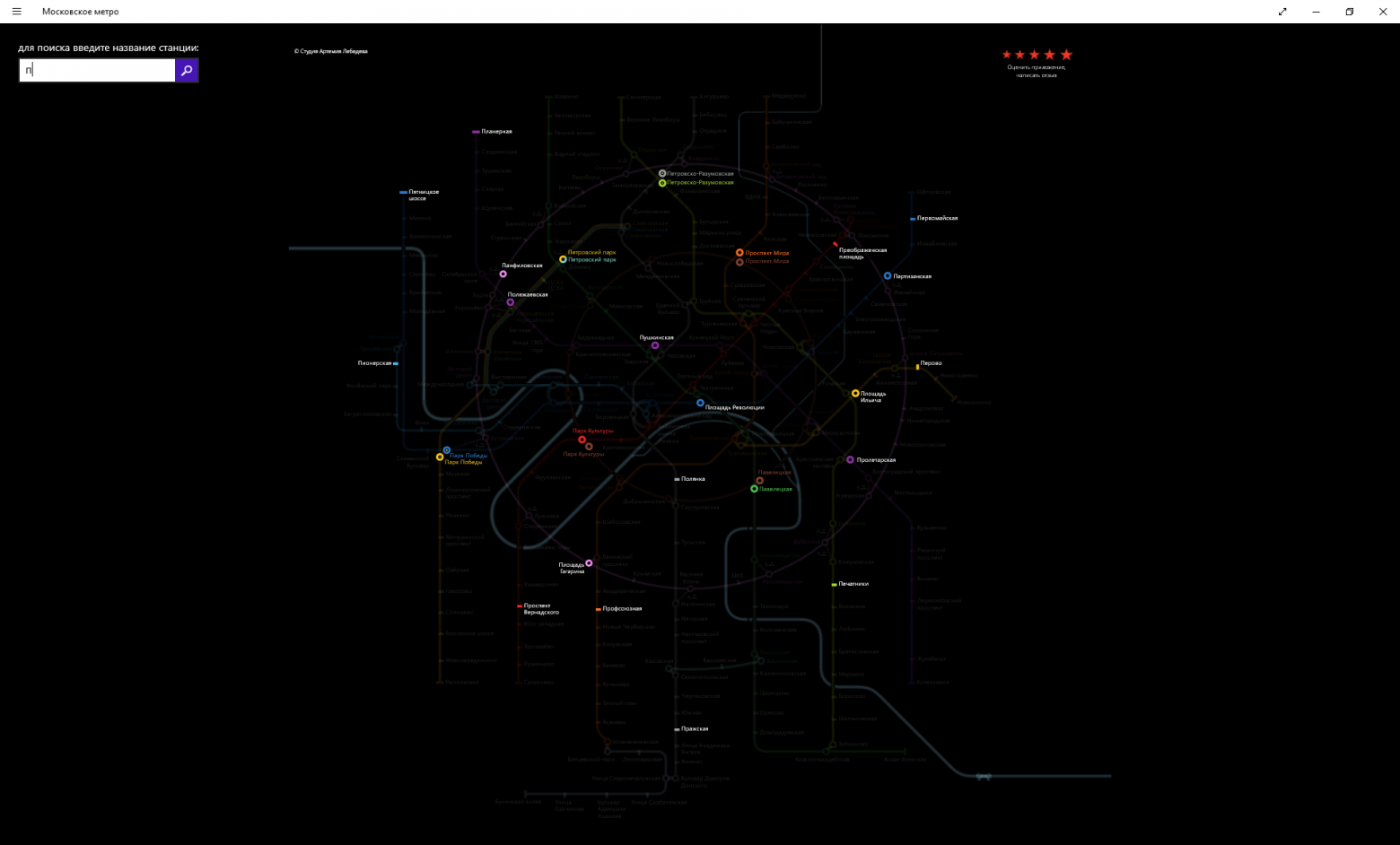

# Автоматизация поиска клонов сайтов и сайтов-однодневок

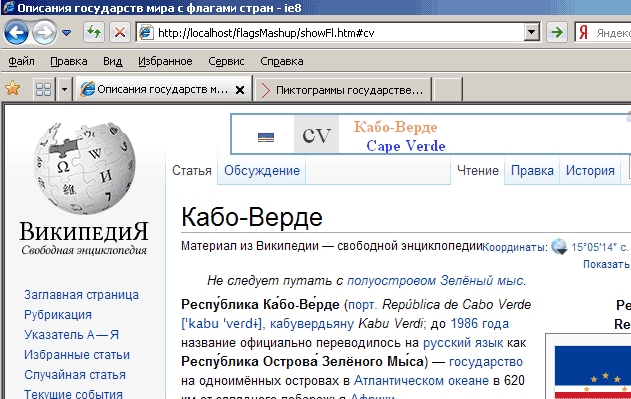

Злоумышленники, для заражения компьютеров пользователей, очень часто применяют методы, направленные на обман пользователей, набирающих в строке браузера адрес интересующего их сайта. Например, typosquatting (он же URL hijacking), то есть использование ошибок пользователей, которые могут ошибиться в написании домена на клавиатуре. Например, если в написании домена cisco.ru ошибиться и вместо первой буквы «c» набрать стоящую на клавиатуре рядом букву «v», то мы попадем не на сайт Cisco, а на домен, который в данный момент находится в продаже.

А если, например, ввести вместо «sberbank.ru» домен «sbrrbank.ru» (спутав стоящие рядом «e» и «r»), то мы попадем на вот такой ресурс.

Наконец, незнание русского языка и использование «Сбирбанка» вместо «Сбербанка» приводит нас на онлайн-казино:

Все это достаточно безобидные, но все-таки неприятные случаи, которые могут закончиться не более чем недовольством пользователя или ударом по репутации организации, чей бренд используется для обогащения других, менее известных компаний (например, за счет показа рекламы). Но что делать, если злоумышленник использует ошибки пользователей для явного нанесения им вреда путем заражения их компьютеров вредоносным кодом, размещенным на сайте со схожим названием? Например, известен пример длительного существования сайта goggle.com, распространяющего вредоносный код и фальшивый антивирус SpySheriff, или домена yuube.com, переправляющего пользователей на вредоносный сайт. Помимо ошибок самих пользователей при наборе с клавиатуре, злоумышленники могут рассчитывать и на невнимательность пользователей, которые сходу не увидят разницу между vkontakte.ru и vkolakte.ru (реальный пример) в почтовых рассылках или ссылках на различных Интернет-ресурсах. Но как с ними бороться?

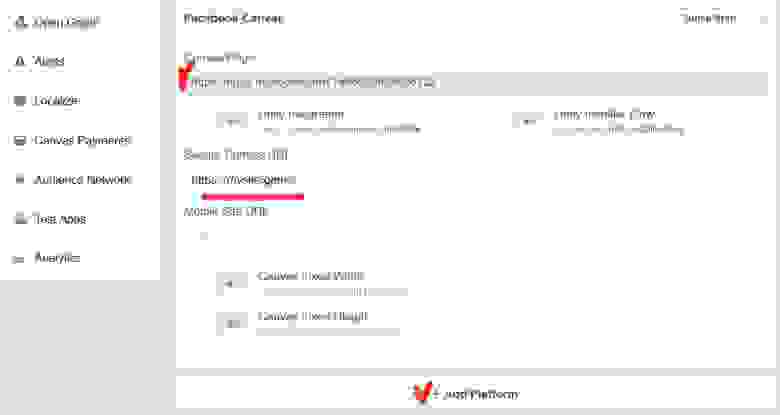

Борьба с такими доменами с одной стороны проста. Достаточно всего лишь отслеживать через регистраторов доменов или сервис whois появление новых доменов в сети Интернет. Но в этом и сложность — число таких новых доменов может быть огромным и появляться они могут ежедневно (на самом деле ежеминутно). В ручном режиме отслеживать такие изменения достаточно сложно. Например, вот как выглядит обычный поиск доменов, содержащих ссылку на популярную и пока еще не запрещенную в России соцсеть Facebook:

Таких доменов несколько сотен. А посмотрите, например, на домены, которые используют «microsoft» в своем названии. Их не только много, но и создаются они постоянно (скриншот сделан как раз 10 марта).

При этом стоит обратить внимание, что поиск усложняется тем фактором, что злоумышленники могут создавать домены, использующие различные сочетания символов, которые обычно не используются компаниями, чьи домены выбраны в качестве жертвы. Например, букву «o» злоумышленники могут заменить на цифру «0», букву «A» на цифру «4», заглавную «i» на строчную «L», «s» на «5», «z», «es» или «2» и т.д. Для того же Facebook это выглядит следующим образом:

Наконец, злоумышленник может использовать повторение символов. Тот же «facebook» можно заменить на «faceboook» и это может остаться незамеченным:

Если отвлечься от буржуинских примеров и посмотреть на Рунет, то взяв в качестве примера самый популярный в России банк, мы получим следующую картину:

Большое количество доменов (местами явно вызывающих вопросы) использует в качестве своей основы слово «sberbank». Что интересно, множественные исследования показывают, что пользователи почему-то склонны доверять таким доменам, считая, что домен, в котором упоминается имя компании (или популярного продукта/услуги), принадлежит именно этой компании, а не кому-то еще. И поэтому вероятность перехода по таким ссылкам гораздо выше, чем по ссылкам, не использующим названия компаний-жертв.

Понятно, что Сбербанк — не единственная компания, которая страдает от описанных атак. Например, в Рунете можно встретить домены, связанные с компанией Cisco:

или с сайтом Президента Российской Федерации:

При этом я осознанно в данной статье выбирал явно вредоносные домены, которые обнаруживаются с помощью сервиса Cisco OpenDNS Investigate, предназначенного как раз для проведения расследований таких атак. Пропуская через себя 80 миллиардов DNS-запросов ежедневно, сервисы Cisco OpenDNS (Investigate для расследования и Umbrella — для блокирования) анализируют огромное количество доменов и их активности, классифицируя и помещая в наши базы, к которым затем можно обращаться с помощью различных инструментов. Например, приведенные выше скриншоты сделаны с помощью Cisco OpenDNS Investigate, в интерфейсе которого через обычный браузер можно проводить расследования по интересующему домену (а также IP-адресу, автономной системе или e-mail владельца домена).

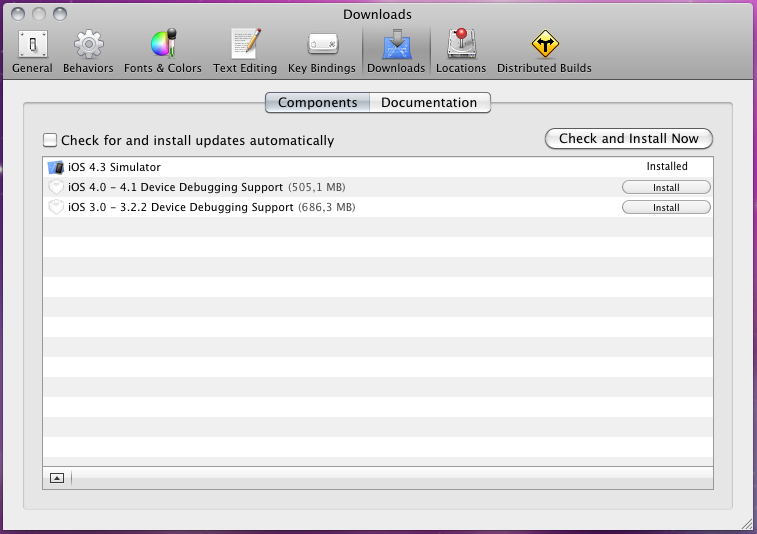

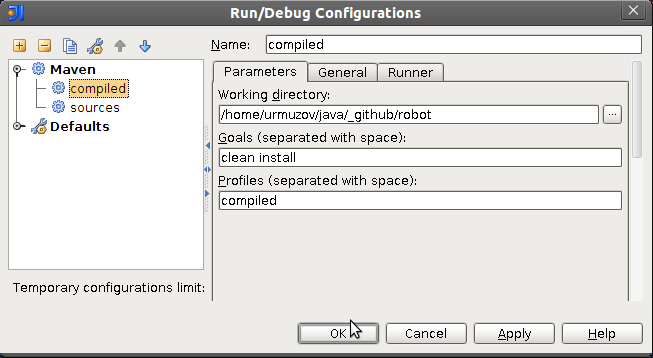

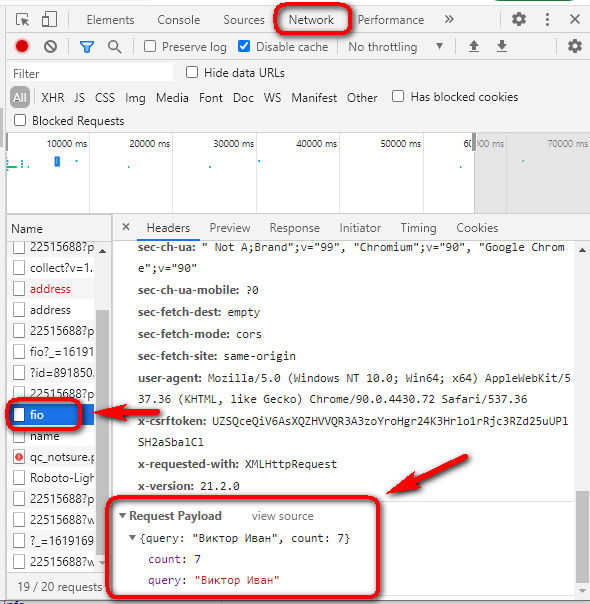

Для автоматизации же данной задачи и возможности проверки интересующих доменов на лету (например, через межсетевые экраны, системы контроля доступа в Интернет, SIEMы, SOCи и т.п.) можно использовать разработанный нам Investigate API. Например, нижеприведенный код позволяет найти искомую строку в доменах, созданных за последние сутки:

```

inv = investigate.Investigate('12345678-1234-1234-1234-1234567890ab')

inv.search('searchregex', start=datetime.timedelta(days=1), limit=100, include_category=False)

```

Искомая строка может быть создана заранее и включать в себя все возможные комбинации символом, которые могут встречаться в интересующих нас доменах. В том случае, если брендов, которые мы хотим мониторить несколько, то тут лучше воспользоваться отдельным скриптом, который на выходе выдает набор возможных замен для того или иного символа:

```

self.word = word

self.a=['a','4']

self.b=['b','8','6']

self.c=['c','k']

self.d=['d','0']

self.e=['e','3']

self.f=['f']

self.g=['g','6','9']

self.h=['h']

self.i=['i','!','1','|','l']

self.j=['j']

self.k=['k','x']

self.l=['l','1','7']

self.m=['m','nn']

self.n=['n']

self.o=['o','0']

self.p=['p','9','q']

self.q=['q','9']

self.r=['r']

self.s=['s','5','z','es','2']

self.t=['t','7','1']

self.u=['u','m']

self.v=['v']

self.w=['w','vv']

self.x=['x','ex']

self.y=['y','j']

self.z=['z','2']

self.zero=['0','o']

self.one=['1','l']

self.two=['two','2','z']

self.three=['e','3','three']

self.four=['4','four','for','fore','a']

self.five=['5','five','s']

self.six=['6','six','g']

self.seven=['7','seven','t','l']

self.eight=['8','eight','b']

self.nine=['9','nine','g']

self.alphabet={ 'a':self.a, 'b':self.b, 'c':self.c,

'd':self.d, 'e':self.e, 'f':self.f, 'g':self.g,

'h':self.h, 'i':self.i, 'j':self.j, 'k':self.k,

'l':self.l, 'm':self.m, 'n':self.n, 'o':self.o,

'p':self.p, 'q':self.q, 'r':self.r, 's':self.s,

't':self.t, 'u':self.u, 'v':self.v, 'w':self.w,

'x':self.x, 'y':self.y, 'z':self.z, '0':self.zero,

'1':self.one,'2':self.two,'3':self.three,'4':self.four,

'5':self.five,'6':self.six,'7':self.seven,'8':self.eight,

'9':self.nine }

def get_permutations(self, letter):

try:

permutations = self.alphabet[letter]

except KeyError:

permutations = letter

regex = '['

for p in permutations[:-1]:

regex += '{0}|'.format(p)

regex += '{0}]'.format(permutations[-1])

return regex

```

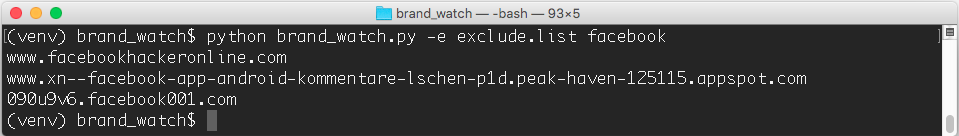

Дальше нам остается только на регулярной основе (например, раз в сутки) мониторить Интернет в поисках новых появившихся доменов, использующих интересные нам имена брендов (компаний, продуктов, услуг и т.д.). Мы автоматизировали данную задачу в виде скрипта barnd\_watch на Python, который может быть найден на [GitHub](https://github.com/brad-anton/brand_watch). Работать с ним легко — достаточно просто указать интересующую нас поискую строку:

Если же мы хотим исключить какие-то домены из поиска (если предполагается, что их будет много в поисковой выдаче), то для этого достаточно дать на вход скрипта заранее подготовленный файл с доменами-исключениями:

Вот таким вот нехитрым образом Cisco OpenDNS помогает автоматизировать процесс поиска сайтов-клонов и иных доменов, используемых злоумышленниками для атак на компании и их пользователей. Преимущество сервисов Cisco OpenDNS Investigate или Cisco OpenDNS Umbrella в том, что они не только автоматизируют поиск, но и, используя алгоритмы классификации, позволяет сразу сделать вывод о вредоносности того или иного домена. Вот как, например, это выглядит для домена, который использует бренд Газпромбанка:

Дальше уже можно проводить соответствующие расследования с помощью того же сервиса Cisco OpenDNS Investigate, который подскажет нам кто и когда создал данный домен, где он размещен, какие еще домены размещены на том же IP-адресе или в автономной системе, а также иную сопутствующую информацию (распространяемый вредоносный код, другие домены, принадлежающие этому владельцу и т.д.). Но об этих возможностях Cisco OpenDNS Investigate в другой раз.

В заключение хотел бы отметить, что такого рода атаки, используются не только для направления пользователей на подставные сайты. Создавая фальшивые домены, похожие на сайт компании-жертвы, можно рассылать от их имени фишинговые письма, увеличивающие вероятность заражения пользователя. Мы даже специальный видео-ролик сделали (на самом деле [несколько](http://gblogs.cisco.com/ru/anatomyofhack/)), который демонстрирует атаку, базирующуюся именно на данном методе атак, против которого и работают решения Cisco OpenDNS.

ЗЫ. Посмотреть и «пощупать» данное решение можно будет на Cisco Connect, которая пройдет в Москве 4-5 апреля, где у нас запланирована [насыщенная программа](http://gblogs.cisco.com/ru/ciscoconnectsecurity/) по кибербезопасности.

|

https://habr.com/ru/post/324878/

| null |

ru

| null |

# Межпроцессное взаимодействие и Unix Domain Socket

Недавно по работе пришлось решать достаточно интересную задачу.

Нужно было написать приложение — демон, которое записывает мультикаст поток в файл.

При этом необходимо было писать несколько мультикаст потоков параллельно…

Более того… нужно централизованно управлять этими демонами!

##### Немного теории

По сути само приложение по себе — достаточно простое… Но вот встает вопрос управления… Когда демон уже запущен — ему надо передавать команды… например сменить файл, в который пишется поток… или вообще прекратить запись. Встал вопрос — как управлять такими демонами…

Перелапатив несколько страниц гугла и начитавшись заумных статей было решено остановиться на варианте с Unix Domain Socket…

Архитектура проста… Приложению при запуске, помимо параметров «чего куда писать» передается его уникальный id, по которому генерируется имя управляющего сокета ( банально sock\_[id] ). Все сокеты создаются в заранее оговоренной директории на сервере… пусть это будет /tmp/my\_socks/.

Таким образом приложение-менеджер при запуске делает листинг этой директории и смотрит — какие процессы у него запущены… затем проводит «ping» этих процессов (через эти же сокеты) и проверяет — какие из них действительно живы… Мертвые сокеты (у которых процесс по каким-то причинам отсутствует ) — можно сразу же удалить…

Ну а после того как сокет открыт можно обмениваться любыми командами с конкретным процессом… получается вот такое двухстороннее межпроцессное взаимодействие.

Но это теория! Ниже немного практики…

##### Реализация

Приложение, записывающее поток было реализовано на gcc

Нужные нам инклуды и структуры

> `#include

> #include

> #include

> #include

> #include

> #include

> #include in.h>

> #include

> #include

> #include <string.h>

> #include

>

> int ctrlsock, ns;

> struct sockaddr\_un saun;`

Инициализируем сокет и начинаем его слушать:

> `void init\_ctrl\_socket() {

> // Создаем сокет.. Семейство AF\_UNIX указывает что это будет локальный unix-socket

> if ( ( ctrlsock = socket(AF\_UNIX, SOCK\_STREAM, 0) ) < 0 ) {

> savelog("ERROR: control socket creating error");

> exit(1);

> }

>

> // Делаем сокет неблокирующим.. чтобы при чтении не ждать..

> int flags = fcntl(ctrlsock, F\_GETFL, 0);

> if ( fcntl(ctrlsock, F\_SETFL, flags | O\_NONBLOCK) < 0 ) {

> savelog("ERROR: don't set socket on nonblocket mode");

> exit(1);

> }

>

> // Вот тут самое интересное..

> // биндим сокет. Передаем ему - путь до сокета..

>

> saun.sun\_family = AF\_UNIX;

> strcpy(saun.sun\_path, "/tmp/my\_socks/sock\_01"); // вот тут путь до сокета

> int len = sizeof(saun.sun\_family) + strlen(saun.sun\_path);

>

> if (bind(ctrlsock, (struct sockaddr \*)&saun, len) < 0) {

> savelog("ERROR: control socket binding error");

> exit(1);

> }

>

> if (listen(ctrlsock, 5) < 0) {

> savelog("ERROR: control socket listening error");

> exit(1);

> }

> }`

Прием команд из сокета:

> `void check\_ext\_command() {

> int fromlen = sizeof(struct sockaddr);

> if ( (ns = accept(ctrlsock, (struct sockaddr \*) &fsaun, &fromlen) ) > 0 ) {

> char lbuf[255];

> int ilen;

> ilen = recv( ns, &lbuf, 255, 0 );

> lbuf[ilen]='\0';

> do\_remote\_command( lbuf ); // Тут вызывается функция обработки команды..

> close(ns);

> }

> }`

Запись в сокет производиться как и обычно:

> `char msg = "my message";

> send( ns, msg, strlen(msg), 0);`

##### Менеджер для процессов

Менеджер для процессов был написан на php. Для того чтобы было удобно управлять ими через браузер…

Вот пример опроса существующих процессов

> `class reccontrol {

>

> var $socket\_path = '/tmp/my\_socks/'; // Путь где лежат сокеты приложений

> var $socket\_prefix = 'sock\_'; // Префикс сокеты (для эстетической красоты :))

> var $list = array();

>

> function getList() {

> $this->writers\_info = array();

> $arr = scandir( $this->socket\_path);

> unset($arr[ 0]); // .

> unset($arr[1]); // ..

> foreach( $arr as $k =>$s\_name ) {

> if ( !$this->ping( $s\_name ) ) {

> // Если не ответил на пинг - значит процесс умер или повис

> @unlink( $this->socket\_path . $s\_name );

> unset( $arr[$k] );

> }

> }

> $this->list = $arr;

>

> }

>

> // Реализация "опроса процессов"

> function ping( $s\_name ) {

> $socket\_name = $this->socket\_path.$s\_name; // полный путь

> $sock = $this->getSock( $socket\_name ); // Вынес в отдельную функцию для удобства

>

> if ( !$sock ) return false; // не отвечает - значит пинг не прошел

>

> $buf = "ping";

> if ( @socket\_send($sock, $buf, strlen($buf), 0) == false ) {

> return false; // не записать - значит пинг не прошел

> }

>

> $buf = '';

> @socket\_recv($sock, $buf, 1024, 0 );

> if ($buf) {

> // в $buf - то, что вернул нам процесс.. какую-то полезную инфу о себе

> addlog("Процесс " . $s\_name . " ответил: " . $buf);

> }

>

> socket\_close($sock);

> return true; // Сокет ответил - всё ок!

> }

>

> // Непосредственно создание unix сокета.. даже проще, чем в Си :)

> function getSock( $socket\_name ) {

> // Указываем, что семейство AF\_UNIX

> $socket = @socket\_create(AF\_UNIX, SOCK\_STREAM, 0);

> // в $socket\_name у нас лежит что-то типа /tmp/my\_socks/sock\_1 - т.е. путь до сокета

> if ( @socket\_connect( $socket, $socket\_name) == false ) {

>

> $err = socket\_last\_error();

> if ( $err ) {

> return false; // не удалось открыть сокет :(

> }

> } else {

> return $socket; // всё ок - возвращаем дескриптов сокета

> }

> }

>

> }`

Вот такое вот получается взаимодействие…

Здесь опубликованы только небольшие части кода — выполняющие основной функционал… Целиком просто всё это выглядит весьма громоздко и конкретная программа бесполезна обычному обывателю… Весь смысле в идеи управления…

Можно зайдя на web страничку получить информацию с нескольких процессов (она позвращается при пинге) и дать определенным процессам определенные команды…

|

https://habr.com/ru/post/97847/

| null |

ru

| null |

# Погружение в разработку на Ethereum. Часть 5: Oraclize

Доступ к объемным файлам и различные внешние динамические данные часто являются очень важной частью децентрализованного приложения. При этом в самом по себе Ethereum механизма обращения наружу не предусмотрено — смарт контракты могут читать и писать только в рамках самого блокчейна. В этой статье рассмотрим Oraclize, который как раз дает возможность взаимодействия с внешним миром путем запросов к практически любым интернет-ресурсам. Смежной темой является IPFS, вкратце упомянем и о ней.

IPFS

----

[IPFS](https://ipfs.io/) — распределенная файловая система с контентной адресацией. Это значит, что для содержимого любого файла, добавленного туда, считается уникальный хеш. Этот же хеш используется потом для поиска и получения этого содержимого из сети.

Основная информация уже описана в [этой статье](https://habr.com/post/314768/) и в нескольких других, поэтому не видим смысла повторяться.

### Зачем использовать IPFS в связке с Ethereum?

Любой сколько-нибудь объемный контент сохранять на блокчейне слишком дорого и вредно для сети. Поэтому самый оптимальный вариант — это сохранение какой-нибудь ссылки на файл, лежащий в офф-чейн хранилище, не обязательно именно IPFS. Но у IPFS есть ряд преимуществ:

* Ссылка на файл — это хеш, уникальный для конкретного содержимого файла, поэтому если мы положим этот хеш на блокчейн, то можем быть уверены, что получаемый по нему файл именно тот, который изначально и добавлялся, файл невозможно подменить

* Распределенная система страхует от недоступности конкретного сервера (из-за блокировки или других причин)

* Ссылка на файл и хеш-подтверждение объединены в одну строку, значит можно меньше записывать в блокчейн и экономить газ

Среди недостатков можно упомянуть, что раз центрального сервера нет, то для доступности файлов необходимо, чтобы хотя бы кто-то один этот файл “раздавал”. Но если у вас есть определенный файл, то подключиться к раздающим легко — запускаете у себя ipfs-демон и добавляете файл через `ipfs add`.

Технология очень подходит под идеологию децентрализации, поэтому рассматривая сейчас Oraclize, мы не раз столкнемся с использованием IPFS в разных механизмах оракулов.

Oraclize

--------

Для выполнения практически любой полезной работы смарт-контракту требуется получать новые данные. При этом нет встроенной возможности выполнить запрос из блокчейна во внешний мир. Можно конечно добавлять все что требуется транзакциями вручную, но невозможно проверить откуда эти данные взялись и их достоверность. Плюс может потребоваться организовать дополнительную инфраструктуру для оперативного обновления динамических данных, таких как курсы валют. А обновления с фиксированным интервалом приведут к перерасходу газа.

Поэтому сервис, предоставляемый [Oraclize](http://www.oraclize.it/), приходится как нельзя кстати: в смарт контракте можно отправить запрос к практически любому API или ресурсу в интернете, быть уверенным, что полученные данные пришли с указанного ресурса в неизменном виде, а результат использовать в том же самом смарт контракте.

Oraclize — это не только Ethereum сервис, похожая функциональность предоставляется и другим блокчейнам, но мы будем описывать только связку с Ethereum.

### Начало работы

Все, что нужно для начала работы — это добавить себе в проект один из файлов oraclizeAPI из [репозитория](https://github.com/oraclize/ethereum-api). Надо только выбрать подходящий для вашей версии компилятора (solc): oraclizeAPI\_0.5.sol для версий начиная с 0.4.18, oraclizeAPI\_0.4.sol — для версий от 0.4.1, oraclizeAPI\_pre0.4.sol — для всего более старого, поддержка этой версии уже прекращена. Если пользуетесь truffle, то не забудьте переименовать файл в usingOraclize — там требуется, чтобы имя файла и контракта совпадали.

Включив подходящий файл себе в проект, наследуете контракт от `usingOraclize`. И можно начинать пользоваться ораклайзом, что сводится к двум основным вещам: отправка запроса с помощью хелпера `oraclize_query`, а затем обработка результата в функции `__callback`. Простейший смарт контракт (для получения текущей цены эфира в долларах) может выглядеть так:

```

pragma solidity 0.4.23;

import "./usingOraclize.sol";

contract ExampleContract is usingOraclize {

string public ETHUSD;

event updatedPrice(string price);

event newOraclizeQuery(string description);

function ExampleContract() payable {

updatePrice();

}

function __callback(bytes32 myid, string result) {

require (msg.sender == oraclize_cbAddress());

ETHUSD = result;

updatedPrice(result);

}

function updatePrice() payable {

if (oraclize_getPrice("URL") > this.balance) {

newOraclizeQuery("Oraclize query was NOT sent, please add some ETH to cover for the query fee");

} else {

newOraclizeQuery("Oraclize query was sent, standing by for the answer..");

oraclize_query("URL", "json(https://api.coinmarketcap.com/v1/ticker/ethereum/?convert=USD).0.price_usd");

}

}

}

```

Функция, отправляющая запрос — `updatePrice`. Вы можете видеть, что сначала идет проверка, что `oraclize_getPrice(“URL”)` больше текущего баланса контракта. Это делается потому, что вызов `oraclize_query` должен быть оплачен, цена расчитывается как сумма фиксированной комиссии и оплаты газа для вызова коллбэка. `“URL”` — это обозначение одного из типов источников данных, в данном случае это обычный запрос по https, далее рассмотрим и другие варианты. Ответы по запросу могут быть заранее разобраны как json (как в примере) и несколькими другими способами (рассмотрим дальше). В `__callback` возвращается строка с ответом. В самом начале проверяется, что вызов прошел от доверенного адреса oraclize

Все варианты использования oraclize строятся по одной схеме, отличаются только источники данных и возможность добавления проверки подлинности в `__callback`. Поэтому в будущих примерах будем приводить только значащие различия.

### Цена использования

Как уже было сказано, за oraclize-запросы платится дополнительный эфир, причем снимается он с баланса контракта, а не вызывающего адреса. Исключением является только первый запрос с каждого нового контракт, он предоставляется бесплатно. Интересно еще то, что в тестовых сетях эта же механика сохраняется, но оплата идет эфиром соответствующей сети, то есть в тестнетах запросы фактически бесплатные.

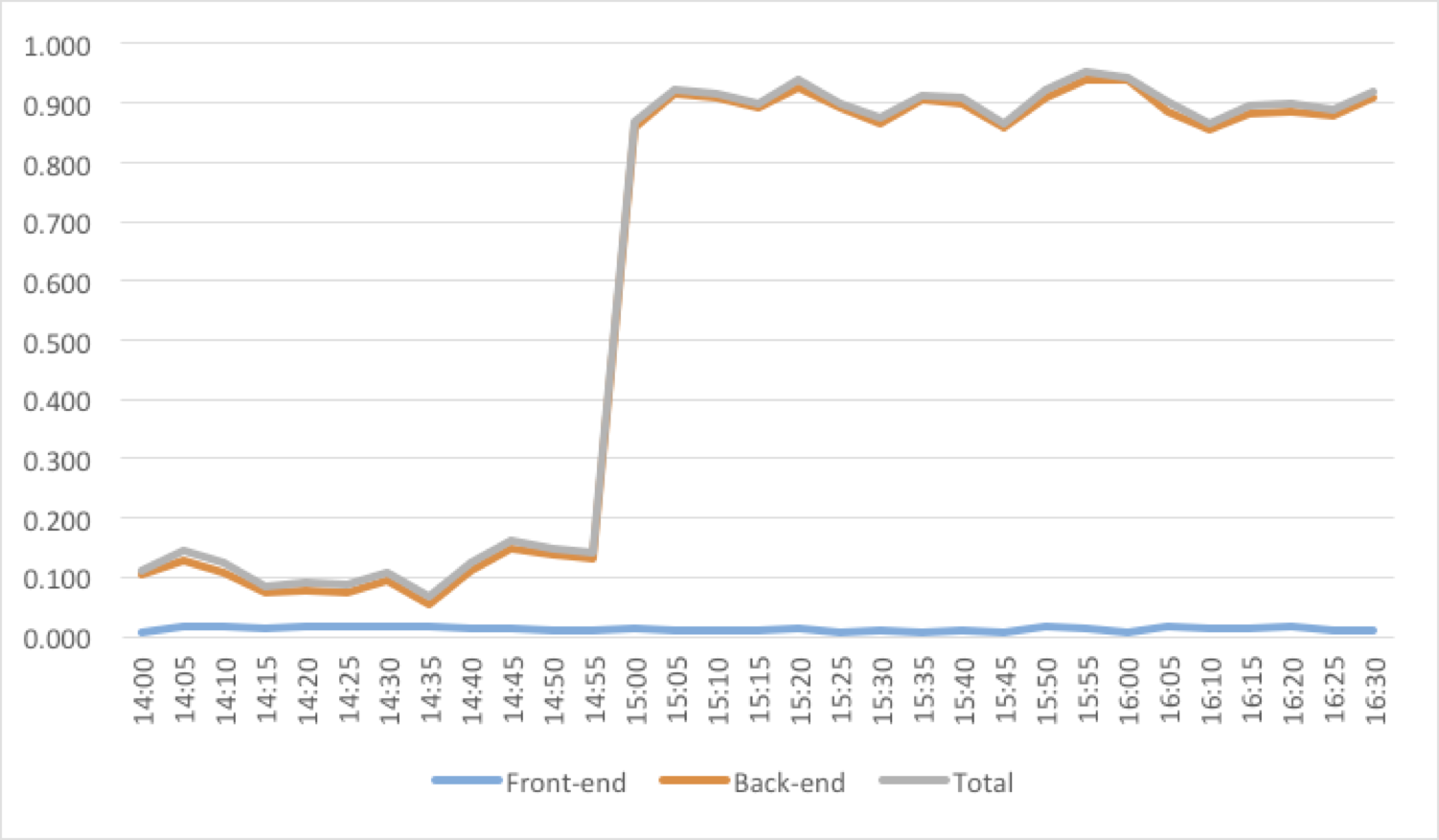

Уже упоминалось, что цена запроса складывается из двух величин: фиксированной комиссии и оплаты за газ вызова callback. Фиксированная комиссия определена в долларах, и количество эфира высчитывается из текущего курса. Комиссия зависит от источника данных и дополнительных подтверждающих механизмов, на которых мы еще остановимся. Текущая таблица цен выглядит так:

Как видите цена за URL запрос равна нескольким центам. Много это или мало? Для этого давайте рассмотрим сколько стоит вторая часть — плата за газ вызова callback.

Работает это по следующей схеме: с контракта вместе с запросом заранее переводится количество эфира, нужное для оплаты фиксированного количества газа по фиксированной цене. Этого количества должно хватить для выполнения callback, а цена должна быть адекватна рынку, иначе транзакция не пройдет или будет висеть очень долго. При этом понятно, что заранее знать количество газа не всегда возможно, поэтому и плата должна быть с запасом (запас при этом не возвращается). Значения по умолчанию — лимит 200 тысяч газа по цене 20 gwei. Этого хватает на средний callback с несколькими записями и какой-то логикой. А цена 20 gwei хоть и может в данный момент казаться слишком большой (на момент написания средняя равна 4 gwei), но в моменты наплыва транзакций рыночная цена может неожиданно подскакивать и быть даже больше, поэтому в целом эти значения близки к реально используемым. Так вот, с такими значениями и ценой эфира в районе $500, оплата газа будет приближаться к $2, так что можно сказать, что фиксированная комиссия занимает незначительную часть.

Если вы знаете что делаете, то есть вариант изменять лимит и цену газа, таким образом значительно сэкономив на запросах.

Цену на газ можно задавать отдельной функцией — `oraclize_setCustomGasPrice(<цена в wei>)`. После вызова цена сохраняется и используется во всех последующих запросах.

Лимит можно задать в самом запросе `oraclize_query`, указав его последним аргументом, например так:

```

oraclize_query("URL", "<запрос>", 50000);

```

Если у вас сложная логика в `__callback` и газа тратится больше 200к, то обязательно нужно будет задать лимит, который покрывает худший случай расхода газа. Иначе при превышении лимита `__callback` просто откатится назад.

Кстати недавно у oraclize появилась информация, что за запросы можно платить вне блокчейна, что позволит не расходовать весь лимит или возвращать остаток (и оплата идет не с контракта). Нам еще не приходилось этим пользоваться, но oraclize предлагает обращаться к ним на info@oraclize.it, если такой вариант интересен. Поэтому имейте в виду.

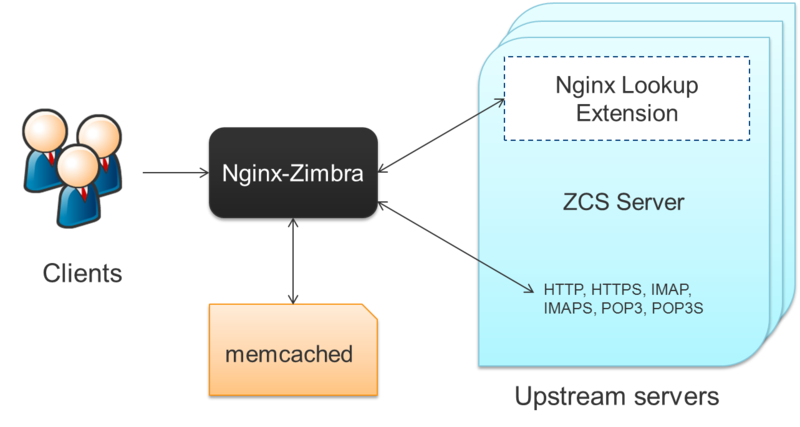

### Как работает

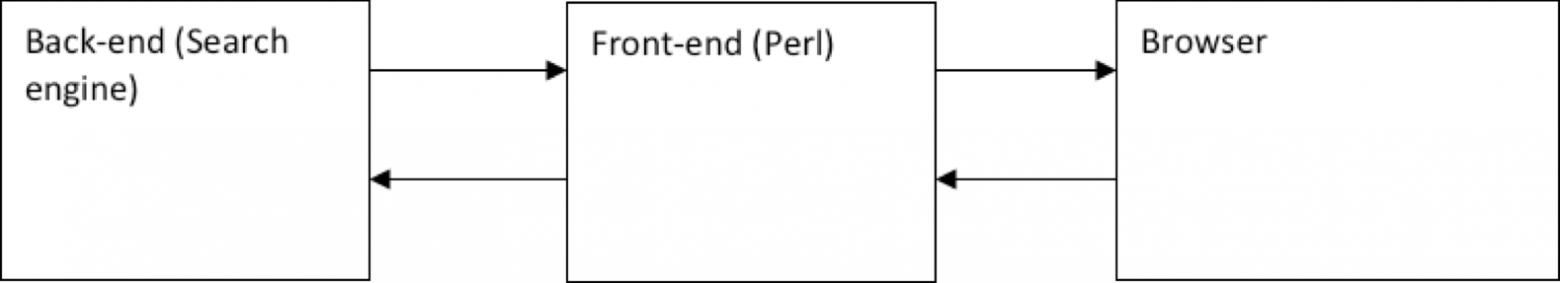

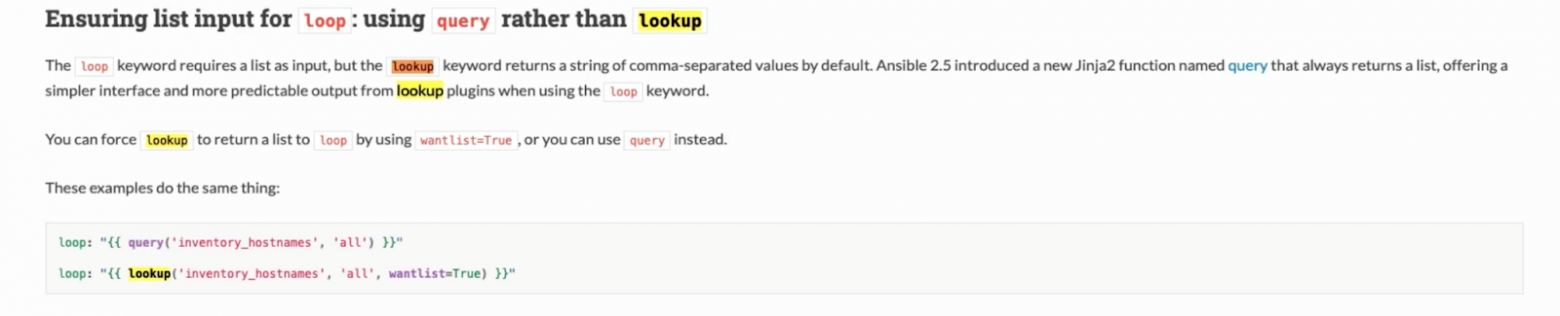

Почему унаследовавшись от обычного смарт контракта мы получаем функциональность, которая изначально не поддерживалась механизмами блокчейна? На самом деле сервис ораклайз состоит не только из контрактов с функциями-хелперами. Основную работу по получению данных делает внешний сервис. Смарт контракты формируют заявки на доступ к внешним данным и кладут их в блокчейн. Внешний сервис — мониторит новые блоки блокчейна и если обнаруживает заявку — выполняет ее. Схематично это можно изобразить так:

### Источники данных

Помимо рассмотренного `URL`, oraclize предоставляет еще 4 варианта (которые вы видели в разделе по ценам): `WolframAlpha`, `IPFS`, `random` и `computation`. Рассмотрим каждый из них.

#### 1. URL

Уже рассмотренный пример использует этот источник данных. Это источник для HTTP запросов к различным API. В примере было следующее:

```

oraclize_query("URL", "json(https://api.coinmarketcap.com/v1/ticker/ethereum/?convert=USD).0.price_usd");

```

Это получение цены эфира, и так как api предоставляет json строку с набором данных, запрос оборачивается в json-парсер и возвращает только нужное нам поле. В данном случае это GET, но источник URL поддерживает и POST запросы. Тип запроса автоматически определяется по дополнительному аргументу. Если там стоит валидный json как в этом примере:

```

oraclize_query("URL", "json(https://shapeshift.io/sendamount).success.deposit",

'{"pair":"eth_btc","amount":"1","withdrawal":"1AAcCo21EUc1jbocjssSQDzLna9Vem2UN5"}')

```

то запрос обрабатывается как POST (использующееся api описано [тут](https://info.shapeshift.io/#api-7), если интересно)

#### 2. WolframAlpha

Этот источник данных позволяет обращаться к сервису [WolframAlpha](http://www.wolframalpha.com/), который может давать ответы на различные запросы фактов или вычислений, к примеру

```

oraclize_query(“WolframAlpha”, “president of Russia”)

```

вернет `Vladimir Putin`, а запрос

```

oraclize_query(“WolframAlpha”, “solve x^2-4”)

```

вернет `x = 2`.

Как видите результат оказался неполным, потому что потерялся символ ±. Поэтому перед тем как пользоваться этим источником, нужно проверить, что значение конкретного запроса может быть использовано в смарт контракте. Кроме того для ответов не поддерживается подтверждение подлинности, поэтому сами oraclize рекомендуют использовать этот источник только для тестирования.

#### 3. IPFS

Как можно догадаться, позволяет получать содержимое файла в IPFS по мультихешу. Таймаут получения контента составляет 20 секунд.

```

oraclize_query(“IPFS”, “QmTL5xNq9PPmwvM1RhxuhiYqoTJcmnaztMz6PQpGxmALkP”)

```

вернет `Hello, Habr!` (если файл с таким содержимым все еще доступен)

#### 4. random

Генерация случайного числа работает по той же схеме, что и другие источники, но если использовать `oraclize_query`, то требуется трудоемкая подготовка аргументов. Чтобы этого избежать можно использовать функцию-хелпер `oraclize_newRandomDSQuery(delay, nbytes, customGasLimit)`, задав только задержку выполнения (в секундах), количество генерируемых байтов и лимит газа для вызова `__callback`.

У использования `random` есть пара особенностей, о которых нужно помнить:

* Для подтверждения того, что число на самом деле случайное, используется особый тип проверки — Ledger, — который можно выполнить на блокчейне (в отличие от всех остальных, но об этом позже). Это значит, что в конструкторе смарт контракта надо задать этот метод проверки функцией:

```

oraclize_setProof(proofType_Ledger);

```

А в начале коллбэка должна быть сама проверка:

```

function __callback(bytes32 _queryId, string _result, bytes _proof)

{

require (oraclize_randomDS_proofVerify__returnCode(_queryId, _result, _proof) == 0) );

<...>

```

Эта проверка требует реальной сети и не сработает на ganache, поэтому для локального тестирования можно временно убрать эту строчку. Кстати, третьим аргументом в `__callback` здесь выступает дополнительный параметр `_proof`. Он требуется всегда, когда используется один из типов подтверждения.

* Если вы используете случайное число для критических моментов, например для определения победителя в лотерее, фиксируйте пользовательский ввод до того, как отправляете newRandomDSQuery. Иначе может сложиться такая ситуация: oraclize вызывает \_callback и транзакция видна всем в списке pending. Вместе с этим видно само случайное число. Если пользователи могут продолжать, грубо говоря, делать ставки, то они смогут указать цену на газ побольше, и пропихнуть свою ставку перед тем, как выполнится \_callback, наперед зная что оно будет выигрышным.

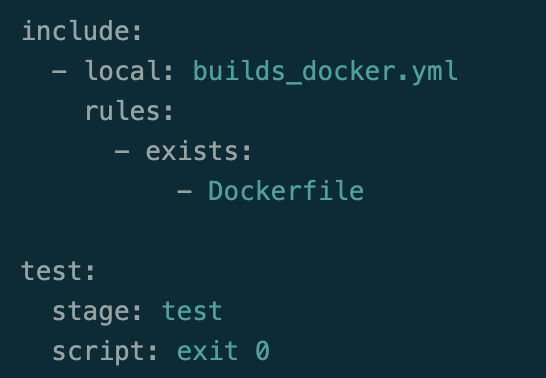

#### 5. computation

Это самый гибкий из источников. Он позволяет написать свои собственные скрипты и использовать их в качестве источника данных. Вычисления проходят на AWS. Для выполнения нужно описать Dockerfile и положить его вместе с произвольными дополнительными файлами в zip-архив, а архив загрузить в IPFS. Выполнение должно удовлетворять таким условиям:

* Писать ответ, который необходимо вернуть, последней строчкой в stdout

* Ответ должен быть не больше 2500 символов

* Инициализация и выполнение не должны идти дольше 5 минут в сумме

Для примера того, как это делается, рассмотрим как выполнить простейшее объединение переданных строк и возвращение результата.

Dockerfile:

```

FROM ubuntu:16.04

MAINTAINER "info@rubyruby.ru"

CMD echo "$ARG0 $ARG1 $ARG2 $ARG3"

```

Переменные окружения `ARG0`, `ARG1` и т.д. — это параметры, переданные вместе с запросом.

Добавляем докерфайл в архив, запускаем ipfs сервер и добавляем туда этот архив

```

$ zip concatenation.zip Dockerfile

$ ipfs daemon &

$ ipfs add concatenation.zip

QmWbnw4BBFDsh7yTXhZaTGQnPVCNY9ZDuPBoSwB9A4JNJD

```

Полученный хеш используем для отправки запроса через `oraclize_query` в смарт контракте:

```

oraclize_query("computation", ["QmVAS9TNKGqV49WTEWv55aMCTNyfd4qcGFFfgyz7BYHLdD", "s1", "s2", "s3", "s4"]);

```

В качестве аргумента выступает массив, в котором первый элемент — это мультихеш архива, а все остальные — параметры, которые попадут в переменные окружения.

Если дождаться выполнения запроса, то в `__callback` придет результат `s1 s2 s3 s4`.

### Хелперы-парсеры и вложенные запросы

Из ответа, возвращаемого любым источником, можно заранее выделить только требуемую информацию при помощи ряда хелперов, таких как:

#### 1. JSON парсер

Этот метод вы видели в самом первом примере, где из результата, который возвращает coinmarketcap, возвращалась только цена:

```

json(https://api.coinmarketcap.com/v1/ticker/ethereum/?convert=USD).0.price_usd

```

Вариант использования довольно очевидный, возвращается к примеру:

```

[

{

"id": "ethereum",

"name": "Ethereum",

"symbol": "ETH",

"rank": "2",

"price_usd": "462.857",

"price_btc": "0.0621573",

"24h_volume_usd": "1993200000.0",

"market_cap_usd": "46656433775.0",

"available_supply": "100800968.0",

"total_supply": "100800968.0",

"max_supply": null,

"percent_change_1h": "-0.5",

"percent_change_24h": "-3.02",

"percent_change_7d": "5.93",

"last_updated": "1532064934"

}

]

```

Так как это массив, берем элемент `0`, а из него — поле `price_usd`

#### 2. XML

Использование аналогично JSON, например:

```

xml(https://informer.kovalut.ru/webmaster/getxml.php?kod=7701).Exchange_Rates.Central_Bank_RF.USD.New.Exch_Rate

```

#### 3. HTML

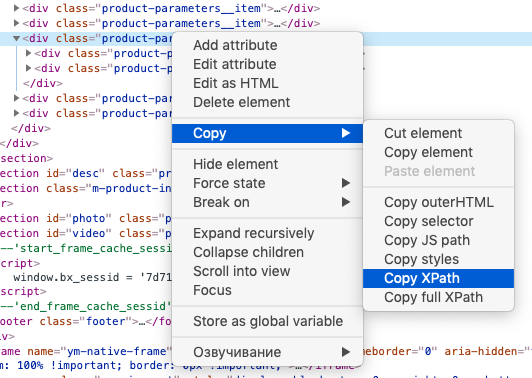

Можно парсить XHTML при помощи XPath. К примеру получить market cap с etherscan:

```

html(https://etherscan.io/).xpath(string(//*[contains(@href, '/stat/supply')]/font))

```

Получаем `MARKET CAP OF $46.148 BillionB`

#### 4. Бинарный хелпер

Позволяет вырезать куски из raw данных, используя функцию slice(offset, length). То есть например имеем файл с содержимым “abc”:

```

echo "abc" > example.bin

```

Положим его на IPFS:

```

$ ipfs add example.bin

added Qme4u9HfFqYUhH4i34ZFBKi1ZsW7z4MYHtLxScQGndhgKE

```

А теперь вырежем 1 символ из середины:

```

binary(Qme4u9HfFqYUhH4i34ZFBKi1ZsW7z4MYHtLxScQGndhgKE).slice(1, 1)

```

В ответе получаем `b`

Как вы возможно обратили внимание, в случае с бинарным хелпером использовался не URL источник, а IPFS. На самом деле парсеры можно применять к любым источникам, скажем не обязательно применять JSON к тому, что вернет URL, можно добавить такое содержимое в файл:

```

{

"one":"1",

"two":"2"

}

```

Добавить его в IPFS:

```

$ ipfs add test.json

added QmZinLwAq5fy4imz8ZNgupWeNFTneUqHjPiTPX9tuR7Vxp

```

И потом разбирать так:

```

json(QmZinLwAq5fy4imz8ZNgupWeNFTneUqHjPiTPX9tuR7Vxp).one

```

Получаем `1`

И особенно интересный вариант использования — это совмещения любых источников данных и любых парсеров в одном запросе. Такое возможно при помощи отдельного источника данных `nested`. Используем только что созданный файл в более сложном запросе (сложение значений в двух полях):

```

[WolframAlpha] add ${[IPFS] json(QmZinLwAq5fy4imz8ZNgupWeNFTneUqHjPiTPX9tuR7Vxp).one} to ${[IPFS] json(QmZinLwAq5fy4imz8ZNgupWeNFTneUqHjPiTPX9tuR7Vxp).two}

```

Получаем `3`

Запрос формируется следующим образом: указываете источник данных `nested`, далее для каждого запроса добавлятете имя источника перед ним в квадратных скобках, а все вложенные запросы дополнительно обрамляете в `${..}`.

### Тестирование

Oraclize предоставляет [полезный сервис](http://app.oraclize.it/home/test_query) проверки запросов без необходимости использовать смарт контракты. Просто заходите, выбираете источник данных, метод проверки и можете видеть, что вернется в \_\_callback, если отправлять соответветствующие запросы

Для локальной проверки в связке со смарт контрактом можно использовать [специальную версию Remix IDE](http://dapps.oraclize.it/browser-solidity/), поддерживающую oraclize-запросы.

А для проверки локально с ganache вам понадобится [ethereum bridge](https://github.com/oraclize/ethereum-bridge), который деплоит смарт контракты oraclize в ваш тестнет. Для тестирования сначала добавьте следующую строчку в конструктор вашего контракта:

```

OAR = OraclizeAddrResolverI(0x6f485C8BF6fc43eA212E93BBF8ce046C7f1cb475);

```

запустите

```

ganache-cli

```

Потом

```

node bridge --dev

```

Дождитесь когда контракты задеплоятся и можно тестировать. В выводе `node bridge` можно будет видеть отправленные запросы и полученные ответы.

Еще одна помощь не только при тестировании, но и при реальном использовании — возможность мониторинга запросов [здесь](http://app.oraclize.it/service/monitor). Если вы запрашиваете в публичной сети, то можно использовать хеш транзакции, в которой выполняется запрос. Если используете подтверждения подлинности, то имейте в виду, что они гарантированно присылаются только в mainnet, для остальных сетей может приходить 0. Если запрос был в локальной сети, то можно использовать id запроса, который возвращает `oraclize_query`. К слову, этот id рекомендуется всегда сохранять, например в подобном маппинге:

```

mapping(bytes32=>bool) validIds;

```

Во время запроса помечать id отправленных как `true`:

```

bytes32 queryId = oraclize_query(<...>);

validIds[queryId] = true;

```

А потом в `__callback` проверять, что запрос с таким id еще не обрабатывался:

```

function __callback(bytes32 myid, string result) {

require(validIds[myid] != bytes32(0));

require(msg.sender == oraclize_cbAddress());

validIds[myid] = bytes32(0);

<...>

```

Нужно это потому, что `__callback` на один запрос может вызываться не один раз из-за особенностей работы механизмов Oraclize.

### Проверка подлинности

В таблице с источниками вы могли видеть, что разные источники могут поддерживать разные типы подтверждений, и может взиматься разная комиссия. Это очень важная часть oraclize, но подробное описание этих механизмов — отдельная тема.

Чаще всего используемый механизм, по крайней мере нами — [TLSNotary](https://tlsnotary.org/) с хранением в IPFS. Хранение в IPFS эффективнее, потому что в `__callback` возвращается не само доказательство (может быть в районе 4-5 килобайт), а намного меньший по размеру мультихеш. Чтобы задать этот тип, добавьте строку в конструкторе:

```

oraclize_setProof(proofType_TLSNotary | proofStorage_IPFS);

```

Можем сказать только, что этот тип, грубо говоря, защищает нас от недостоверности данных, полученных от Oraclize. Но Oraclize использует сервера Amazon, которые и выступают аудитором, так что им приходится только доверять.

Подробнее читайте [тут](https://docs.oraclize.it/#ethereum-quick-start-authenticity-proofs).

Заключение

----------

Oraclize предоставляет средства, которые значительно увеличивают количество use-кейсов для смарт контрактов, как и IPFS, который можно увидеть и в нескольких вариантах запросов ораклайза. Основная проблема в том, что мы опять же используем внешние данные, которые подвержены тем угрозам, от которых блокчейн должен был защитить: централизация, возможности блокировки, изменения кода, подмены результата. Но пока это все неизбежно, и вариант получения данных весьма полезный и жизнеспособный, просто надо отдавать себе отчет, зачем вводилось использование блокчейна в проект и не сводит ли обращение к внешним ненадежным источникам пользу к нулю.

Если интересны какие-то темы разработки на Ethereum пока не раскрытые в этих статьях — пишите в комментариях, возможно раскроем в следующих.

Погружение в разработку на Ethereum:

[Часть 1: введение](https://habrahabr.ru/post/336132/)

[Часть 2: Web3.js и газ](https://habrahabr.ru/post/336770/)

[Часть 3: приложение для пользователя](https://habrahabr.ru/post/339080/)

[Часть 4: деплой и дебаг в truffle, ganache, infura](https://habr.com/post/348656/)

|

https://habr.com/ru/post/417681/

| null |

ru

| null |

# Используем трейты для полиморфных связей в Laravel

#### Введение

Поговорим о возможном применении трейтов вместе с полиморфными отношениями в Laravel.

**Содержание статьи:**

1. [Описание предметной области](#start)

2. [Создание приложения](#app)

3. [Возможные структуры БД](#database)

4. [Создание сущностей](#entities)

5. [Использование трейта](#traits)

6. [Написание тестов](#tests)

#### Описание предметной области

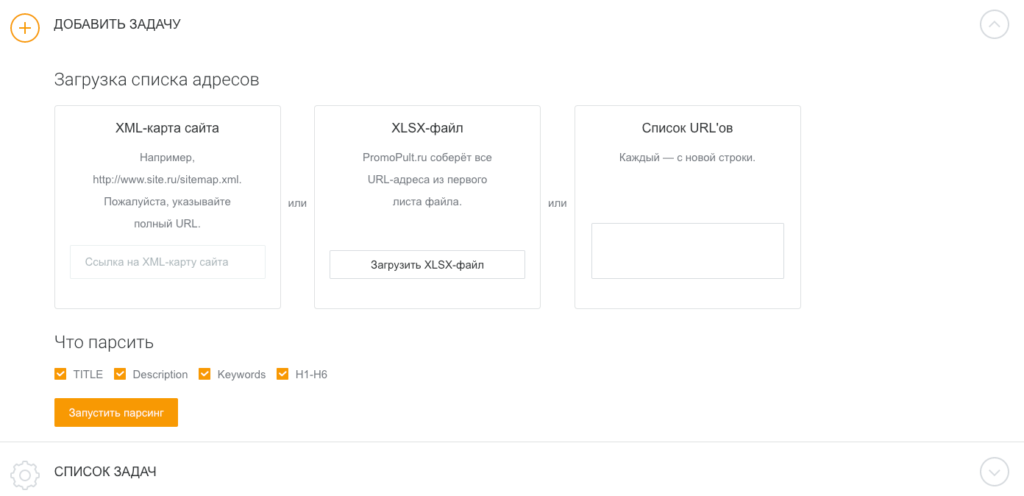

Мы будем разрабатывать систему, в которой некие сотрудники и некие команды могут быть прикреплены к проекту. Сущностями предметной области будут сотрудники, команды и проекты: команда состоит из сотрудников, на проект могут быть прикреплены сотрудники и команды. Между командой и сотрудником отношение many-to-many (допустим, что сотрудник может участвовать в разных командах), many-to-many между проектами и сотрудниками, many-to-many между командами и проектами. Для дальнейшего рассмотрения опустим реализацию связи между командой и сотрудниками, сосредоточимся на отношении команд и сотрудников к проекту.

#### Создание приложения

Приложения на Laravel очень просто создавать, используя [пакет-создатель приложений](https://laravel.com/docs/7.x#installing-laravel). После его установки создание нового приложения умещается в одну команду:

```

laravel new system

```

#### Возможные структуры БД

Если идти нормализованным путем, то нам понадобится три таблицы для сущностей и ещё три таблицы для связей: сотрудники-команды, сотрудники-проекты, команды-проекты.

Если снизить уровень нормализации, то можно объединить таблицы для связей сотрудник-проект и команда-проект в одну, разделяя тип связи по дополнительному полю с типом (допустим, 1 — сотрудник, 2 — команда).

Идея [морф-связей](https://laravel.com/docs/7.x/eloquent-relationships#polymorphic-relationships) похожа на менее нормализованный вариант, только вместо дополнительного поля с типом используется два — один для имени класса модели, второй для её идентификатора.

#### Создание сущностей

Нам понадобятся модели, миграции и фабрики для сотрудников, команд, проектов и прикреплений. Команды для создания всего этого:

```

php artisan make:model Employee -f // модель и фабрика сотрудника

php artisan make:model Team -f // модель и фабрика команды

php artisan make:model Project -f // модель и фабрика проекта

php artisan make:migration CreateEntitiesTables // общая миграция для всех сущностей

php artisan make:model Attach -m // модель и миграция прикрепления

```

После выполнения команды мы получим файлы моделей в App/, файлы миграций в папке database/migrations/ и фабрики в database/factories/.

**Перейдём к написанию миграций**. Во всех сущностях может быть много полей, но мы возьмем по минимуму: у сотрудника, команды и проекта будет только имя. Позволю себе сократить список миграций до двух — для сущностей и для полиморфного отношения.

**Миграция для сущностей**

```

php

use Illuminate\Database\Migrations\Migration;

use Illuminate\Database\Schema\Blueprint;

use Illuminate\Support\Facades\Schema;

class CreateEntitesTables extends Migration

{

/**

* Run the migrations.

*

* @return void

*/

public function up()

{

Schema::create('employees', function (Blueprint $table) {

$table-id();

$table->string('name');

$table->timestamps();

});

Schema::create('teams', function (Blueprint $table) {

$table->id();

$table->string('name');

$table->timestamps();

});

Schema::create('projects', function (Blueprint $table) {

$table->id();

$table->string('name');

$table->timestamps();

});

}

/**

* Reverse the migrations.

*

* @return void

*/

public function down()

{

Schema::dropIfExists('employees');

Schema::dropIfExists('teams');

Schema::dropIfExists('projects');

}

}

```

**Для полиморфного отношения**

```

php

use Illuminate\Database\Migrations\Migration;

use Illuminate\Database\Schema\Blueprint;

use Illuminate\Support\Facades\Schema;

class CreateAttachesTable extends Migration

{

/**

* Run the migrations.

*

* @return void

*/

public function up()

{

Schema::create('attachments', function (Blueprint $table) {

$table-id();

$table->morphs('attachable');

$table->unsignedInteger('project_id');

$table->timestamps();

$table->foreign('project_id')->references('id')->on('projects')

->onDelete('cascade');

});

}

/**

* Reverse the migrations.

*

* @return void

*/

public function down()

{

Schema::dropIfExists('attachments');

}

}

```

Обратите внимание, что для создания полей полиморфного отношения нужно указать функцию morphs().

**Теперь к моделям**

Модель команды идентична модели сотрудника:

```

php

namespace App;

use Illuminate\Database\Eloquent\Model;

class Employee extends Model

{

protected $fillable = ['name'];

}</code

```

```

php

namespace App;

use Illuminate\Database\Eloquent\Model;

class Team extends Model

{

protected $fillable = ['name'];

}</code

```

**Модель проекта**

```

php

namespace App;

use Illuminate\Database\Eloquent\Model;

use Illuminate\Database\Eloquent\Relations\HasMany;

use Illuminate\Database\Eloquent\Relations\MorphToMany;

class Project extends Model

{

protected $fillable = ['name'];

/**

* Relation for project attachments

* @return HasMany

*/

public function attachments()

{

return $this-hasMany(Attach::class);

}

/**

* Relation for project employees

* @return MorphToMany

*/

public function employees()

{

return $this->morphedByMany(Employee::class, 'attachable', 'attachments');

}

/**

* Relation for project teams

* @return MorphToMany

*/

public function teams()

{

return $this->morphedByMany(Team::class, 'attachable', 'attachments');

}

}

```

**Прикрепление**

```

php

namespace App;

use Illuminate\Database\Eloquent\Model;

class Attach extends Model

{

protected $table = 'attachments';

protected $fillable = ['attachable_id', 'attachable_type', 'project_id'];

}</code

```

**Фабрики** идентичны для всех сущностей

```

php

/** @var \Illuminate\Database\Eloquent\Factory $factory */

use Faker\Generator as Faker;

$factory-define(/* (сотрудник/команда/проект) */, function (Faker $faker) {

return [

'name' => $faker->colorName

];

});

```

Сущности готовы, переходим к трейту.

#### Использование трейта

Полиморфные отношения в Laravel подразумевают разные типы отношений для главных и прикрепляемых моделей — в проекте указывается тип связи morphedByMany(), а в сущностях — morphToMany(). Для всех прикрепляемых моделей метод для описания связи будет одинаков, поэтому логично вынести этот метод в трейт и использовать его в модели сотрудника и команды.

Создадим новую директорию app/Traits и трейт с названием полиморфного отношения: Attachable.php

```

php

namespace App\Traits;

use App\Project;

use Illuminate\Database\Eloquent\Relations\MorphToMany;

trait Attachable

{

/**

* Relation for entity attachments

* @return MorphToMany

*/

public function attachments()

{

return $this-morphToMany(Project::class, 'attachable', 'attachments');

}

}

```

Осталось добавить этот трейт в модели сотрудника и команды через use.

```

...

use Attachable;

...

```

Переходим к проверке работоспособности с помощью тестов.

#### Написание тестов

[По стандарту](https://laravel.com/docs/7.x/testing), Laravel использует PHPUnit для тестирования. Создать тесты для связи:

```

php artisan make:test AttachableTest

```

Файл теста можно найти в tests/Feature/. Для обновления состояния БД перед запуском тестов будем использовать трейт RefreshDatabase.

**Проверим работу морфа со стороны проекта и трейта со стороны команды и сотрудников**

```

php

namespace Tests\Feature;

use App\Team;

use App\Employee;

use App\Project;

use Illuminate\Foundation\Testing\RefreshDatabase;

use Tests\TestCase;

class OrderTest extends TestCase

{

use RefreshDatabase;

/** @test */

public function polymorphic_relations_scheme(): void

{

// Given project

$project = factory(Project::class)-create();

// Given team

$team = factory(Team::class)->create();

// Given employee

$employee = factory(Employee::class)->create();

// When we add team and employee to project

$project->teams()->save($team);

$project->employees()->save($employee);

// Then project should have two attachments

$this->assertCount(2, $project->attachments);

$this->assertCount(1, $project->teams);

$this->assertCount(1, $project->employees);

$this->assertEquals($team->id, $project->teams->first()->id);

$this->assertEquals($employee->id, $project->employees->first()->id);

// Team and employee should have attachment to project

$this->assertCount(1, $team->attachments);

$this->assertCount(1, $employee->attachments);

$this->assertEquals($project->id, $team->attachments->first()->id);

$this->assertEquals($project->id, $employee->attachments->first()->id);

}

}

```

Тест прошел!

Трейты позволяют не дублировать общие методы для полиморфных отношений внутри классов моделей, также их можно использовать, если у вас есть одинаковые поля во многих таблицах (например, автор записи) — тут тоже можно сделать трейт с методом связи.

Буду рад слышать ваши кейсы применения трейтов в Laravel и PHP.

|

https://habr.com/ru/post/494658/

| null |

ru

| null |

# Round Table: архитектурный UI паттерн для iOS платформы

На связи Станислав Потемкин, iOS Tech Lead в компании Jivo.

Среди архитектурных паттернов большой популярностью вполне заслуженно пользуются универсальные MVC, MVP, MVVM, VIPER, и слегка платформенный Clean Swift (VIP).

У каждого из них свои особенности, каждый хорош в той или иной ситуации. Идеального для всех случаев инструмента, как известно, не существует: нужно выбирать с учётом проекта и команды.

На хабре уже [была статья](https://habr.com/ru/company/badoo/blog/281162/) многолетней давности с неплохим разбором особенностей большинства этих паттернов, а именно: MVC, MVP, MVVM, VIPER. Плюс также [есть статья](https://habr.com/ru/post/453986/) отдельно про Clean Swift (VIP).

Мы в Jivo сначала пользовались подобием MVP, но затем со временем (и по мере роста) нам начали открываться некоторые не очень комфортные особенности этого паттерна для наших реалий. Соответственно, была произведена попытка выбрать наиболее комфортный из других популярных, но везде встречались те или иные не очень приятные нюансы.

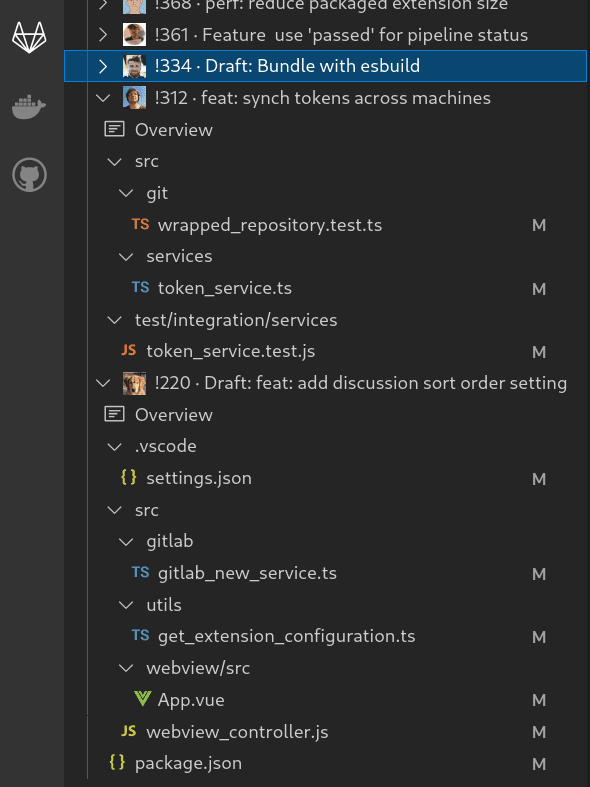

В итоге мы решили ~~изобрести свой велосипед~~ исследовать область архитектурного вопроса с нового ракурса, и в последствии пришли к собственному паттерну, который получил наименование Round Table.

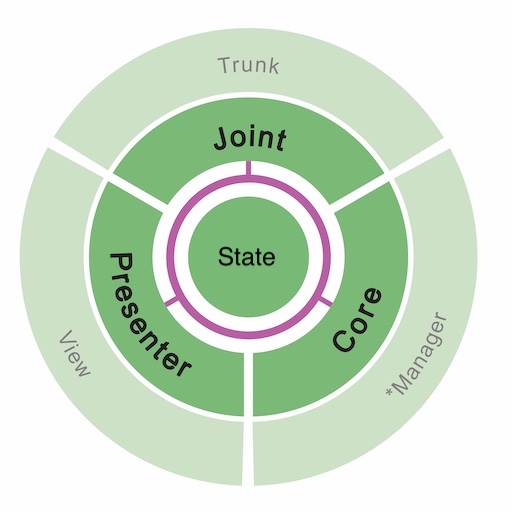

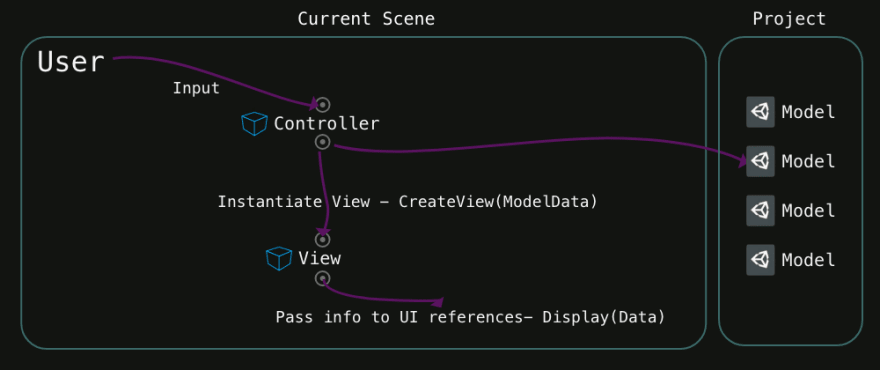

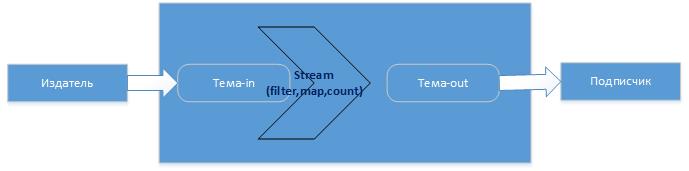

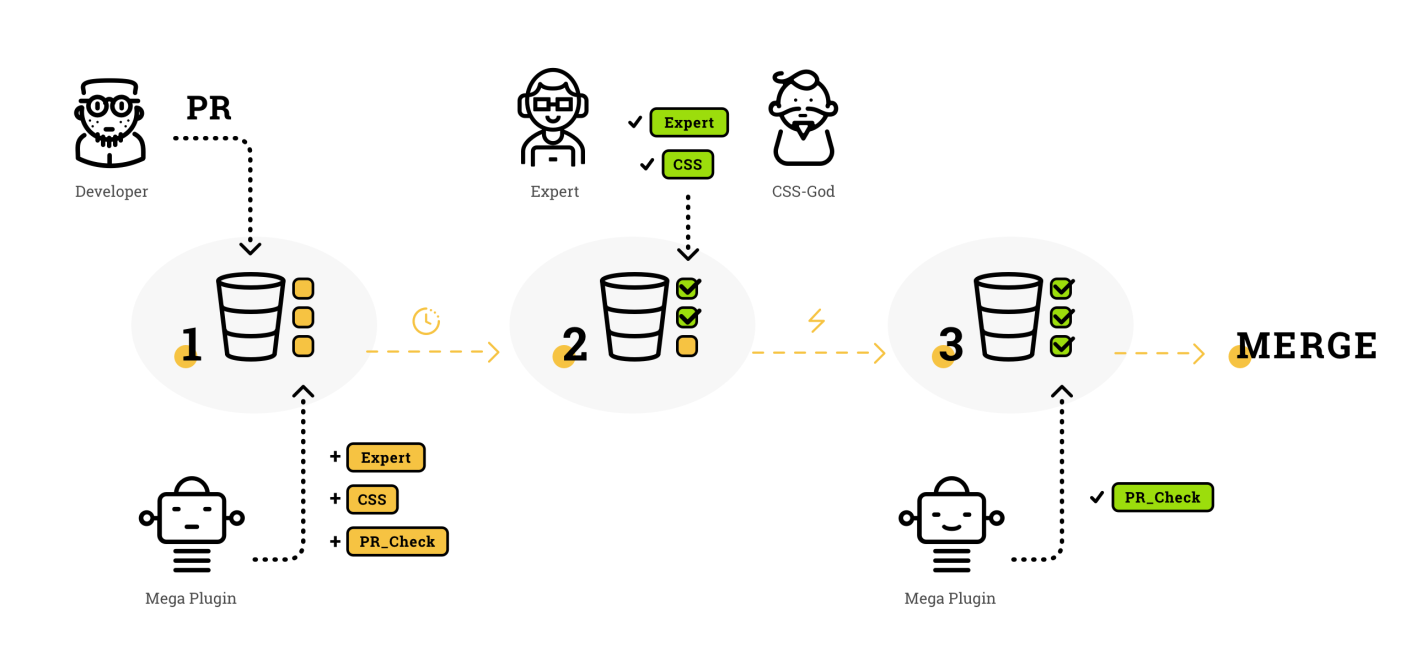

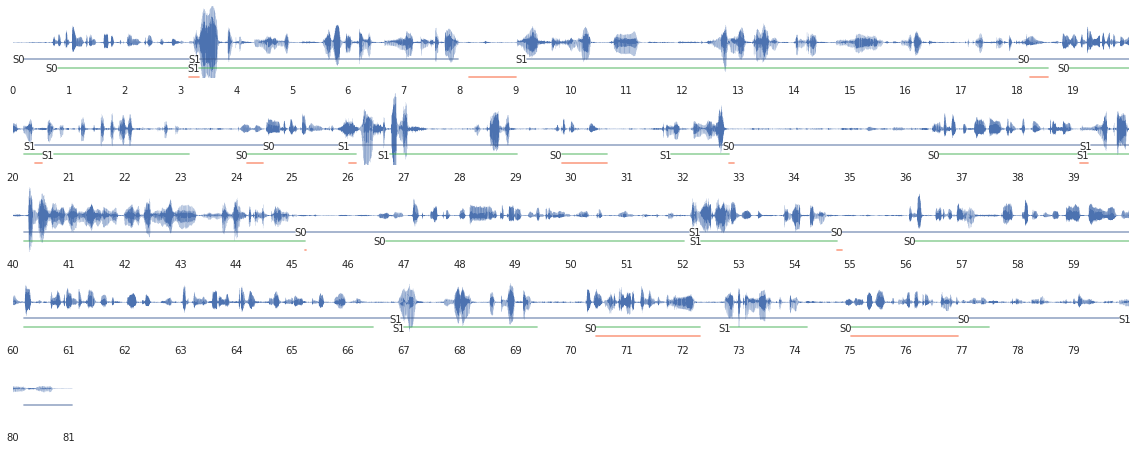

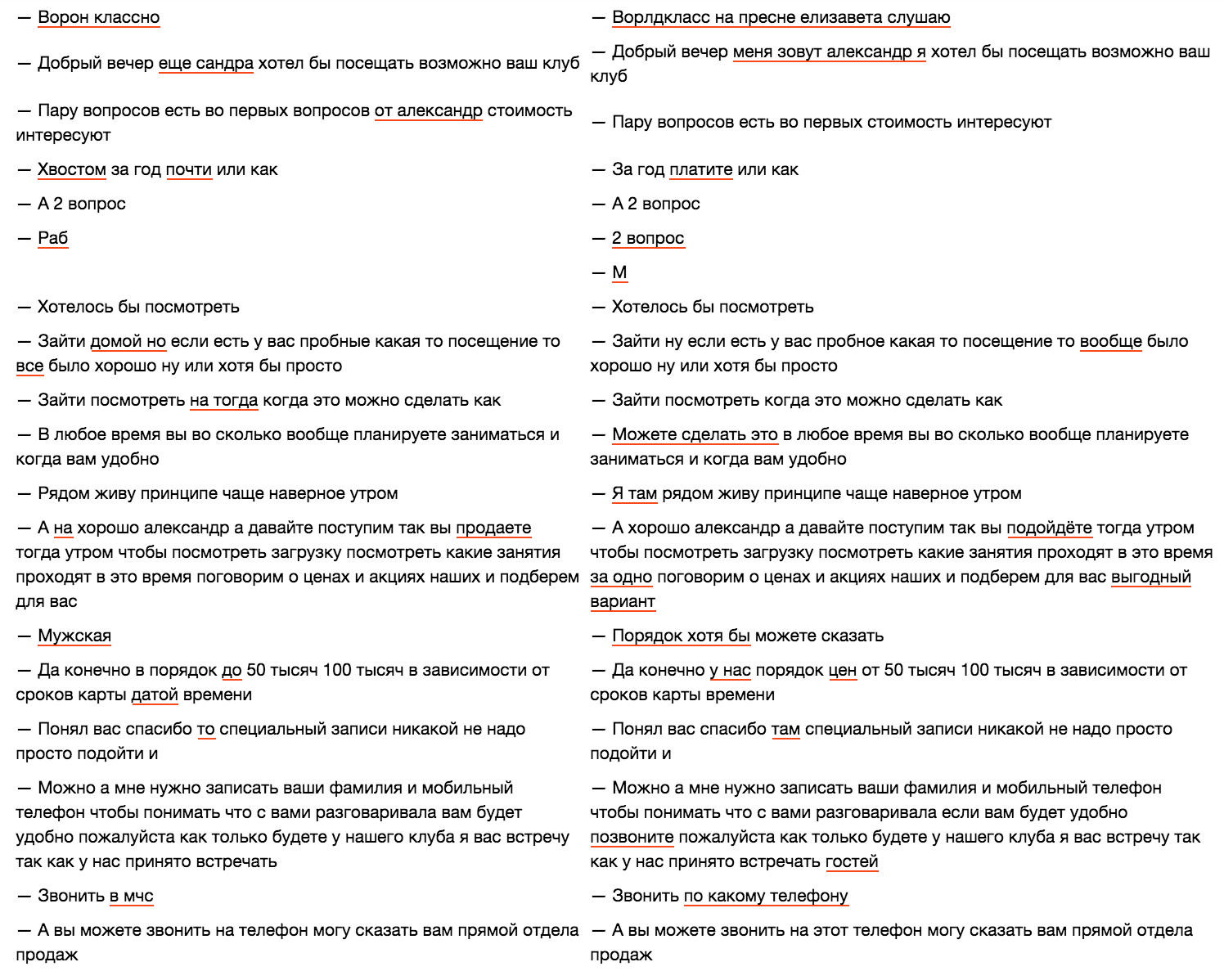

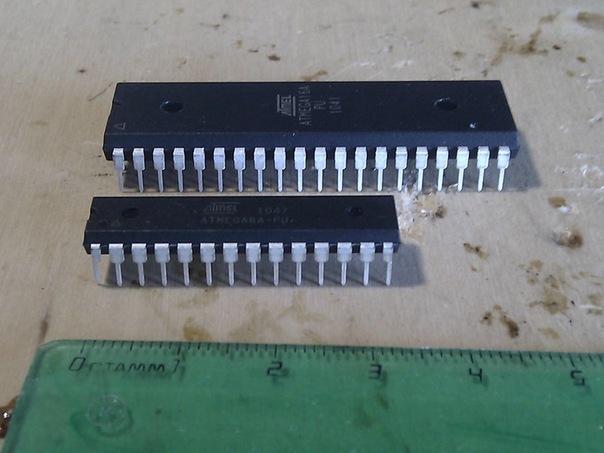

Общая схема модуля в Round Table

---

Общий план повествования:

-------------------------

* [Причины появления](#reasons)

* [Суть нашего варианта](#essense)

* [Где найти, как использовать, какие планы](#repo)

Есть вероятность, что структура статьи местами может оказаться не особо удобной для восприятия, либо не везде достаточно детально раскрывается суть принятых решений. Если в комментариях появится тому подтверждение, буду по мере возможности дополнять текст.

P.S. На этапе подготовки статьи картинка-схема иногда по какой-то причине подгружалась лишь наполовину. Если у вас отображается размытое зелёное месиво, попробуйте обновить страницу.

Причины появления

-----------------

### Причина #1: коммуникация между логикой и UI

В большинстве паттернов между логикой и UI есть промежуточный слой, который зачастую зовётся Presenter или Mediator, и он имеет предрасположенность к быстрому увеличению в размерах. Несмотря на его задачу по подготовке данных к отображению, часто этот слой примерно наполовину обретает свойства двустороннего маршрутизатора запросов между логикой и UI.

Однако, у нас имеется Clean Swift (VIP), где эта проблема решена коммуникацией из UI напрямую в логику. Этот подход позволяет частично решить проблему маршрутизации, что приятно. Но другие сложности на этом не заканчиваются, потому идём дальше.

### Причина #2: навигация между экранами

Подавляющее большинство серьёзных приложений содержат несколько экранов, а нередко и десятки таковых. Разумеется, где-то должна находиться и логика роутинга между ними.

Так уж получилось, что семейство MV\* и VIPER тоже по определённым причинам нам не очень подошли. Что же пошло не так?

Не думаю, что станет ошибкой заявить: в описании большинства UI паттернов выделено мало внимания вопросу навигации между экранами. Впрочем, VIPER и Clean Swift (VIP) получились чуть более детализированными в этом вопросе.

В случае с VIPER за роутинг отвечает компонент Wireframe, который доступен из Presenter. Но если нужно показать какой-то экран в ответ на событие из логики (Interactor), то такая команда вынуждена проходить в Wireframe через Presenter, что опять приводит к избытку маршрутизации. Нам хотелось оставить как можно меньше проксирующего кода.

В случае с Clean Swift (VIP) задача роутинга лежит на компоненте Router, выход к которому есть у ViewController, что означает перенос логики маршрутизации в UI слой, а это не есть приятно, это привязывает нас к платформенным особенностям. Плюс, опять же, надобность проксирующего вызова в случаях, когда Interactor играет роль инициатора перехода. Нам был предпочтителен вариант оставить логику маршрутизации ближе к логике, чем к UI.

### Причина #3: неудобство масштабирования

Когда с течением времени тот или иной компонент развивается и расширяется (будь то Interactor, Presenter, Mediator или какой-либо еще), в большинстве случаев нужно добавить соответствующую декларацию в два места: интерфейс и реализацию (мы трудимся с уважением к SOLID). Это распространённый классический подход, но нам хотелось добиться более компактного кода при расширении.

### Причина #4: компоненты лезут друг в друга

Как типично выглядит обращение из одного компонента к другому? Как правило, один компонент сообщает другому, что тот должен сделать.

> Пример из MVP в стиле:

> «эй, Presenter, выполни свой метод showGreeting()»

>

>

```

func didTapGreetingButton(button: UIButton) {

self.presenter.showGreeting()

}

```

> Пример из MVVM в стиле:

> «эй, ViewModel, выполни свой метод showGreeting()»

>

>

```

func didTapGreetingButton(button: UIButton) {

self.viewModel?.showGreeting()

}

```

> Пример из VIPER в стиле:

> «эй, Presenter, выполни свой метод showGreeting()»

>

>

```

func didTapGreetingButton(button: UIButton) {

self.presenter.showGreeting()

}

```

> Пример из Clean Swift (VIP) в стиле:

> «эй, Interactor, выполни свой метод showGreeting()»

>

>

```

func didTapGreetingButton(button: UIButton) {

self.interactor?.showGreeting()

}

```

С одной стороны, подобные варианты – это вполне нормальное положение вещей в мире ООП, но с другой стороны «терзают смутные сомнения»: в глубине души хотелось бы использовать событийный подход вместо императивного.

---

Суть нашего варианта

--------------------

В итоге, взвесив ситуацию, мы принялись формировать наше архитектурное видение по этому вопросу. Итак, теперь рассмотрим, какие принципы построения в итоге решено было применить.

Паттерн получил название Round Table по той причине, что отчасти напоминает историю о короле Артуре и рыцарях круглого стола. Как и рыцари за круглым столом, компоненты модуля трудятся во благо общей цели, но при этом равны между собой и сигнатурно независимы друг от друга.

### Принцип #1: компоненты модуля и их слои ответственности

#### Presenter: контролирует UI

**Presenter** умеет подготавливать модель данных для отображения к передаче во **View** и производить какие-то дополнительные трансформации (например, приписать символ валюты к стоимости товара или взять какую-то надпись из ресурсов-переводов).

#### Core: контролирует бизнес-логику

**Core** имеет доступ к функциональным компонентам системы (менеджеры, сервисы, адаптеры, итд) и, взаимодействуя с ними, умеет реализовывать бизнес-логику и обработку информации.

#### Joint: контролирует иерархию модулей

**Joint** (в переводе: сочленение, сустав) занимается управлением иерархией экранов, в том числе взаимодействует с навигаторами и табами, push и pop, present и dismiss.

#### State: хранит состояние и доступен для всех остальных

**State** может хранить в себе какие-то оперативные данные, которые нужны для функционирования данного модуля. Например, текст ошибки, которая возникла при обработке запроса в **Core**, и которую в итоге нужно отобразить во **View**. Или введённый в поле текст, который нужно будет обработать через некоторое время по кнопке. Доступ к **State** имеют все остальные функциональные компоненты (например, **Core** может туда что-то сохранить, а **Presenter** что-то прочитать при подготовке модели данных для **View**).

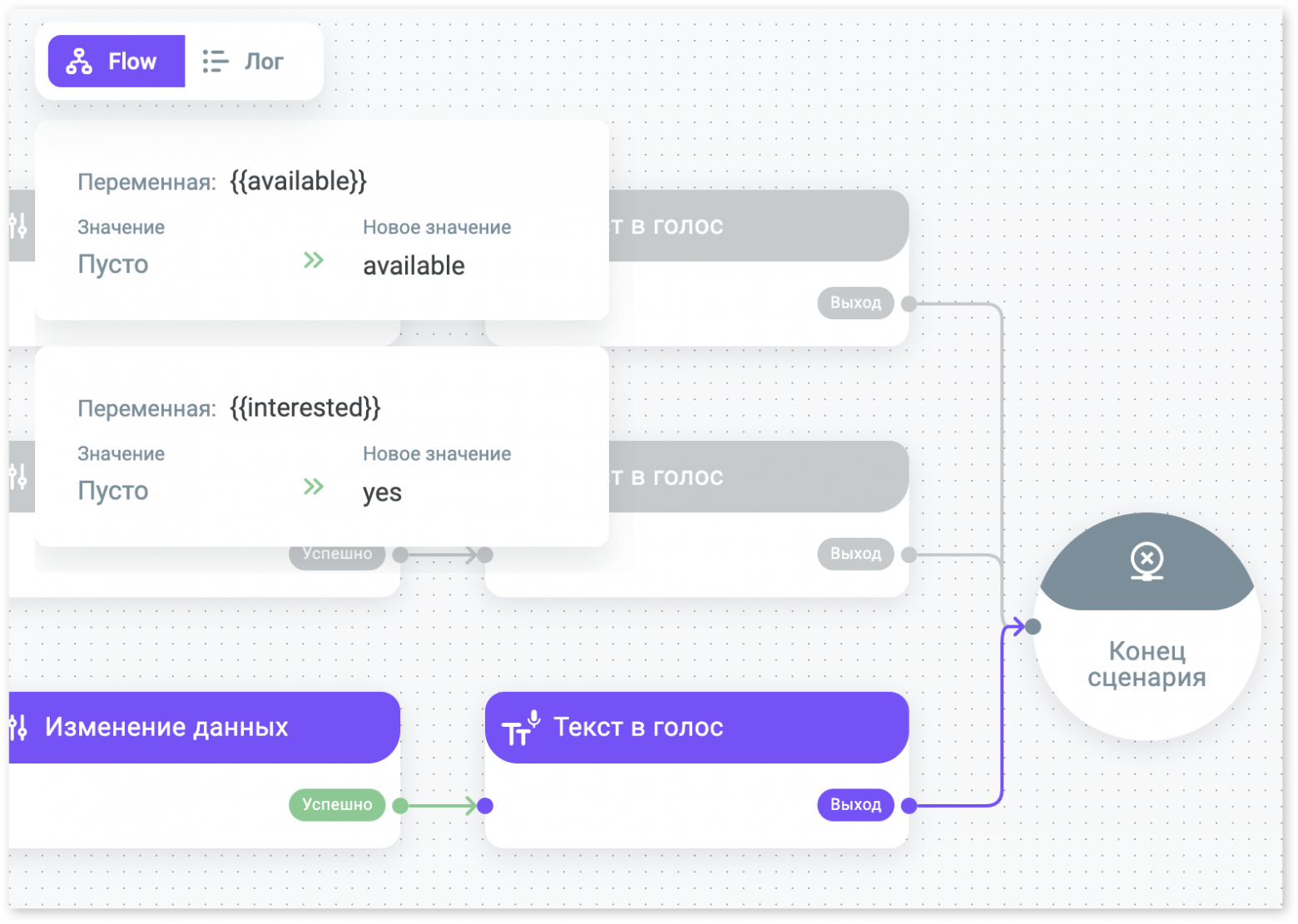

Продублирую еще раз картинку из начала статьи, которая вкратце описывает взаимодействие компонентов между собой:

#### Assembly

Осталось упомянуть лишь про вспомогательную функцию сборки, которая занимается созданием компонентов и сборкой модуля воедино. Например, она может выглядеть таким образом (вспомогательная generic функция `RTEModuleAssembly()` является общей для всех и помогает соединить компоненты в нужном порядке):

```

func LoginModuleAssembly(trunk: Trunk) -> LoginModule {

return RTEModuleAssembly(

pipeline: LoginModulePipeline(),

state: LoginModuleState(),

coreBuilder: { pipeline, state in

LoginModuleCore(

pipeline: pipeline,

state: state,

authManager: trunk.authManager

)

},

presenterBuilder: { pipeline, state in

LoginModulePresenter(

pipeline: pipeline,

state: state

)

},

viewBuilder: { pipeline in

LoginModuleView(

pipeline: pipeline

)

},

jointBuilder: { pipeline, state, view in

LoginModuleJoint(

pipeline: pipeline,

state: state,

view: view,

trunk: trunk

)

})

}

```

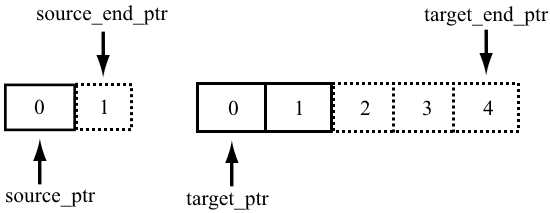

### Принцип #2: коммуникация между компонентами

Компоненты ничего не знают о существовании друг друга, они являются изолированными. В качестве основы коммуникации выступает шина данных *Pipeline*. *Pipeline* распространяет сообщения от любого компонента ко всем остальным.

Если, например, произойдёт некое обновление данных внутри компонента **Core**, он может поделиться этой новостью с остальными посредством *Pipeline*. Для этого **Core** передаст команду в *Pipeline*, которая в свою очередь распространит его по всем остальным компонентам - **Presenter** и **Joint**. Похожим образом **View** посредством *Pipeline* может поделиться чем-то с **Core**, **Presenter** и **Joint**.

```

// Core sends [Event=dataUpdate] to Pipeline

enum CoreEvent {

case dataUpdate

}

private func handleDataUpdated() {

self.pipeline?.notify(event: .dataUpdate)

}

// Presenter receives [Event=dataUpdate] from Pipeline

override func handleCore(event: CoreEvent) {

switch event {

case .dataUpdate:

self.updateView()

}

}

// Joint receives [Event=dataUpdate] from Pipeline

override func handleCore(event: CoreEvent) {

// ...

}

```

Как можно заметить, вместо вызова методов использованы перечисления с ассоциативными значениями.

Это позволяет превратить классический императивный подход «выполни у себя вот этот метод» в событийный «у меня произошло некое событие, при желании можешь это учесть». Таким образом, компонент не лезет в конкретный интерфейс другого компонента, а лишь информирует о том, что именно произошло у него самого.

Кроме того, для расширения функциональности достаточно добавить дополнительный case в перечисление и обработать его в switch (ну или вставить заземляющий default блок, при желании).

В итоге, например, вместо такого кода:

```

func didTapButton(button: UIButton) {

self.viewModel?.showGreeting()

}

```

В Round Table используется такой:

```

func didTapButton(button: UIButton) {

self.pipeline.notify(intent: .greetingButtonTap)

}

```

И еще одно крайне важное замечание. *Pipeline* организована таким образом, что управляющие события проходят по пути **Core** -> **Presenter** -> **Joint**. То есть, в зависимости от отправителя сигнала, он пойдёт по соседям следующим образом:

* *Event* из **Core** – в **Presenter** и **Joint**

* *Intent* из **View** – в **Core**, **Presenter** и **Joint**

* *Input* из **Joint** – в **Core** и **Presenter**

Это намеренное правило, которое объясняется следующим образом: зачастую практически любое изменение (или команда извне) влияют на внутреннее состояние системы. Поэтому первым уведомление получает **Core**, чтобы иметь возможность обновить **State** (если нужно). Далее актуальное состояние системы имеет смысл отобразить на экране, поэтому вторым в очереди является **Presenter**. И последним будет проинформирован **Joint** на случай, если надо передать какую-то информацию вверх по иерархии, наружу.

Именно этот подход по очерёдности передачи широковещательных событий позволил нам избавиться от многочисленных рукописных прокси-вызовов, свойственных некоторым другим паттернам.

### Принцип #3: взаимодействие между разными модулями

Поскольку компонент **Joint** отвечает за построение иерархии модулей, то и создание дочерних модулей тоже происходит внутри него.

Рассмотрим ситуацию, при которой из нашего активного модуля (экрана) надо отобразить модальное окно для ввода комментария, получить из него введённое текстовое значение, и закрыть его обратно. Ориентировочно кодовая база для такого cценария может выглядеть, например, таким образом:

```

// View sends [Intent=commentButtonTap] to Pipeline

enum ViewIntent {

case commentButtonTap

}

@objc private func didTapCommentButton() {

self.pipeline.notify(intent: .commentButtonTap)

}

// Joint receives [Intent=commentButtonTap] from Pipeline

override func handleView(intent: ViewIntent) {

switch intent {

case .commentButtonTap:

self.presentCommentModule()

}

}

// Joint grabs the input and sends [Input=comment(text:)] to Pipeline

enum JointInput {

case comment(text: String)

}

private func presentCommentModule() {

let module = CommentModuleAssembly(trunk: trunk)

//note// "module" contains {view, joint}

module.joint.attach { [weak self] output in

switch output {

case .comment(let text):

self?.pipeline?.notify(input: .comment(text: text)) // <--

self?.view?.dismiss(animated: true)

}

}

self.view?.present(module.view, animated: true)

}

// Core receives [Input=comment(text:)] from Pipeline:

override func handleJoint(input: JointInput) {

switch input {

case .comment(let text):

self.state.comment = text

}

}

// Presenter receives [Input=comment(text:)] from Pipeline

// and then Presenter sends [Update=review(comment:)] to Pipeline

enum PresenterUpdate {

case review(comment: String)

}

override func handleJoint(input: JointInput) {

switch input {

case .comment:

self.pipeline?.notify(update: .review(comment: state.comment))

}

}

// View receives [Update=review(comment:)] from Pipeline

override func handlePresenter(update: PresenterUpdate) {

switch update {

case .review(let comment):

self.reviewLabel.text = comment

}

}

```

---

Где найти, как использовать, какие планы

----------------------------------------

Познакомиться более подробно с описанием паттерна, а также посмотреть примеры использования и скачать шаблоны для Xcode, можно здесь:

<https://github.com/JivoChat/RoundTable>

На момент написания статьи происходит также доработка паттерна для платформы Android, в том числе при использовании в связке с Kotlin Multiplatform. Поэтому в скором будущем репозиторий с большой вероятностью будет дополнен.

Кроме того, рассматривается вариант дальнейшей доработки паттерна для внедрения в него управляющего элемента **Coordinator**.

|

https://habr.com/ru/post/663770/

| null |

ru

| null |

# Обзор программы Heisenbug 2017 Moscow: сколько нужно тестировщиков, чтобы запустить тесты на атомной электростанции?

Вступление

==========

Как вы уже, наверное, знаете, **8-9 декабря в Москве пройдёт очередной Heisenbug**, поэтому мы решили познакомить Хабр с программой предстоящего события.

Но не так быстро! В качестве вступления — небольшая история из жизни. В конце вступления будет один мозговзрывающий факт насчёт этого хабрапоста. **Сразу за ним — подробное изложение программы**.

Почему тебе, дорогой хаброжитель, вообще стоит слушать какого-то маркетолога, который пишет эту статью? Что он может понимать в нашем нелёгком труде? За этой инфой пришлось лезть в самые тёмные глубины LinkedIn: когда-то давно, в 2010 году я устроился в одну небольшую уютную компанию в Новосибирском Академгородке на первую свою работу Java-программистом. Чтобы немножко изучить продукт, руководство поручило ответственную миссию: вручную бегать по интерфейсу нашего веб-приложения, прокликивать кнопочки и выдергивать оттуда ошибки. Довольно скоро мне поручили придумывать тест-планы, а потом и вовсе дали невероятно ответственную задачу: написать совершенно новый фреймворк для автоматического тестирования.

Как жестоко они ошиблись в моих умственных способностях! Оказалось, что тестирование — это не хухры-мухры. Ближайшие несколько месяцев пришлось изойти на кровь и пот, пытаясь взять штурмом несколько направлений: одновременно написать на Java систему удаленного выполнения тестов (открывая параллельные коннекты по SSH — сначала с помощью костыля в виде вызова Python из Java и pyexpect для ввода пароля — нельзя было авторизовываться по ключам, не спрашивайте, почему). На серверах стоял не весь нужный софт, и админы не хотели ставить нужный, поэтому пришлось написать фреймворк для сборки из исходников небольшого дистрибутива GNU прямо в домашней директории текущего пользователя. Самое чудовищное — это тесты на перформанс, я их не понимал тогда, да и не понимаю сейчас (впрочем, должен ли быть маркетолог особо умным существом? :)

Потом надо было результаты тестов собирать и визуализировать, чтобы отдавать заказчику в PDF. Как сейчас помню, я выбрал для написания и последующей визуализации фреймворк Concordion — это такой BDD-фреймворк для Java. Почему не Cucumber? Его ещё не было. Зато в Concordion было всё так красиво и изящно — тесты внедрялись прямо посреди HTML. Тестов было много, много было своей специфики, приправленной OSGi-безумием со стороны бэкенда. Разработчики меня ненавидели.

Прошли годы, и у нас появилась куча новых инструментов. В 2012 году вышел Cucumber для Java и ещё куча всякого BDD, потом весь мир захватили Селениумы и Докеры, и их влияние со временем только росло. К сожалению, я к тому времени уже ушёл из тестирования и просто со стороны молча завидовал всем этим ништякам. Ещё бы, больше тебе не нужно самому скриптовать постоянно отваливающийся SSH, ведь можно невозбранно заюзать Ansible.

Аналогичным образом изменялись и конференции для тестировщиков: люди всё больше внедряли новые инструменты и могли уже сказать что-то вразумительное. Если в самом начале люди говорили просто о попытке внедрения чего-то нового, то со временем всё больше докладов начало концентрироваться на реальных способах использования, проблемах и решениях, деталях внутреннего устройства инструментов и так далее.

То есть сами конференции качественно изменились. Теперь они о внедрении и масштабировании. Каждое второе слово — про масштабирование. Это может показаться назойливым, но, мне кажется, это хорошо — раньше о масштабировании можно было только мечтать.

Параллельно с общей эволюцией развивались и конференции JUG.ru Group. Качество докладов, организации и видеотрансляций, дискуссионные зоны.

И вот тут хочется поговорить о программе, потому что как глаза — зеркало души, так и программа — отражение окружающей действительности. Там ниже я аккуратно выпишу все основные доклады, но во вступлении — остановимся на трендах.

* **Во-первых**, нужно отметить укрепление направления мобильной разработки. Что общего у Тинькофф, Яндекс и Badoo? Они все пришли на Heisenbug 2017 Moscow. А ещё они все делают доклады про мобилки.

* **Во-вторых**, вечные темы никуда не девались. Jenkins, flaky-тесты, Selenium — от них не скрыться. Я бы сказал, творится какое-то засилье Selenium, он в каждом третьем докладе или явно, или намёками присутствует. А ещё — Docker и масштабирование. При чём тут вообще Docker? Docker — всегда при чём!

* **В-третьих**, есть и довольно нестандартные темы. Вячеслав Аленьков [расскажет про тестирование в Росатоме](https://heisenbug-moscow.ru/talks/2017/msk/2p3ugzjvbucmsgy86qask6/), точнее — про цифровой запуск АЭС (атомных электростанций). Как вам такой стандарт качества? Рома Поборчий [с докладом про A/B тестирование](https://heisenbug-moscow.ru/talks/2017/msk/g6ie0nvjae06wge04iayk/) даст возможность почувствовать себя немножечко data scientist'ами. А ещё у нас есть отличный [доклад Александра Шукова из World of Tanks](https://heisenbug-moscow.ru/talks/2017/msk/31zwck9sa4goccu0ygo2qq/), внезапно, про World of Tanks. Уже интуитивно понятно, что в такой популярной игре всё должно быть на очень хорошем уровне, на их примере стоит поучиться. Эти люди рассказывают не о внедрении какой-то новой хипстерской технологии, а об успешном решении проблем в крупных проектах, и решения эти проверены временем и репутацией.

У меня закончились точки-буллеты в списке, поэтому ещё пара интересного в один абзац! На конференциях JUG.ru Group традиционно проводятся [доклады со всевозможными паззлерами](https://jokerconf.com/2017/talks/4w63aqdj4saeooguiamo6w/) — вот и [до нас они добрались](https://heisenbug-moscow.ru/talks/2017/msk/74qfnsvag4gcsi4sw8gyoi/). Доклад с паззлерами будет в самом начале, утром, и кто привык просыпаться не благодаря кофе, а с помощью интересных задачек — милости просим.

Конечно, доклады читают проверенные временем спикеры вроде [Николая Алименкова](https://heisenbug-moscow.ru/talks/2017/msk/1jtizrll7mqmscigqqoeqo/) и [Артема Ерошенко](https://heisenbug-moscow.ru/talks/2017/msk/3dbmqkrm5waqwummcu44ea/). У Артема архитектурный доклад про тесты, таких докладов не так много бывает.

А ещё на этой конференции будут реальные звёзды, знаменитости: [Саймон Стюарт](https://heisenbug-moscow.ru/talks/2017/msk/4axfxghfmo0ke0oyyack6g/) (человек, являющийся живым воплощением Selenium на Земле) и [Алан Пейдж](https://heisenbug-moscow.ru/talks/2017/msk/65awpkh6vyyquuy0kgk0ww/) (бывший директор по тестированию в Microsoft, действующий директор по качеству в Unity).

Ну и конечно, в конце будет знатное афтепати! С жидкостями для принятия внутрь, музыкой, тёплыми ламповыми беседами — всё как положено. Просто приходите, будет круто.

Интересный момент: раньше на нас жутко ругались, что мы сразу после закрытия конференции берём спикеров и куда-то уводим. И в результате, на вечеринке не оставалось почти ни одного спикера. На самом деле, в этом есть смысл: кому-то надо прийти в себя после напряженного доклада, у кого-то через час самолёт. Но и в твоем возмущении, дорогой читатель, есть большая доля смысла, и вообще — клиент всегда прав. Поэтому в этот раз мы постараемся, чтобы спикеры пришли на вечеринку и употребляли жидкости вместе с нами. Гарантий дать не могу, мы но постараемся.

Немного дичи об этом посте

--------------------------

Вообще, если человек однажды научился писать код (например, код тестов), от осознания этой своей силы он портится. Становится хитрым ленивым существом, желающим автоматизировать всё, что видит. Если есть тест — его надо автоматизировать! Если есть пост — его эээ… тоже надо автоматизировать!

В ходе написания этого поста мне пришлось перелопатить всю программу конференции — кое-где переформулировать описания докладов, перевести на русский язык английские тексты, превратить полученный объём данных в хабрапост и так далее. Для этого нужно получить данные о докладах в структурированном виде. Такие данные лежат у нас на сайте в разделе «программа», и я мог бы легко взять их из базы. Если бы позаботился об этом с вечера! Дело в том, что я писал этот пост глубокой ночью, когда грехи наиболее сильно скребут душу, и строчки ложатся на бумагу наиболее гладко. В этот час админы спят, и если бы я разбудил админа с просьбой дать дамп базы, разговор получился бы, прямо скажем, напряженным.

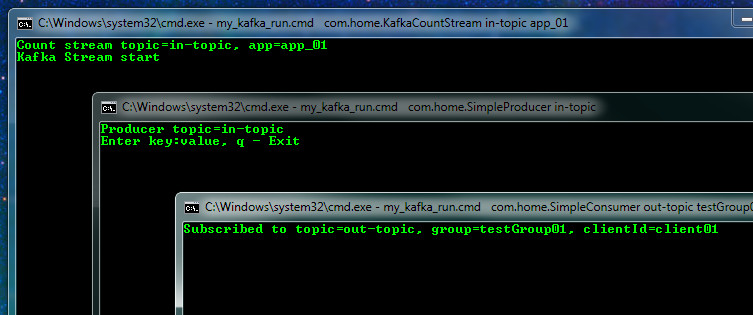

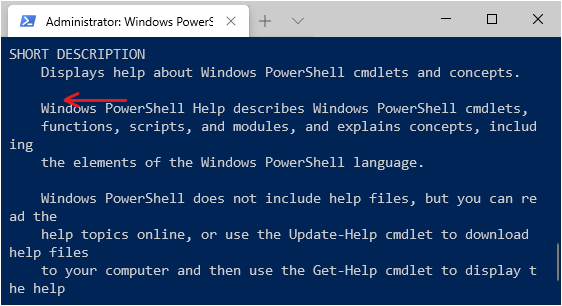

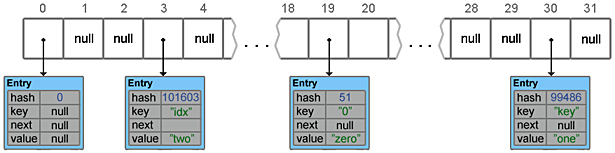

Поэтому я взял в руки вебдрайвер и написал простенький скрейпер таблиц с нашего сайта! Принцип его действия простой:

* стартует с помощью `SpringBoot` (проект сгенерирован с помощью `Spring Initializr` — очень важно быть ленивым),

* он скачивает страничку (с помощью `jbrowserdriver`),

* потом все странички всех докладов по ссылкам,

* аккуратно парсит всё это (в джавовые объекты типа `Talk` — объект «Доклад» с полями типа «спикер», «компания, в которой он работает», и т.п.),

* и все фотографии спикеров сохраняет на жесткий диск,

* применяет патчи с переводами с русского на английский (простой мердж `ArrayList` в Java),

* трансформирует это в Markdown (с помощью шаблонизатора `Velocity` — да, я поклонник старины),

* и на выход формирует текстовый markdown-файл для дальнейшей обработки.

Пара заметок. Вначале я пытался использовать `Unirest` + `jSoup`, но получился какой-то трэш. То ли у нас сильно умный JavaScript сидит на сайте, то ли в jSoup баги, но в четыре утра заниматься их поиском не хотелось. А вот `JBrowserDriver` оказался довольно стабильной штукой и нормально отдает DOM, полученный сразу после всех трансформаций, выполняемых браузером после загрузки страниц. Картинки сохраняются на жесткий диск, а не напрямую на HabraStorage, потому что Хабр не дает токен API, а хакать их API поперек их воли — некрасиво. Запуск тестировался относительно Java 9 с параметром `--add-opens java.base/java.lang=ALL-UNNAMED` и Java 8.

Результаты этой бессмысленной и беспощадной работы можно посмотреть [у меня на GitHub](https://github.com/olegchir/heisenbug2017moscow-parser).

Главный факап оказался в том, что я не подумавши начал писать это без тестов. В результате изначальная оценка проекта по написанию парсера + получению исходника статьи из 20 минут быстро превратилась в 2 часа.

Стыдно, очень стыдно. Это Олег, и он криворукий. Не будь как Олег, **всегда пиши юнит-тесты**! Особенно, когда разрабатываешь подобие компилятора (даже такого простого, как парсер веб-странички). С другой стороны, должен ли сотрудник отдела маркетинга быть умным существом? Короче, мне простительно. А вам — нет, так-то!

На этой жизнеутверждающей ноте переходим к самому главному — к программе!

Программа

=========

День первый. 8 декабря.

-----------------------

[Тестирование браузерной производительности веб-приложений (JavaScript, rendering, вот это всё)](https://heisenbug-moscow.ru/talks/2017/msk/ik9jansi0gykw2egosq2c/)

-------------------------------------------------------------------------------------------------------------------------------------------------------------------

**Владимир Ситников**/Netcracker

Часто под словом «тестирование производительности» подразумевают только тестирование серверной части. Гораздо реже тестируют непосредственно работу браузера. В простом случае подключаем Яндекс.Метрику и/или Google Analytics, и вперёд. Но есть нюанс: в корпоративной среде отправка данных в ЯМ/GA может быть недоступна, да и простого подключению ЯМ/GA недостаточно, чтобы собирать нужное количество информации о производительности приложения. В докладе мы рассмотрим то, как измерять длительность операций в браузере. Узнаем, почему времена, получаемые от Selenium, показывают погоду, узнаем, какая польза от Selenium-тестов может быть при замерах производительности. Посмотрим на boomerang.js и узнаем, на какие моменты обращать внимание при интеграции подобных библиотек в проект. Доклад не затрагивает вопросы оптимизации браузера/сервера.

**Владимир Ситников**

Десять лет работает над производительностью и масштабируемостью NetCracker OS — ПО, используемого операторами связи для автоматизации процессов управления сетью и сетевым оборудованием. Увлекается вопросами производительности Java и Oracle Database. В его обязанности входит планирование нагрузочных замеров, анализ и объяснение полученных результатов. Владимир является commiter’ом в Apache JMeter.

---

[Selenide Puzzlers](https://heisenbug-moscow.ru/talks/2017/msk/74qfnsvag4gcsi4sw8gyoi/)

---------------------------------------------------------------------------------------

**Алексей Виноградов**/Radio QA; **Андрей Солнцев**/Codeborne